Microsoft ha annunciato Maia 200, il nuovo acceleratore per l’inferenza che rappresenta una tappa chiave nella strategia end-to-end dell’azienda per l’intelligenza artificiale. Pensato per spostare radicalmente l’economia dell’AI su larga scala, Maia 200 punta a rendere l’esecuzione dei modelli più veloce ed economicamente sostenibile all’interno dei data center Azure.

Indice degli argomenti:

Prestazioni e costi ottimizzati

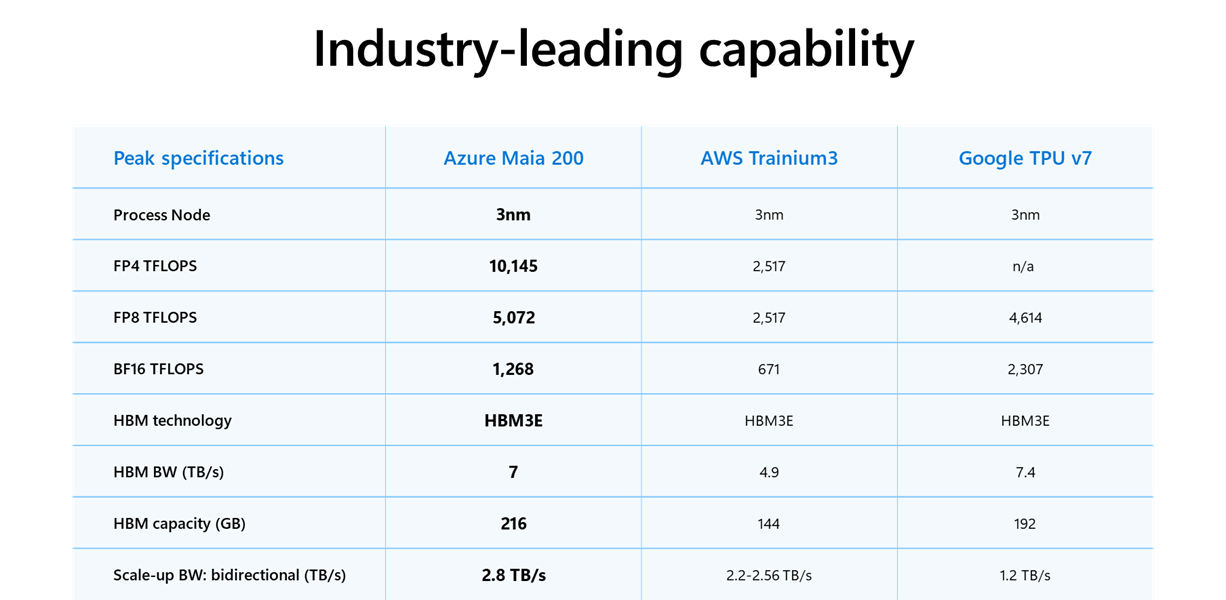

Realizzato con processo produttivo TSMC a 3 nanometri, Maia 200 integra core tensoriali FP8 e FP4 nativi, un sistema di memoria ridisegnato con 216 GB di HBM3e a 7 TB/s e 272 MB di SRAM on-chip. Secondo Microsoft, il chip offre tre volte le prestazioni FP4 del Trainium di terza generazione di Amazon e supera la settima generazione di TPU di Google in FP8, garantendo un miglioramento del 30% nel rapporto prestazioni/prezzo rispetto alle soluzioni precedenti.

Progettato specificamente per l’inferenza AI

Ogni chip supera i 100 miliardi di transistor ed è ottimizzato per il calcolo a bassa precisione, con oltre 10 petaFLOPS in FP4 e circa 5 petaFLOPS in FP8. Questo consente a un singolo nodo Maia 200 di eseguire i modelli AI più grandi oggi disponibili, lasciando margine per le generazioni future. L’architettura riduce inoltre i colli di bottiglia nel trasferimento dati, mantenendo localmente pesi e informazioni critiche.

Memoria e dati al centro dell’architettura

Microsoft ha puntato su un sottosistema di memoria progettato intorno a formati a precisione ridotta, motori DMA dedicati, SRAM on-die e una rete interna ad alta banda. L’obiettivo è ridurre il numero di dispositivi necessari per far girare un modello, migliorando efficienza e utilizzo delle risorse nei data center.

Networking unificato e scalabilità cloud

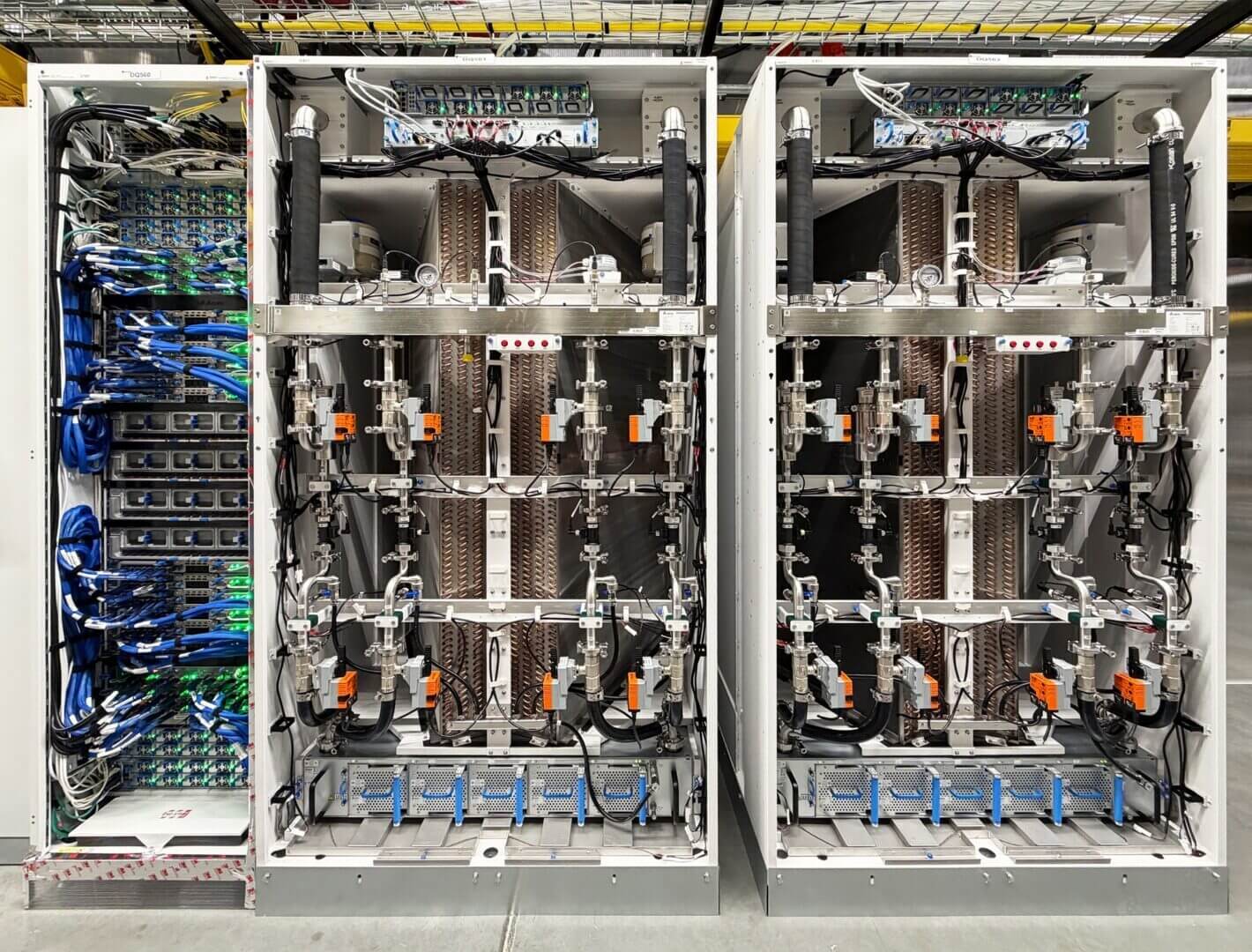

A livello di sistema, Maia 200 introduce un’architettura di scale-up a due livelli basata su Ethernet standard. Ogni acceleratore offre 1,4 TB/s di banda dedicata e supporta operazioni collettive prevedibili su cluster fino a 6.144 acceleratori. La rete unificata, valida dal singolo nodo fino al cluster globale, semplifica la programmazione e riduce costi energetici e TCO per Azure.

Sviluppo agile e time-to-market accelerato

Il progetto Maia 200 nasce da un approccio che privilegia simulazione ed emulazione già nelle fasi iniziali. Microsoft ha validato hardware, rete e software molto prima dell’arrivo del primo silicio fisico, riducendo drasticamente i tempi di distribuzione nei data center. I primi modelli AI hanno iniziato a girare su Maia 200 pochi giorni dopo l’arrivo dei chip, dimezzando i tempi rispetto a programmi comparabili.

Dai laboratori ai prodotti Microsoft

Il primo utilizzo di Maia 200 sarà affidato al team Microsoft Superintelligence per generazione di dati sintetici e reinforcement learning. L’acceleratore verrà poi impiegato in Microsoft Foundry e in Microsoft 365 Copilot, entrando a far parte dell’infrastruttura AI eterogenea globale dell’azienda, con una futura disponibilità estesa anche ai clienti.

Il futuro del programma Maia

Maia 200 è solo l’inizio di un programma pensato per essere multigenerazionale. Microsoft sta già lavorando alle prossime evoluzioni, con l’obiettivo di fissare nuovi standard in termini di prestazioni ed efficienza.

In parallelo, l’azienda ha aperto la preview del Maia SDK, invitando sviluppatori, ricercatori e community open source a iniziare l’ottimizzazione dei modelli sulla nuova piattaforma.