Nello scenario locale e globale, l’intelligenza artificiale è protagonista non solo dell’innovazione, ma anche delle minacce informatiche.

È al centro di una nuova corsa alla sicurezza, dove vulnerabilità, attacchi e difese si evolvono in parallelo. La sfida è costruire e sviluppare sistemi resilienti, sicuri “per progettazione” (Secure by design) – anziché lasciare i difensori in costante attività di reazione –, capaci di affrontare rischi sempre più sofisticati e agenti sempre più autonomi.

In un panorama in rapida evoluzione, l’AI è al tempo stesso risorsa e bersaglio. Qualche esempio: il 93% dei responsabili della sicurezza IT aziendale, cioè quasi tutti, prevede entro l’anno attacchi quotidiani basati su sistemi AI. Mentre il 66% delle imprese e organizzazioni ritiene che l’intelligenza artificiale avrà l’impatto più significativo sulla cybersicurezza nel 2025.

Indice degli argomenti:

Il mix esplosivo di opportunità e minacce

Effetti, tendenze e sviluppi sono tracciati nell’ultimo studio di Trend Micro sullo stato della sicurezza dedicato al settore ‘State of AI Security Report’. Il rapporto sottolinea: “un terremoto silenzioso sta ridefinendo i confini della sicurezza digitale globale. L’AI, l’innovazione che promette efficienza e crescita, si rivela un’arma a doppio taglio, determinando anche un panorama di minacce senza precedenti”.

In un quadro “di estrema vulnerabilità”, il futuro della difesa informatica “non è più solo una questione di software, ma di vera e propria battaglia tra intelligenze artificiali”. Quelle ‘buone’ e costruttive contro quelle ‘cattive’ e malevole. Un binomio e una contrapposizione che ritornano e che si replicano anche nel mondo delle nuove tecnologie più sofisticate.

La ragione di questo allarme è la natura duale dell’AI: la sua “ampia utilità genera guadagni in efficienza per le aziende, ma allo stesso tempo arma gli operatori delle minacce, fornendo loro strumenti di Hacking avanzatissimi e scalabili”.

Punti deboli e contromisure

Una parte dell’analisi ha preso le mosse dal Pwn2Own Berlin 2025, competizione internazionale di hacking che ha introdotto per la prima volta una categoria dedicata all’AI. Quando, in soli tre giorni, sono state scoperte 28 vulnerabilità zero-day, sette delle quali riguardavano infrastrutture di artificial intelligence.

Tra i bersagli principali: Chroma DB, database vettoriale open-source, che è stato violato sfruttando artefatti residui del processo di sviluppo. Trend Micro ha rilevato oltre 200 server Chroma completamente esposti, accessibili senza autenticazione.

Nvidia Triton Inference Server è stato attaccato con una catena di quattro bug, evidenziando la fragilità dei sistemi complessi e la necessità di una gestione proattiva delle patch.

Redis, importante archivio key-value, è stato compromesso attraverso una vulnerabilità “Use-after-free” legata al sottosistema Lua, evidenziando i rischi dell’utilizzo di componenti obsoleti.

Nvidia Container Toolkit ha mostrato falle nella gestione delle variabili di inizializzazione, sottolineando l’importanza di validare gli input esterni nei sistemi containerizzati.

Agenti AI e attacchi cyber

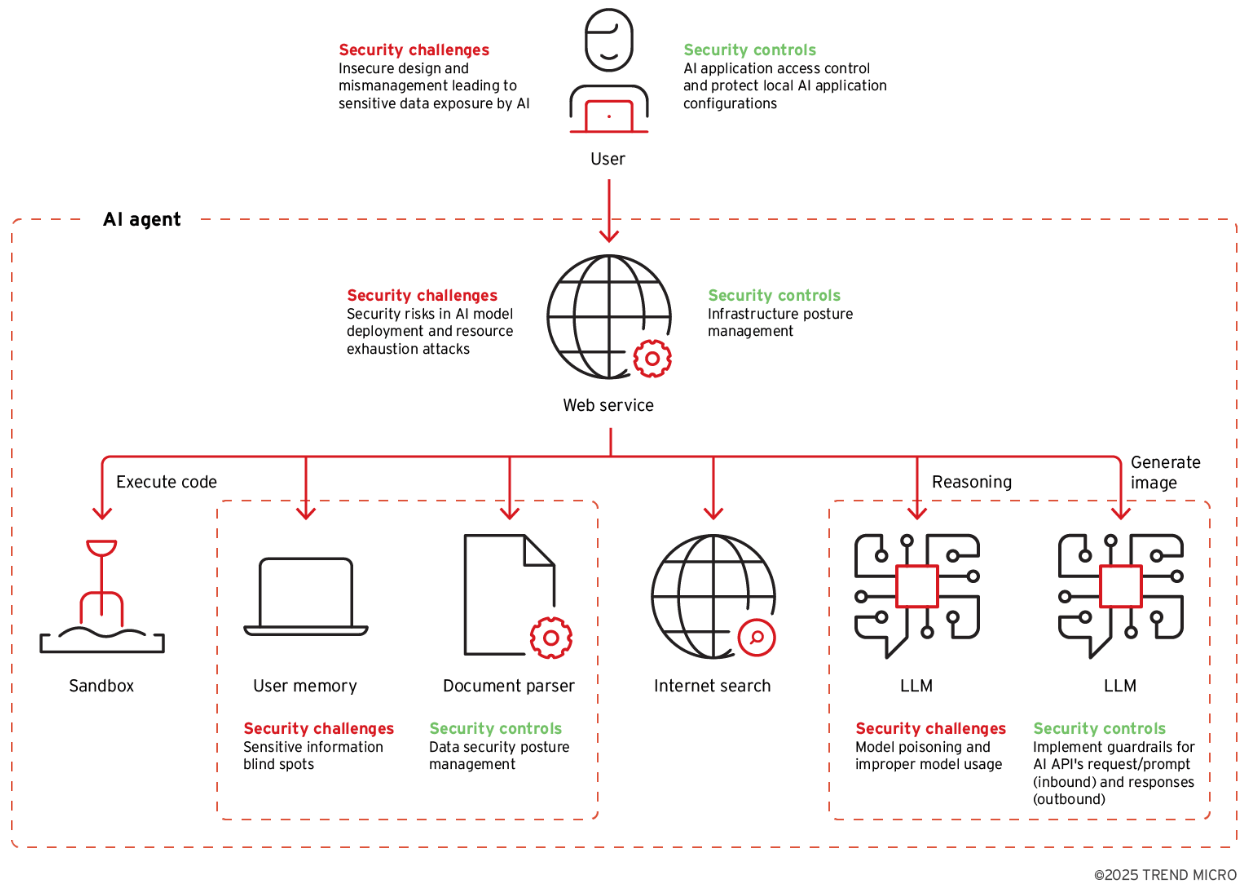

Lo studio di Trend Micro analizza anche le minacce specifiche agli agenti AI, sistemi capaci di ragionamento autonomo e interazione con strumenti esterni. L’obiettivo è manipolare l’agente autonomo per accedere a dati sensibili o per indurlo a compiere azioni dannose.

Per esempio, Trend Micro ha sviluppato Pandora, un agente AI sperimentale, per testare scenari di attacco.

Tra le tecniche e le minacce emerse:

- prompt injection indiretta, dove istruzioni malevole vengono nascoste in contenuti caricati dall’agente.

- Query SQL non sicure, generate dall’agente durante l’interazione con database.

- Manipolazione dei database vettoriali, con iniezione di dati fuorvianti che alterano il comportamento dell’AI.

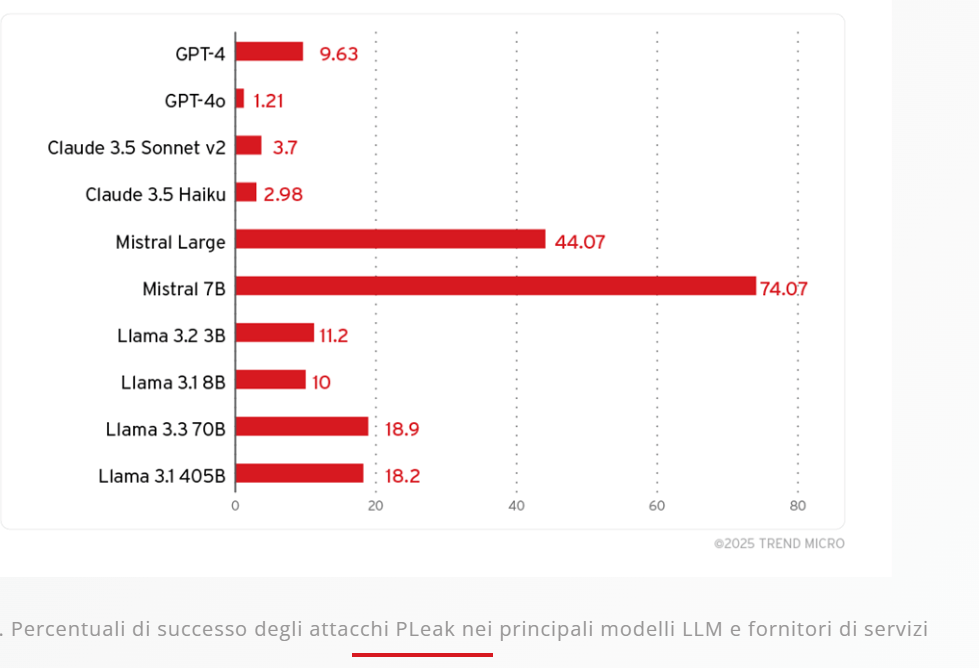

Modelli come DeepSeek-R1, che espongono il proprio Chain of Thought (CoT), risultano particolarmente vulnerabili a prompt evoluti e attacchi di tipo link trap, dove l’AI è indotta a condividere URL malevoli. Altri metodi includono l’uso di caratteri Unicode invisibili per bypassare i controlli, e tecniche come prompt leakage, che rivelano istruzioni di sistema e dati sensibili.

AI anche al servizio del crimine

L’intelligenza artificiale non è solo bersaglio: è anche strumento per i cybercriminali. Il report documenta l’uso di AI per:

- phishing multilingue, attraverso la traduzione automatica e contestualizzazione culturale.

- deepfake, impiegati in truffe e frodi aziendali. Il 36% delle aziende utenti Trend Micro ha subito tentativi di truffa con contenuti Deepfake.

- bypass dei sistemi eKYC, con video e immagini contraffatte per creare identità false e riciclare denaro su piattaforme crypto.

Nonostante la proliferazione di ‘criminal GPTs’, come WormGPT e BlackhatGPT, l’adozione resta limitata. I criminali preferiscono sistemi jailbreak-as-a-service, che consentono di aggirare i filtri etici dei modelli commerciali.

Difendersi nell’era degli agenti AI

Con l’avanzare dell’AI agentica – sistemi molto sofisticati capaci di apprendere, agire e persino creare altri agenti – la sicurezza deve evolversi rapidamente. Le difese perimetrali tradizionali non bastano: servono meccanismi di fiducia, monitoraggio continuo e protezione dell’intera filiera AI, dai modelli ai plugin.

Trend Micro propone una ‘AI Security Blueprint’ con raccomandazioni architetturali e controlli multilivello per proteggere dati e integrità operativa.

Tra le soluzioni emergenti, spicca Trend Cybertron, agente AI lanciato nel marzo scorso, integrato nella piattaforma Vision One. Cybertron può analizzare ambienti complessi, automatizzare la risposta agli incidenti e condividere Intelligence con la comunità globale. Alcuni suoi componenti sono open-source, a beneficio di sviluppatori e ricercatori.

Verso il futuro: quantum e digital assistant

Lo studio di scenario guarda anche oltre: l’AI agentica sarà probabilmente gestita da assistenti digitali di nuova generazione, capaci di orchestrare più agenti per compiti complessi. Questi assistenti, però, ampliano la superficie d’attacco, soprattutto se integrano plugin di terze parti. La protezione di questi sistemi diventerà cruciale.

Trend Micro esplora anche le frontiere della crittografia quantistica e del quantum machine learning, con iniziative come CUDA-Q e l’Accelerated Quantum Research Center. Sebbene ancora agli inizi, queste tecnologie potrebbero ridefinire gli standard di sicurezza nei prossimi anni.

Alcune best practice

L’analisi del settore indica come best practice l’adozione di un approccio metodico e proattivo.

Per esempio:

- mantenere un inventario aggiornato di tutti i componenti software, comprese le librerie di terze parti e i sottosistemi.

- Eseguire valutazioni di sicurezza periodiche dell’intero ecosistema AI.

- Integrare misure di sicurezza in ogni fase del ciclo di vita dell’AI (AI Lifecycle), per anticipare le vulnerabilità che potrebbero emergere e presentarsi.

Gli specialisti di Trend Micro concludono: “il tempo dell’esitazione è finito. La sicurezza nell’era dell’AI non è un accessorio, ma la spina dorsale necessaria per garantire che questa tecnologia, che promette di trasformare il mondo, non diventi la più grande vulnerabilità della nostra epoca”.