Con l’aumento generalizzato dell’adozione di soluzioni di intelligenza artificiale, sia i consumatori che le autorità di regolamentazione si aspettano una maggiore trasparenza sul funzionamento di questi sistemi. Ad agosto 2022 il National Institute of Standards and Technology (NIST) ha pubblicato una bozza ampliata per il suo quadro di gestione del rischio AI (Risk Management Framework – RMF) che mira ad “affrontare i rischi nella progettazione, sviluppo, utilizzo e valutazione di prodotti, servizi e sistemi di intelligenza artificiale”.

La seconda bozza si basa sulla versione iniziale di marzo 2022 del RMF e su un documento concettuale di dicembre 2021. I commenti sulla bozza sono previsti entro il 29 settembre.

Il passo del NIST verso un’AI affidabile

Il nuovo framework del NIST fornisce alle organizzazioni parametri che possono utilizzare per valutare l’affidabilità delle soluzioni di intelligenza artificiale che utilizzano quotidianamente.

L’importanza di questo non può essere sottovalutata, in particolare quando regolamenti come il Regolamento generale sulla protezione dei dati (GDPR) dell’UE danno agli interessati il diritto di chiedere perché un’organizzazione ha preso una particolare decisione.

Sebbene l’RMF non imponga le best practice per la gestione dei rischi dell’AI, inizia a codificare come un’organizzazione può iniziare a misurare il rischio di implementazione dell’intelligenza artificiale.

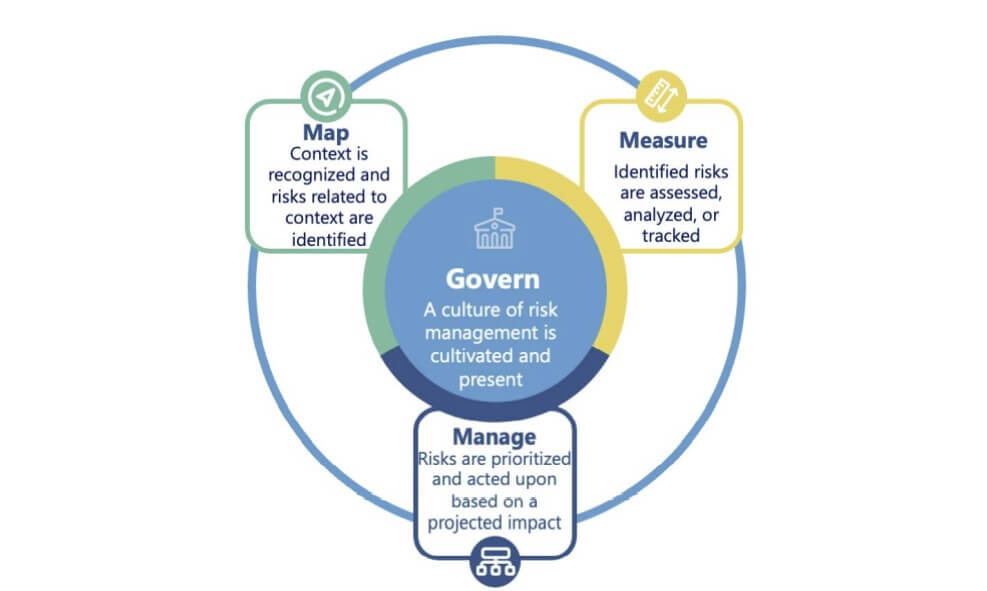

Le funzioni organizzano le attività di gestione del rischio AI al massimo livello per governare, mappare, misurare e gestire i rischi AI. La governance è una funzione trasversale che informa le altre funzioni del processo (Fonte: NIST)

Limiti dell’RMF

Il quadro di gestione del rischio RMF del NIST è una buona novità per supportare i controlli interni dell’impresa, ma c’è ancora molta strada da fare prima che il concetto di rischio nell’AI sia universalmente compreso.

In questo senso, le organizzazioni che utilizzano il framework dovrebbero avere aspettative realistiche su ciò che il framework può e non può raggiungere. Si tratta di uno strumento per identificare quali sistemi di intelligenza artificiale vengono implementati, come funzionano e il livello di rischio che presentano (cioè, se sono affidabili o meno).

Il RMF include linee guida sulle azioni suggerite, i riferimenti e la documentazione che consentiranno alle parti interessate di adempiere alle funzioni “map” e “govern”. La versione finalizzata includerà informazioni sulle restanti due funzioni del RMF – “measure” e “manage” – sarà rilasciata a gennaio 2023.