La corsa verso modelli di intelligenza artificiale più efficienti sta evidenziando una tensione crescente tra chi sviluppa tecnologie avanzate e chi cerca di sfruttare nuovi approcci per ottenere risultati paragonabili ma a costi più contenuti. La distillazione, tecnica non certo nuova ma sempre più diffusa per alleggerire e ridurre le risorse necessarie per l’addestramento dei modelli di AI (LLM), si è recentemente trasformata in un terreno di scontro tra le aziende che puntano all’ottimizzazione delle risorse computazionali e quelle che temono una perdita di difendibilità dei loro costosi modelli.

Da un lato, la distillazione dei LLM consente di trasferire conoscenze da reti neurali più grandi e complesse a versioni più leggere, riducendo decisamente i costi di addestramento e il relativo peso energetico.

Dall’altro, le grandi aziende produttrici di LLM temono che questa tecnica possa facilitare la replica non autorizzata delle loro soluzioni più avanzate, riducendo il vantaggio competitivo. Tutto ciò non fa che intensificare la perenne contrapposizione fra innovazione aperta e tutela del patrimonio tecnologico aziendale.

Indice degli argomenti:

La distillazione: una scorciatoia per modelli più efficienti

La distillazione consente di trasferire conoscenze da modelli di grandi dimensioni garantendo capacità simili o leggermente inferiori a fronte però di un minor consumo di risorse computazionali.

Alla base della distillazione dei LLM si trova il paradigma teacher-student, un approccio in cui un modello di grandi dimensioni, detto teacher (insegnante), trasferisce la propria conoscenza a un modello più piccolo, denominato student. L’obiettivo è ottenere una versione compatta del modello originario che riesca a replicarne le prestazioni con un consumo computazionale notevolmente ridotto.

A livello pratico, questo processo si basa su una serie di tecniche avanzate che permettono al modello student di apprendere non solo le risposte corrette, ma anche le sfumature probabilistiche, i pattern semantici e le strutture linguistiche acquisite dal modello teacher.

Le sfumature probabilistiche

Quando parliamo di sfumature probabilistiche ci riferiamo alla capacità del modello teacher di esprimere in modo graduale il proprio grado di certezza rispetto a un’ampia gamma di risposte possibili, anziché limitarsi a un’unica soluzione netta. A differenza di un’assegnazione binaria di etichette (dove una risposta è semplicemente corretta o errata), i modelli avanzati generano distribuzioni di probabilità che riflettono la loro sicurezza su diverse interpretazioni di un input.

Durante la distillazione del LLM, il modello student non si limita a memorizzare la risposta corretta determinata dal teacher, ma apprende anche come e perché il teacher assegna un certo livello di confidenza alle diverse opzioni. Questo aspetto è rilevante perché consente al modello più piccolo di sviluppare un processo decisionale più sofisticato, evitando risposte eccessivamente rigide o dogmatiche.

Un esempio

Per fare un esempio, se consideriamo la domanda “Chi ha teorizzato l’evoluzione per selezione naturale?” un modello tradizionale supervisionato potrebbe semplicemente restituire: “Charles Darwin (100% corretto)”. Un LLM ben addestrato, invece, potrebbe fornire una distribuzione più articolata, come ad esempio: “Charles Darwin (85%), Alfred Russel Wallace (10%), Jean-Baptiste Lamarck (4%), Gregor Mendel (1%)”. Questa distribuzione mostra che Darwin è di gran lunga l’opzione più probabile, ma include anche Wallace, che sviluppò un’idea simile indipendentemente, e Lamarck, che propose un’ipotesi precedente sull’evoluzione.

Un modello student addestrato su etichette rigide potrebbe rispondere esclusivamente con “Charles Darwin” senza considerare altri contesti, mentre uno student addestrato attraverso distillazione potrebbe riconoscere che Wallace merita di essere menzionato in alcune circostanze. Di conseguenza, lo student non solo eredita la conoscenza del teacher, ma ne assorbe anche la struttura interpretativa, imparando a navigare le ambiguità invece di fornire risposte nette prive di contesto.

Questo lo rende molto più utile in applicazioni che richiedono flessibilità cognitiva, come chatbot avanzati, sistemi di risposta automatica e motori di ricerca intelligenti.

I pattern semantici

I pattern semantici rappresentano le relazioni ricorrenti tra parole, concetti e strutture linguistiche che emergono nei testi e che un modello di linguaggio apprende durante l’addestramento. Durante la distillazione, il modello student non acquisisce solo il significato letterale delle frasi, ma anche le associazioni latenti tra termini che il teacher ha già elaborato attraverso il suo training su enormi quantità di dati.

Questo gli permette di riconoscere, ad esempio, che “capitale della Francia” è semanticamente equivalente a “Parigi”, o che un’espressione come “ha alzato bandiera bianca” è un sinonimo figurato di “si è arreso”.

Un esempio pratico di apprendimento dei pattern semantici si osserva nel trattamento delle domande implicite. Se un utente chiede “Quale città è nota come la Grande Mela?”, un modello student addestrato con distillazione non si limita a restituire “New York”, ma riconosce anche che l’espressione idiomatica “Grande Mela” evoca implicitamente la vivacità culturale, economica e sociale che caratterizza la città, identificandone così non solo il nome letterale ma anche il contesto semantico sottostante.

Questo tipo di apprendimento consente allo student di fornire risposte più naturali, interpretare varianti linguistiche e adattarsi a richieste meno rigide, avvicinandosi alle capacità inferenziali del teacher senza necessitare della stessa quantità di parametri.

Le sfumature linguistiche

Le sfumature linguistiche si riferiscono alla capacità di cogliere variazioni di tono, registro, implicazioni e sottintesi all’interno di un testo o di una conversazione. Durante la distillazione del LLM, il modello student apprende dal teacher non solo il significato diretto delle parole, ma anche il modo in cui esse vengono usate in contesti diversi, distinguendo tra espressioni formali, colloquiali o magari ironiche. Questo permette di migliorare la qualità delle risposte, adattandole in base al contesto comunicativo.

Per esempio, se un utente chiede “Ehi, ma il Titanic ha scelto il percorso panoramico o ha fatto una deviazione imprevista?”, un modello meno sofisticato potrebbe limitarsi a una risposta diretta come “No, è affondato nel 1912”, mentre un modello distillato da un teacher avanzato potrebbe cogliere il tono umoristico della domanda e rispondere con “Diciamo che il viaggio inaugurale non è andato esattamente secondo i piani”.

Questo tipo di comprensione permette allo student di adattarsi meglio alle sfumature linguistiche del parlante, restituendo risposte più naturali e contestualizzate.

Tecniche di distillazione

Per ottenere un modello student che possa replicare, almeno in parte, le capacità di un teacher più grande, la distillazione si basa su un insieme di tecniche progettate per trasferire la conoscenza in modo efficiente. Ogni tecnica si concentra su un aspetto specifico del processo di apprendimento, dalla semplice imitazione degli output fino alla riproduzione delle attivazioni interne del modello più grande.

Distillazione basata sui logit: apprendere dalle probabilità del teacher

Uno degli approcci più diffusi è la distillazione basata sui logit, che sfrutta la distribuzione di probabilità generata dal teacher per ciascuna possibile risposta. Questo metodo consente allo student di apprendere non solo quale sia la risposta più probabile, ma anche il livello di confidenza del teacher sulle alternative, come già visto negli esempi precedenti.

In pratica, invece di addestrare il modello student con risposte rigide (dove una sola opzione è considerata corretta), si insegna a replicare la distribuzione probabilistica del teacher. Per migliorare il processo di trasferimento, si utilizza un parametro chiamato temperatura, che controlla quanto i valori di probabilità devono essere “ammorbiditi”. Temperature più alte appiattiscono la distribuzione di probabilità, rendendo i valori più uniformi tra loro e consentendo allo student di cogliere meglio anche opzioni meno probabili.

Temperature più basse, invece, accentuano i picchi della distribuzione, concentrando l’attenzione sulle risposte più probabili. Questo bilanciamento è necessario per consentire allo student di apprendere sia le risposte dominanti sia le relazioni più sottili tra le alternative.

Ad esempio, se il teacher assegna il 90% di probabilità a una risposta e il 10% a un’alternativa vicina, lo student apprende che quest’ultima non è del tutto sbagliata e potrebbe essere pertinente in determinati contesti. Un approccio, questo, che migliora la capacità del modello distillato di ragionare su ambiguità, sinonimie e sfumature semantiche.

Distillazione basata sulle feature: replicare le rappresentazioni interne

Mentre la distillazione dei LLM basata sui logit si concentra sulle risposte finali, la distillazione basata sulle feature si occupa di trasferire le informazioni contenute nei livelli intermedi del teacher. Durante l’addestramento, i modelli di grandi dimensioni costruiscono rappresentazioni interne che catturano schemi e relazioni tra le parole. Il metodo prevede che il modello student non impari solo a dare risposte simili al teacher, ma anche a sviluppare un modo simile di elaborare le informazioni.

Questo perché se lo student riesce a replicare queste rappresentazioni può migliorare la propria capacità di generalizzazione anche con una struttura più compatta. Per fare ciò, si confrontano le attivazioni interne dei due modelli e si cerca di ridurre le differenze.

Tuttavia, poiché le architetture del teacher e dello student sono generalmente diverse in dimensioni e struttura, questo confronto diretto non è immediato e richiede l’introduzione di layer di mappatura o tecniche di trasformazione che rendano compatibili le rappresentazioni intermedie. Se lo student riesce a imitare in maniera sufficientemente fedele tali schemi, acquisisce parte della capacità di astrazione del teacher, risultando più efficace su compiti complessi.

Questa tecnica è particolarmente utile per compiti che richiedono una comprensione profonda del linguaggio, come la generazione di testi coerenti o la comprensione del significato implicito di una frase. Il problema principale di questo approccio è la difficoltà nel selezionare quali livelli del teacher trasferire allo student.

I modelli di grandi dimensioni contengono molteplici strati di elaborazione, ognuno con una funzione specifica nel processo di apprendimento e comprensione del linguaggio. Alcuni livelli catturano informazioni come le relazioni sintattiche tra le parole, mentre altri si concentrano su strutture semantiche più astratte.

Decidere quali di questi livelli siano più rilevanti per la distillazione è una sfida non banale, poiché il trasferimento indiscriminato di tutte le attivazioni interne potrebbe introdurre rumore anziché migliorare la qualità del modello student.

Distillazione progressiva: apprendimento in più fasi

La distillazione progressiva dei LLM suddivide il trasferimento della conoscenza in più passaggi successivi. Invece di comprimere direttamente un modello di grandi dimensioni in uno molto più piccolo, si utilizza una strategia graduale: inizialmente, non si tenta di ridurre drasticamente le dimensioni del modello, ma si crea una versione intermedia del teacher, che conserva gran parte della sua struttura ma con un numero inferiore di parametri.

Questa prima versione semplificata funge da ponte tra il modello originale e lo student finale, che viene così addestrato partendo da questo modello intermedio, anziché direttamente dal teacher più grande.

Una volta che lo student ha appreso le informazioni fondamentali da questa prima fase di addestramento, il processo di riduzione continua progressivamente.

Ogni nuovo passaggio riduce ulteriormente la complessità del modello, eliminando livelli meno rilevanti e comprimendo le informazioni essenziali in un’architettura sempre più compatta. Questo metodo aiuta a mitigare la perdita di informazioni che può verificarsi quando si passa direttamente da un modello molto grande a uno molto più piccolo. Il risultato è uno student che, pur essendo più leggero, riesce a mantenere prestazioni più vicine a quelle del modello originario.

Si tratta di una tecnica particolarmente efficace nei modelli generativi e nei sistemi che devono conservare capacità di ragionamento avanzato, come quelli usati per risolvere problemi matematici o per produrre testi articolati, se non fosse per le complessità che introduce nella gestione dell’addestramento.

A differenza della distillazione tradizionale, che avviene in un’unica fase, la distillazione progressiva richiede infatti di definire con precisione il numero e la natura dei passaggi intermedi. Stabilire quante fasi di riduzione siano necessarie e come bilanciare il trasferimento della conoscenza tra un livello e l’altro è un aspetto non banale, poiché un numero eccessivo di passaggi può rallentare l’addestramento, mentre una riduzione troppo rapida può compromettere la qualità del modello finale.

Gestione della stabilità

Un altro problema è la gestione della stabilità durante il processo. Ogni fase intermedia introduce un nuovo modello student, che deve essere ottimizzato prima di poter essere ulteriormente ridotto. Se in una di queste fasi il modello perde informazioni essenziali, il danno può propagarsi ai livelli successivi, portando a una perdita di qualità nelle risposte dello student finale.

Per evitare questo problema, è spesso necessario implementare strategie di regolarizzazione, come il knowledge retention loss, che penalizza il modello se perde troppa informazione rispetto alla fase precedente.

Distillazione multi-teacher: apprendere da più fonti

Un’altra tecnica avanzata è la distillazione multi-teacher dei LLM, che prevede il trasferimento della conoscenza da più modelli teacher a un unico student. In questo scenario, ogni teacher può essere specializzato in un ambito specifico, per esempio uno nella comprensione del linguaggio naturale, un altro nella generazione di codice, un terzo nella risoluzione di problemi matematici, eccetera.

Lo student, combinando queste diverse fonti di apprendimento, riesce a sviluppare una maggiore versatilità e a ereditare competenze complementari.

L’aspetto più complesso di questa tecnica riguarda la gestione delle informazioni provenienti da modelli diversi. Quando i teacher offrono risposte divergenti su domini di conoscenza sovrapposti, il processo di fusione delle conoscenze deve essere attentamente calibrato, ad esempio con pesi dinamici che privilegino il teacher più affidabile per ciascun tipo di input o strategie di fusione che integrino le diverse prospettive in modo coerente, per garantire che il modello student apprenda in modo efficace.

Se ben implementata, la distillazione multi-teacher permette di ottenere modelli più robusti, capaci di affrontare un’ampia gamma di compiti con una qualità elevata.

Distillazione step-by-step: riprodurre il ragionamento del teacher

La distillazione step-by-step, nota anche come rationale distillation, si concentra non solo sulla riproduzione delle risposte finali, ma anche sul trasferimento del processo logico che porta a quelle risposte. Il modello teacher non fornisce solo l’output corretto, ma guida il modello student attraverso una sequenza di ragionamenti espliciti, che il modello più piccolo deve imparare a replicare.

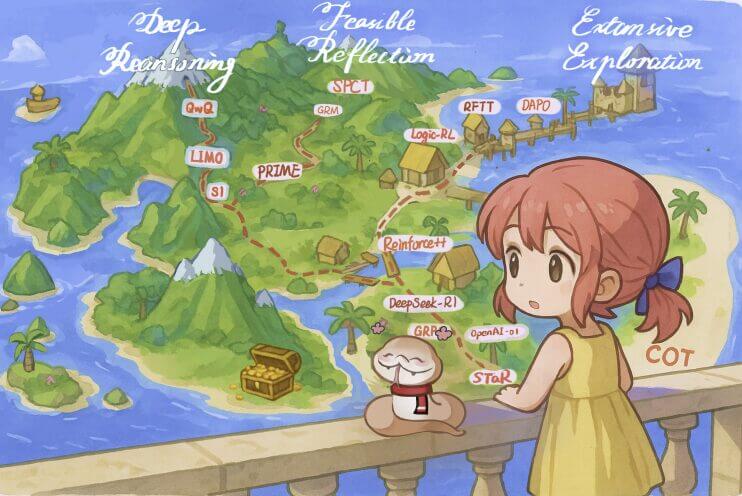

Questa tecnica sfrutta il metodo Chain-of-Thought (CoT), che suddivide problemi complessi in una serie di passaggi più semplici e comprensibili. Se, per esempio, un teacher deve risolvere un problema matematico, invece di restituire direttamente il risultato, genera una spiegazione dettagliata del processo di calcolo. Lo student, apprendendo questa struttura argomentativa, non solo migliora la propria capacità di fornire risposte corrette, ma acquisisce anche una maggiore abilità nel ragionamento strutturato.

Un approccio particolarmente utile in applicazioni che richiedono deduzione, problem solving e interpretazione logica.

Luca Sambucci, dopo oltre trent’anni passati nella cybersecurity, oggi si specializza in AI Security. Dal 2019 pubblica la prima newsletter italiana sull’AI: bollettino.notizie.ai

Self-distillation: il modello diventa il proprio insegnante

La self-distillation rappresenta un concetto ancora più avanzato, in cui il modello student non dipende più da un teacher esterno per apprendere, ma diventa esso stesso la propria fonte di miglioramento. In questo scenario, un modello già addestrato viene utilizzato per generare nuovi dati con cui affinare ulteriormente le proprie prestazioni.

Un esempio di questa tecnica è l’uso di un modello per generare risposte a una serie di domande, per poi riutilizzare queste stesse risposte come dati di addestramento per sé. Un processo iterativo che, se non adeguatamente vincolato, può portare al cosiddetto “mode collapse”, dove il modello gradualmente riduce la diversità delle sue risposte. Per evitare questo problema, è necessario introdurre vincoli specifici o combinare l’auto-distillazione con dati esterni che mantengano la variabilità delle risposte.

La self-distillation è particolarmente utile nei contesti in cui l’accesso a modelli teacher più grandi è limitato o troppo costoso. Inoltre, consente un miglioramento continuo delle prestazioni senza dover dipendere da risorse computazionali esterne, rendendola una soluzione efficace per modelli in produzione che necessitano di auto-ottimizzazione nel tempo.

Purtroppo, questo approccio presenta anche delle sfide non semplici da risolvere. Uno dei problemi principali è il rischio di amplificazione degli errori: se il modello student utilizza esclusivamente le proprie risposte per riaddestrarsi, eventuali errori o bias presenti nelle prime fasi dell’apprendimento possono propagarsi e consolidarsi nel tempo. Senza un teacher esterno a supervisionare il processo, il modello potrebbe reiterare convinzioni errate o affinare risposte imprecise invece di correggerle, compromettendo la qualità complessiva delle sue previsioni.

Diversità e qualità dei dati generati per l’auto-addestramento

Un’altra difficoltà riguarda la diversità e la qualità dei dati generati per l’auto-addestramento. Affinché la self-distillation sia efficace, il modello deve essere in grado di produrre variazioni informative nelle sue risposte, evitando di limitarsi a ripetere le stesse strutture linguistiche o concetti appresi nelle prime iterazioni. Se il modello non introduce una sufficiente variabilità nelle sue previsioni, rischia di convergere su un insieme ristretto di risposte e perdere la capacità di generalizzare correttamente a nuovi input.

Per mitigare questi problemi, spesso si adottano strategie di regolarizzazione e filtraggio automatico delle risposte. Alcuni approcci prevedono l’uso di un verificatore esterno, come un secondo modello che valuta la coerenza e l’accuratezza delle risposte generate, selezionando solo quelle più affidabili per l’auto-addestramento. Un’altra tecnica consiste nel combinare la self-distillation con dati reali o etichettati manualmente, in modo da mantenere un riferimento stabile che impedisca al modello di derivare verso risposte errate o ripetitive.

Nonostante queste sfide, la self-distillation rimane una soluzione promettente, soprattutto nei casi in cui si vogliono ridurre i costi di accesso a modelli più grandi o si necessita di una strategia di miglioramento continuo per sistemi AI operativi in ambienti dinamici. Se integrata con adeguati meccanismi di controllo della qualità, può rappresentare un passo importante verso modelli più autonomi e capaci di auto-migliorarsi nel tempo senza interventi esterni.

Distillazione dei LLM: quale tecnica scegliere?

Per ottenere un modello student che possa replicare, almeno in parte, le capacità di un teacher più grande, ogni tecnica di distillazione si focalizza su un aspetto diverso del trasferimento della conoscenza.

- La distillazione basata sui logit rappresenta l’approccio più immediato ed efficace per chi vuole modelli compatti con una buona capacità di generalizzazione, sfruttando le distribuzioni probabilistiche del teacher.

- La distillazione progressiva, invece, è più indicata quando il passaggio diretto da modelli grandi a piccoli rischia di causare una perdita eccessiva di informazioni: in tal caso, una serie di modelli intermedi consente di preservare al meglio le performance originarie.

- Ma se l’obiettivo è dotare il modello di una capacità avanzata di ragionamento strutturato, la tecnica migliore è la distillazione step-by-step (rationale distillation), che si focalizza sul trasferimento esplicito del ragionamento logico seguito dal teacher nella risoluzione di compiti complessi.

- La distillazione multi-teacher è ideale per modelli che devono affrontare compiti eterogenei, combinando competenze da diversi modelli specializzati.

- Infine, la self-distillation risulta particolarmente utile nei casi in cui il modello debba affinare continuamente le proprie capacità in assenza di un teacher esterno, migliorando autonomamente le proprie prestazioni attraverso un processo iterativo e controllato.

L’esempio italiano di Vitruvian

Anche l’italiano Vitruvian, come è scritto chiaramente nel technical report, ha usato tecniche di distillazione. Nel suo caso, Vitruvian ha implementato un approccio avanzato di distillazione denominato CoT Distillation via Rejection Sampling, un metodo che consente di trasferire efficacemente capacità di ragionamento avanzato da un modello più grande a uno più compatto. Per farlo, gli sviluppatori hanno utilizzato DeepSeek-R1 come modello teacher, generando per ogni domanda un set di otto risposte candidate basate sul paradigma Chain-of-Thought (CoT). Questo meccanismo, già noto per migliorare le capacità di ragionamento nei LLM, è stato qui raffinato attraverso un processo di selezione mirato.

Le risposte generate sono state sottoposte a verifica automatizzata, utilizzando due strategie distinte. Per le domande di tipo matematico, un verificatore deterministico ha controllato che il risultato finale fosse coerente con la soluzione corretta. Per compiti di ragionamento più generali, invece, è stato impiegato un modello esterno con funzione di giudice, il quale ha confrontato le risposte fornite dal modello con le soluzioni attese. Solo le risposte ritenute corrette sono state mantenute nel dataset finale, mentre le domande per cui nessuna delle otto risposte soddisfaceva i criteri di accuratezza sono state scartate.

Tale strategia non solo ha permesso a Vitruvian di distillare efficacemente le capacità di DeepSeek, ma ha anche garantito un elevato livello di affidabilità nelle risposte finali. L’uso del rejection sampling ha reso possibile il filtraggio delle risposte subottimali, preservando nel modello finale una qualità di ragionamento simile a quella del teacher, ma con un costo computazionale inferiore.

Potenziali evoluzioni e scenari futuri

La questione della distillazione si inserisce nell’ampio dibattito sul futuro dell’intelligenza artificiale. Per chi investe centinaia di milioni in modelli complessi, la distillazione rappresenta un’arma che, pur garantendo una maggiore diffusione dell’intelligenza artificiale, potrebbe compromettere il ritorno economico degli investimenti effettuati. Se un’impresa riesce ad ottenere prestazioni analoghe spendendo molto meno, chi ha investito nella realizzazione originale si trova inevitabilmente in posizione più difficile da difendere.

Al cuore della discussione si colloca dunque un problema basilare di ROI, ovvero come rendere giustificabili e recuperabili gli ingenti costi sostenuti: se emergesse un uso generalizzato e incontrollato della distillazione con modelli teacher distillati a insaputa dei loro produttori, le realtà che guidano il mercato potrebbero optare per una chiusura sempre maggiore, limitando drasticamente l’accessibilità delle tecnologie più avanzate.

Una possibile via mediana consisterebbe in modelli di licenza rivisitati, capaci di chiarire con precisione limiti e condizioni d’uso della distillazione.

L’alternativa potrebbe essere rappresentata dall’incremento di strategie di protezione più aggressive, come il blocco completo di rilasci open-source o l’impiego di sofisticati meccanismi per tracciare e impedire abusi.

Resterebbe tuttavia da considerare la sostenibilità pratica e morale di effettuare scelte troppo protettive che, per impedire la distillazione non autorizzata, rischierebbero anche di rallentare il progresso della ricerca e del sistema startup.

Una questione aperta

Non è un’esagerazione affermare che il futuro dell’intelligenza artificiale si giocherà anche sulle modalità con cui verrà regolamentato l’uso della distillazione. Da un lato questa tecnica spinge verso una diffusione rapida ed efficiente della tecnologia, consentendo a molte aziende anche di media grandezza di divenire produttori di modelli AI anziché meri consumatori.

Dall’altro, però, rischia di alterare profondamente e in modo irreversibile gli equilibri economici del settore. Saranno quindi gli stessi protagonisti dell’industria a decidere se cercare nuove forme collaborative e di regolamentazione trasparente oppure orientarsi verso la chiusura, con ripercussioni difficilmente prevedibili sull’intero ecosistema AI.