Smascherare i deepfake creati con l’intelligenza artificiale si può: la verità è negli occhi. Gli informatici dell’Università di Buffalo hanno sviluppato uno strumento che identifica automaticamente i deepfake analizzando i riflessi di luce negli occhi del soggetto. Con risultati strabilianti: smascherato il 94% delle falsificazioni. In pratica, la stessa intelligenza artificiale con cui si creano i deepfake può servire a smascherarli.

La verità sui deepfake: l’analisi del bulbo oculare

Le tecnologie per alterare – o per creare da zero – immagini, video e/o audio in modi altamente realistici e difficili da rilevare sono in costante e rapida evoluzione[1]. Ma è la stessa tecnologia che accorre in nostro aiuto per renderli più facilmente smascherabili. Se all’occhio umano le differenze sono ormai quasi impercettibili, lo stesso non può dirsi per l’AI.

In generale, gli strumenti di rilevamento dei deepfake si basano sulla presenza di fattori innaturali quali movimenti facciali irregolari o un’eccessiva levigatura della pelle.

Shu Hu e colleghi (2020)[2] propongono un nuovo metodo di rilevamento fisico/fisiologico dei volti sintetizzati da una rete GAN (Generative Adversarial Network) che analizza il riflesso della luce nelle pupille del soggetto ritratto. Il motivo per cui l’algoritmo riesce con particolare efficacia a individuare le immagini fake è semplice: l’intelligenza artificiale, infatti, è – almeno fino ad ora – incapace di creare riflessi oculari accurati e realistici.

Seppur impercettibili a prima vista, ci sono delle differenze nella forma, nell’estensione e nel colore del riflesso tra occhio destro e sinistro di un volto fake. Come spiega Siwei Lyu, professore presso la Suny Empire Innovation e principale autore dello studio, «La cornea è quasi come una semisfera perfetta ed è molto riflettente. Pertanto, qualsiasi emissione di luce che giunga all’occhio avrà una sua immagine sulla cornea» [3].

In una foto e/o video reale, i riflessi sugli occhi generalmente hanno la stessa forma e colore. Tuttavia, la maggior parte delle immagini generate da una rete GAN non riesce a sintetizzare accuratamente questa somiglianza – probabilmente a causa delle molte immagini combinate per generare il volto falso –; per cui genera riflessi incoerenti e disomogenei su ciascuna cornea[4].

Lo strumento di Lyu sfrutta questa lacuna: mappando il volto e confrontando in modo incredibilmente dettagliato le potenziali differenze di forma, l’intensità della luce e altre caratteristiche della luce riflessa, è possibile distinguere, con alta precisione, se la foto del volto è reale o è un deepfake[5].

Per condurre gli esperimenti, il team di ricerca ha combinato immagini reali ottenute da Flickr Faces-HQ e immagini false ottenute da thispersondoesnotexist.com, un repository di volti falsi generati dall’intelligenza artificiale. Tutte le immagini sono di tipo ritratto (persone reali e persone false che guardavano direttamente nella fotocamera con una buona illuminazione) e 1.024 per 1.024 pixel.

Il sistema, poi, genera un punteggio che serve come metrica di somiglianza: più è alto il punteggio, più è probabile che la foto sia reale; viceversa, più basso è il numero, maggiore è la probabilità che l’immagine sia falsa. I primi risultati sono già molto convincenti: il 94% delle falsificazioni sono state smascherate, ovvero si è riusciti a scoprire la verità sui deepfake.

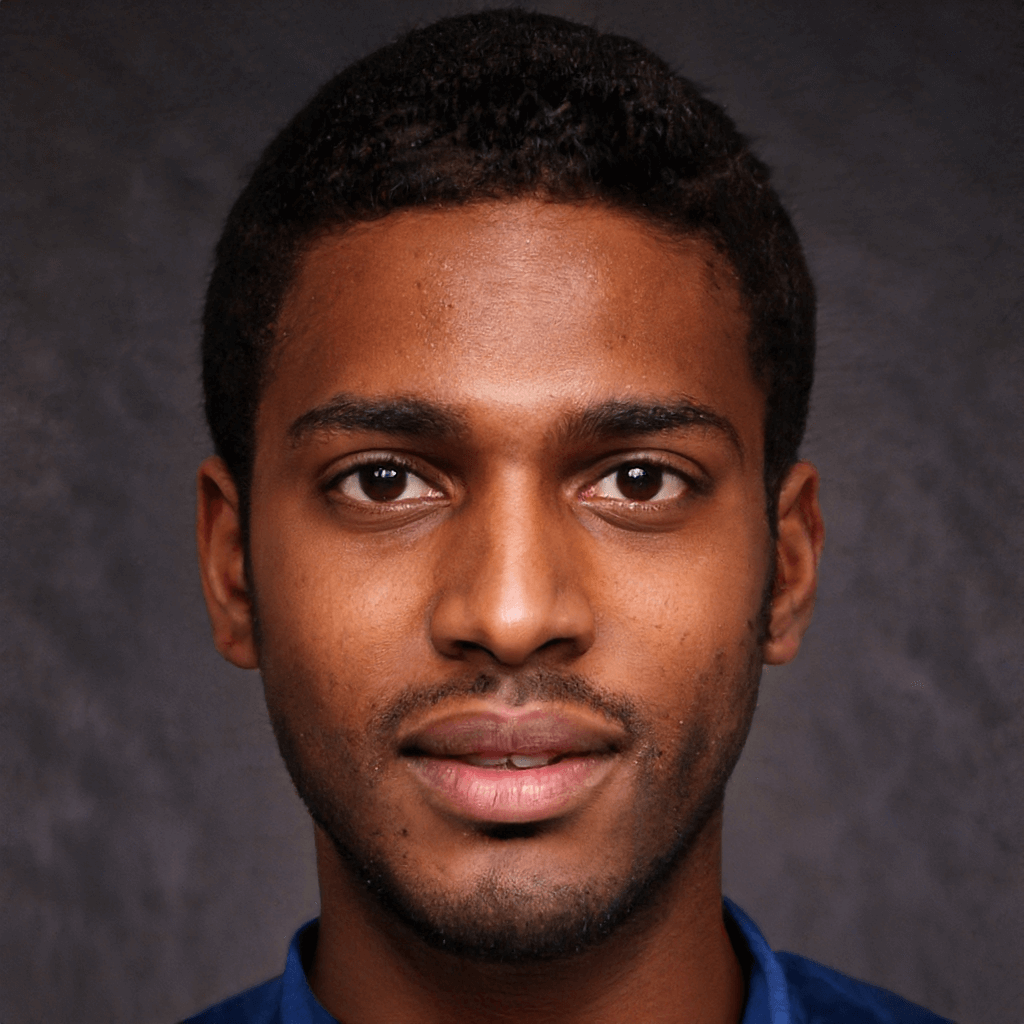

Un ritratto creato artificialmente da “thispersondoesnotexist.com”: questa persona non esiste.

La verità sui deepfake: i limiti di questa tecnica di smascheramento

Seppur promettente, la tecnica di Lyu presenta alcuni limiti[6]. In primis, il sistema funziona correttamente solo in presenza di una sorgente di luce abbastanza evidente tale da generare un riflesso sulle cornee. In secondo luogo, c’è il rischio che un successivo lavoro di editing dell’immagine potrebbe correggere queste incongruenze, traendo così ugualmente in inganno l’algoritmo e rendendo inutile lo strumento.

Infine, per scoprire la verità su un deepfake è necessario che entrambi gli occhi siano presenti nell’immagine e ben in vista. Se il soggetto sbatte le palpebre, fa l’occhiolino o non guarda direttamente nella camera (o ancora, indossa degli occhiali), la tecnica fallisce poiché si è dimostrata efficace solo nelle immagini a ritratto.

Lo strumento è ancora in fase di sviluppo ma rappresenta senz’altro un primo e valido ausilio per rilevare i contenuti fake che dilagano, ormai incontrollati, sul web.

L’era della post-verità

Il web ha da tempo, ormai, assunto i connotati di una dimensione “post-verità” (Keyes, 2004)[7], in cui sfuma sempre di più il confine, già labile, tra realtà e finzione. Gli utilizzi notoriamente non sempre virtuosi della tecnologia deepfake – che spaziano dall’alveo della pornografia a quello della satira politica, passando per le frodi – destano sempre maggiori timori e perplessità.

Inoltre, l’ampia disponibilità di strumenti open-source per creare deepfake rappresenta una minaccia per l’affidabilità dei media online ed espone al rischio di una vera e propria “Infocalisse” – ossia una “apocalisse informativa”[8] – in cui la minaccia principale non sarà tanto venire ingannati, quanto arrivare a considerare tutto come un inganno. Quel che Aviv Ovadya, capo tecnologo del Center for Social Media Responsibility dell’Università del Michigan, definisce “l’apatia per la realtà“[9].

Lo sviluppo dell’algoritmo è parte integrante dell’impegno di sensibilizzazione che Lyu sta portando avanti, richiamando l’attenzione sulla necessità sempre più pressante di strumenti che consentano di rilevare i contenuti fake[10].

In proposito, si noti come Lyu abbia contribuito a creare anche il Deepfake-o-meter, una piattaforma online open-source che aiuta gli utenti a scoprire la verità sui video deepfake[11].

Video: Un esempio di deepfake creato a uso politico che vede coinvolto, suo malgrado, l’ex presidente Usa, Barack Obama

Conclusioni

La verità è negli occhi, ma anche il falso può celarsi proprio lì. Col tempo, è probabile che strumenti di questo tipo diventeranno sempre più efficaci nell’aiutarci a rilevare i contenuti fake, di pari passo con gli stessi deepfake che, presumibilmente, saranno sempre più sofisticati e in grado di ingannarci. Per il momento, occhi aperti: ora che sappiamo cosa guardare, i volti fake possono essere (più facilmente) individuati. È proprio vero che «la lingua può nascondere la verità, ma gli occhi mai» (Michail Bulgakov).

Note

- Chesney R., Citron, D. K. (2019). Deep Fakes: A Looming Challenge for Privacy, Democracy, and National Security ,107 California Law Review, pp. 1753-1820. ↑

- Shu Hu, Yuezun Li, and Siwei Lyu. (2020). Exposing GAN-generated Faces Using Inconsistent Corneal Specular Highlights. arXiv:2009.11924 [cs.CV]. ↑

- Bankead M. (2021). How to spot deepfakes? Look at light reflection in the eyes. Available at http://www.buffalo.edu/news/releases/2021/03/010.html↑

- Shu Hu, Yuezun Li, and Siwei Lyu. (2020). Exposing GAN-generated Faces Using Inconsistent Corneal Specular Highlights. arXiv:2009.11924 [cs.CV]. ↑

- Bankead M. (2021). How to spot deepfakes? Look at light reflection in the eyes. Available at http://www.buffalo.edu/news/releases/2021/03/010.html ↑

- Shu Hu, Yuezun Li, and Siwei Lyu. (2020). Exposing GAN-generated Faces Using Inconsistent Corneal Specular Highlights. arXiv:2009.11924 [cs.CV]. ↑

- Keyes, R. (2004). The post-truth era: Dishonesty and deception in contemporary life. New York: St. Martin’s. ↑

- Charlie Warzel, “He Predicted the 2016 Fake News Crisis. Now He’s Worried About An Information Apocalypse”. BuzzFeed News (blog), February 11, 2018, https://www.buzzfeednews.com/article/charliewarzel/the-terrifying-future-of-fake-news ; Franklin Foer, “The Era of Fake Video Begins,” The Atlantic, April 8, 2018, https://www.theatlantic.com/magazine/archive/2018/05/realitys-end/556877/ ↑

- Schwartz O. (2018). You thought fake news was bad? Deep fakes are where truth goes to die. The Guardian. Available athttps://www.theguardian.com/technology/2018/nov/12/deep-fakes-fake-news-truth ↑

- Bai A. (2021). I deepfake non sono ancora perfetti! Ecco come scoprirli con i riflessi degli occhi. Harward Upgrade. Available at https://www.hwupgrade.it/news/scienza-tecnologia/i-deepfake-non-sono-ancora-perfetti-ecco-come-scoprirli-con-i-riflessi-degli-occhi_96237.html ↑

- Li, Y., Zhang, C., Sun, P., Qi, H., & Lyu, S. (2021). DeepFake-o-meter: An Open Platform for DeepFake Detection. arXiv preprint arXiv:2103.02018. ↑