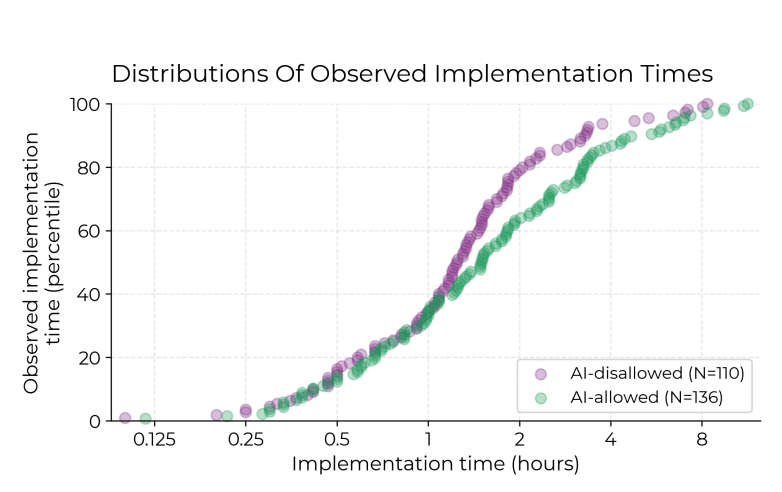

Contrariamente all’idea diffusa, secondo cui l’intelligenza artificiale potenzierebbe le performance degli sviluppatori, una nuova ricerca mostra un risultato inaspettato: l’AI rallenta i programmatori esperti quando lavorano su codice che conoscono già. Lo studio, condotto da METR – un’organizzazione no-profit che si occupa di ricerca sull’intelligenza artificiale – ha osservato un gruppo di sviluppatori esperti mentre utilizzavano Cursor, un noto assistente AI per la programmazione, su progetti open-source familiari.

RICERCA

AI e sviluppatori esperti: l’assistente rallenta chi conosce già il codice

Una nuova ricerca del centro METR rivela che l’uso di strumenti di intelligenza artificiale può rallentare i programmatori esperti quando lavorano su progetti di codice open-source che conoscono bene. La causa? Le correzioni richieste alle proposte dell’AI. Lo studio sfida le narrazioni dominanti sull’incremento di produttività offerto dall’AI.

Continua a leggere questo articolo

Argomenti

Canali