La Chain of Thought è un concetto tecnico, tecnologico, etico, sociale e filosofico. Pure concentrandoci soprattutto sugli aspetti tecnologici ed etici, non si può fare a meno di evidenziare che la peculiarità di mostrare un modo di pensare era, fino a pochi anni fa, appannaggio esclusivamente dell’essere umano.

approfondimento

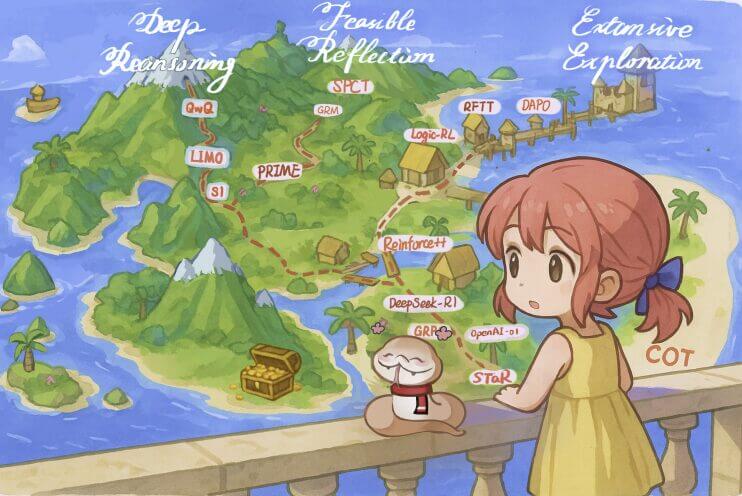

Chain of Thought, cosa è il ragionamento passo a passo dei LLM

Formalizzata nel 2022, la Chain of Thought ha rapidamente preso piede nello sviluppo dei Large language model. È una tecnica promettente che ne migliora la coerenza e la trasparenza, anche se non è esente da criticità

Continua a leggere questo articolo

Argomenti

Canali