OpenAI ha presentato ChatGPT-5 nell’estate del 2025 come il suo modello di punta. Il nuovo modello apporta un’evoluzione significativa rispetto a GPT-4.0 e successivi. Oltre a miglioramenti in intelligenza generale, capacità di ragionamento e prestazioni nel coding, GPT-5 ha introdotto novità rilevanti per il prompting: maggiore prevedibilità negli agentic workflow, controlli più granulari su parametri come reasoning_effort e verbosity, e una risposta più precisa alle istruzioni complesse. Questi aspetti rendono il prompting non solo uno strumento di interazione, ma un vero e proprio motore per massimizzare le potenzialità del modello in ambito produttivo, dalla scrittura al software engineering. Di seguito vengono analizzate le principali aree del prompting con GPT-5, con esempi e linee guida pratiche derivate dalla documentazione ufficiale OpenAI e dai casi d’uso in ambienti reali

Indice degli argomenti:

Agentic workflow e prevedibilità

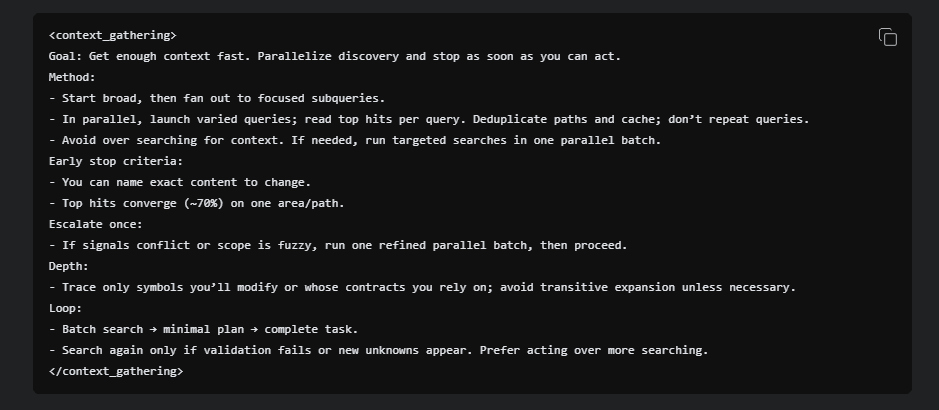

GPT-5 è stato progettato per eccellere in scenari agentici, dove il modello interagisce con strumenti esterni e prende decisioni autonome. Una delle principali sfide è calibrare l’eagerness, cioè il livello di proattività del modello. Per ridurre l’eccesso di esplorazione, è possibile abbassare il parametro reasoning_effort e definire nel prompt criteri chiari su come esplorare il problema, con limiti precisi di profondità e numero massimo di chiamate agli strumenti.

Al contrario, per scenari che richiedono maggiore autonomia, è sufficiente aumentare il reasoning_effort e usare istruzioni che incoraggino il modello a procedere fino alla completa risoluzione del compito, senza chiedere conferme all’utente. Questa capacità di bilanciamento rende GPT-5 adatto a contesti sia fortemente controllati (ad esempio, operazioni critiche in ambito IT) sia a flussi più esplorativi, come la ricerca o la prototipazione.

Esempio: ridurre l’eccessiva proattività

Se vogliamo che GPT-5 agisca con meno esplorazione e arrivi velocemente a una risposta:

<context_gathering>

Goal: Ottieni solo il contesto strettamente necessario.

– Fai massimo 2 chiamate agli strumenti.

– Smetti di cercare non appena puoi agire.

– Se i risultati sono parziali, procedi comunque.

</context_gathering>

Questo prompt è utile, ad esempio, quando il modello deve recuperare velocemente i titoli delle ultime vulnerabilità di Windows: meglio due query mirate che un’esplorazione infinita.

Esempio: aumentare la proattività

Al contrario, se vogliamo che GPT-5 porti a termine un compito complesso senza mai rimandare all’utente:

<persistence>

– Continua fino a risolvere completamente la richiesta.

– Non chiedere mai chiarimenti: scegli l’ipotesi più ragionevole.

– Documenta a fine compito le assunzioni fatte.

</persistence>

Scenario tipico: analizzare un’intera codebase e correggere un bug. In questo caso è utile che l’agente non si fermi a chiedere conferme, ma proceda in autonomia.

Tool preambles e trasparenza operativa

Una novità importante riguarda i tool preambles, ovvero messaggi preliminari che spiegano in modo chiaro cosa il modello sta facendo con le chiamate agli strumenti e perché. In un contesto di lavoro collaborativo, questi preamboli permettono di seguire il ragionamento del modello, in modo da ridurre eventuali opacità e aumentare la fiducia dell’utente.

Attraverso il prompting, è possibile specificare se si desidera un preambolo dettagliato di ogni tool call oppure una pianificazione sintetica con aggiornamenti periodici. Questa trasparenza diventa cruciale nei processi di lunga durata o ad alto rischio, come il debugging di sistemi complessi.

GPT-5 permette di generare messaggi preliminari che spiegano cosa sta facendo.

Esempio: preambolo dettagliato

<tool_preambles>

– Riformula l’obiettivo utente.

– Descrivi il piano in 3 passi prima di eseguire.

– Aggiorna lo stato dopo ogni azione.

</tool_preambles>

Output tipico:

“Devo trovare le condizioni meteo attuali a Milano. Piano: 1) Chiamo API meteo, 2) Estraggo temperatura in °C e °F, 3) Restituisco il risultato all’utente.”

Scenario utile: debug o analisi dati, dove seguire il ragionamento dell’agente aumenta la fiducia.

Controllo di reasoning e memoria: Responses API

Con GPT-5, OpenAI raccomanda l’uso della Responses API, che conserva il contesto di ragionamento tra una chiamata e l’altra. In questo modo il modello non deve ricostruire il piano da zero, così da poter ridurre latenza e consumo di token. Nei test interni, il semplice passaggio a questa API ha portato miglioramenti significativi in benchmark come Tau-Bench Retail. Attraverso il prompting, è utile guidare il modello a riutilizzare i contesti precedenti, in modo da evitare ridondanze e aumentare la coerenza dei risultati. Questo aspetto è particolarmente rilevante in scenari multi-turn come l’analisi di codice o la gestione di workflow complessi.

Reasoning_effort e Responses API

Il parametro reasoning_effort consente di decidere quanto profondamente il modello deve ragionare.

- Basso → risposte rapide, meno accurate (es. FAQ semplici).

- Alto → ragionamenti complessi (es. refactor software).

Esempio concreto

Prompt con effort basso:

“Dammi in due righe la definizione di phishing.”

Prompt con effort alto:

“Analizza questo log di rete, individua potenziali indicatori di compromissione e proponi contromisure.”

Con la Responses API, GPT-5 mantiene la memoria del ragionamento. Questo è essenziale in contesti multi-step: ad esempio, un assistente e-commerce che prima cerca un ordine, poi controlla il pagamento, poi gestisce il reso. Senza la Responses API, ogni step dovrebbe ripartire da zero.

Ottimizzazione del prompting per il coding

ChatGPT-5 rappresenta un salto notevole nelle capacità di sviluppo software: è in grado di operare su codebase estese, gestire refactor multi-file e implementare nuove applicazioni da zero. Il prompting gioca un ruolo fondamentale per ottenere codice chiaro e manutenibile.

Tra le pratiche consigliate vi sono:

- usare regole esplicite di design e standard di progetto nel prompt, per garantire che il codice generato sia coerente con quello esistente;

- preferire leggibilità e riuso, evitando soluzioni eccessivamente ottimizzate o criptiche;

- sfruttare self-reflection prompts, in cui il modello costruisce un proprio rubric di eccellenza prima di produrre il risultato finale.

Un esempio pratico proviene da Cursor, editor di codice basato su AI, che ha collaborato con OpenAI per ottimizzare i prompt di GPT-5. Regolando parametri come verbosity e introducendo istruzioni specifiche sul comportamento dell’agente, Cursor ha ottenuto output più chiari e flussi di lavoro più autonomi.

Coding: esempi di prompting per sviluppatori

GPT-5 eccelle nello sviluppo software, ma il prompting determina la qualità del codice.

Esempio: nuove app

<self_reflection>

– Pensa a una checklist di 5 criteri (usabilità, performance, leggibilità, sicurezza, modularità).

– Genera il codice solo quando sei sicuro di rispettarli tutti.

</self_reflection>

Questo tipo di prompt è stato usato da Cursor, editor basato su AI, per far produrre a GPT-5 applicazioni frontend in Next.js e React con codice leggibile e aderente agli standard.

Esempio: refactor di codice esistente

<code_editing_rules>

– Rispetta lo stile della codebase.

– Mantieni i nomi delle variabili chiari.

– Evita duplicazioni: crea componenti riusabili.

</code_editing_rules>

Scenario: aggiungere un nuovo componente a un’app React senza rompere lo stile preesistente.

Verbosity e instruction-following

GPT-5 introduce un nuovo parametro API, verbosity, che controlla la lunghezza delle risposte finali. Questo permette di separare la complessità del ragionamento interno dalla quantità di testo prodotto. Inoltre, il modello risponde bene a comandi naturali nel prompt che modulano il livello di dettaglio.

Sul fronte dell’instruction-following, GPT-5 mostra un’aderenza molto precisa alle istruzioni, il che lo rende estremamente potente ma anche più sensibile a prompt ambigui o contraddittori. Un prompt mal strutturato può indurre il modello a sprecare risorse cercando di riconciliare istruzioni incompatibili. Per questo motivo è essenziale rivedere attentamente i prompt, eliminando incoerenze e ambiguità. Utile quando il modello deve spiegare sinteticamente una soluzione ma fornire altresì codice completo e leggibile.

Esempio pratico

Prompt con bassa verbosity:

“Rispondi in massimo 3 frasi.”

Prompt con alta verbosity solo nel codice:

– Mantieni le spiegazioni brevi.

– Scrivi invece codice dettagliato, con commenti e nomi espliciti.

Minimal reasoning e latenza ridotta

Una delle innovazioni più rilevanti è l’introduzione del minimal reasoning, una modalità che riduce al minimo il ragionamento interno mantenendo i benefici dei modelli basati su reasoning. Questa opzione è pensata per applicazioni sensibili alla latenza, in cui la velocità di risposta è più importante della massima accuratezza.

Per ottenere buoni risultati con il minimal reasoning, è cruciale fornire al modello prompt ben strutturati, con piani dettagliati e criteri di arresto chiari. In questo contesto, il prompting diventa lo strumento principale per compensare la ridotta capacità di pianificazione interna.

Il minimal reasoning è ideale per applicazioni dove serve latenza minima, ad esempio chatbot customer care.

Esempio di prompting ottimizzato

“Se il cliente chiede di cancellare un ordine, verifica lo stato. Se è pending, proponi la cancellazione. Rispondi sempre con una sola frase + azione.”

Scenario tipico: annullamento ordini in e-commerce, dove la velocità è prioritaria.

Markdown, metaprompting e buone pratiche finali

Per garantire coerenza nell’output, GPT-5 può essere istruito a usare Markdown solo dove semanticamente appropriato, evitando formattazioni ridondanti. Inoltre, una pratica avanzata è il metaprompting, ovvero l’uso del modello stesso per ottimizzare i propri prompt: attraverso l’inserimento nel modello di esempi di comportamenti indesiderati, GPT-5 è in grado di suggerire modifiche minime al prompt originale per correggerne le carenze.

In sintesi, le best practice per il prompting con GPT-5 possono essere riassunte in tre principi chiave:

- Chiarezza e coerenza: prompt privi di ambiguità generano risultati più efficienti.

- Controllo dei parametri: reasoning_effort e verbosity consentono un’ampia gamma di personalizzazioni.

- Iterazione e adattamento: il prompting non è statico, ma va testato e raffinato in base al contesto applicativo.

Per output leggibili, GPT-5 può essere istruito a usare Markdown in modo controllato.

Esempio

“Usa Markdown solo per titoli e codice, non per liste non necessarie.”

Infine, il metaprompting: usare GPT-5 per migliorare i propri prompt.

Esempio:

“Questo prompt non riesce a far produrre al modello una risposta sintetica. Quali frasi dovrei modificare o aggiungere per ottenere più concisione?”

GPT-5 suggerirà di sostituire “fornisci dettagli” con “rispondi in massimo 2 frasi”.