GPT-5.2 è un cambio di baricentro rispetto alle iterazioni recenti. L’unità di misura non è più soltanto l’accuratezza su domande isolate, ma la capacità di attraversare un progetto senza perdere coerenza, rispettando vincoli e priorità.

Per capirne l’impatto iniziale bisogna guardare a due piani complementari. Il primo è economico e riguarda la produttività del lavoro cognitivo. Il secondo è “agentico” e riguarda l’affidabilità in sequenze multi‑passo con uso di strumenti.

Ecco un’analisi complessiva basata sulle prime esperienze di uso.

Indice degli argomenti:

GDPval e la promessa sul lavoro cognitivo

Sul piano economico OpenAI ha provato a quantificare il salto con GDPval, un benchmark proprietario costruito su compiti ben specificati che coprono 44 occupazioni. Nella lettura dell’azienda, GPT-5.2 Thinking vince o pareggia il confronto con professionisti di settore nel 70,9% dei casi. Il risultato è sostenuto da valutazioni di esperti umani e non solo da metriche automatiche.

OpenAI accompagna questi numeri con due stime che hanno catalizzato la discussione. Secondo l’azienda, i lavori prodotti dal modello sarebbero stati realizzati oltre 11 volte più velocemente e a meno dell’1% del costo rispetto a esperti, assumendo supervisione umana e usando parametri storici di tempo e compensi. Va letto come indicatore e non come verità universale, perché dipende da come sono definiti compiti, standard di qualità e contesti.

Però aiuta a spiegare perché molti osservatori interpretino GPT-5.2 come un acceleratore della trasformazione del “knowledge work” in un processo sempre più ibrido, dove l’umano si sposta verso indirizzo, verifica e responsabilità.

Coding: SWE‑Bench e la realtà dei repository

Sul fronte dei benchmark pubblici, il coding resta uno dei terreni più osservati perché collega in modo diretto qualità del modello e valore industriale. GPT-5.2 Thinking arriva al 55,6% su SWE‑Bench Pro, progettato per essere più resistente alla contaminazione e più vicino alla realtà dei repository, e sale all’80,0% su SWE‑bench Verified. Non sono numeri che “chiudono” il problema dell’ingegneria del software. L’interpretazione dei requisiti, i test mancanti e gli errori di contesto restano punti critici. Il salto è però sufficiente a cambiare le scelte di prodotto, rendendo più difendibili agenti che propongono patch multi‑file e che operano dentro workflow di revisione.

Scienza e matematica: dove migliora e dove si ferma

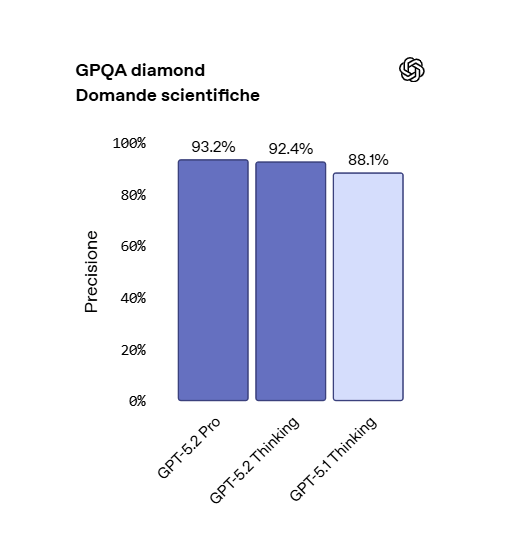

Un segnale interessante arriva anche dal versante scientifico, dove i benchmark tendono a essere meno permissivi verso risposte eleganti ma fragili. Nei materiali di lancio OpenAI riporta, senza strumenti, un 92,4% su GPQA Diamond, un set di domande scientifiche ad alta difficoltà, e il 100% su AIME 2025.

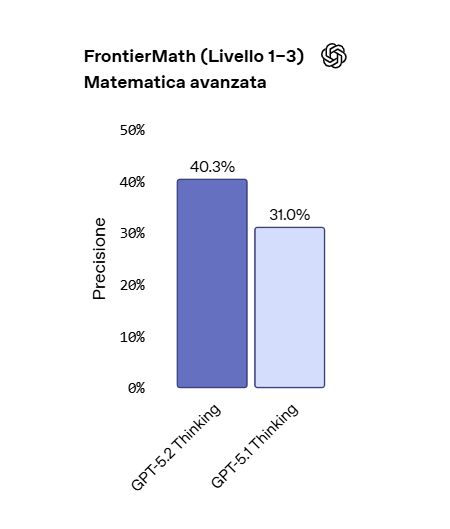

La misura su FrontierMath rimane invece più bassa, con il 40,3% sui tier 1–3 e il 14,6% sul tier 4. Questo contrasto è utile per leggere l’impatto reale.

GPT-5.2 non rende banale la matematica avanzata, ma spinge abbastanza da essere impiegabile come acceleratore di esplorazione e controllo, soprattutto quando può appoggiarsi a strumenti e quando l’obiettivo è verificare ipotesi, non sostituire il rigore formale.

Agenti e strumenti: il vero banco di prova

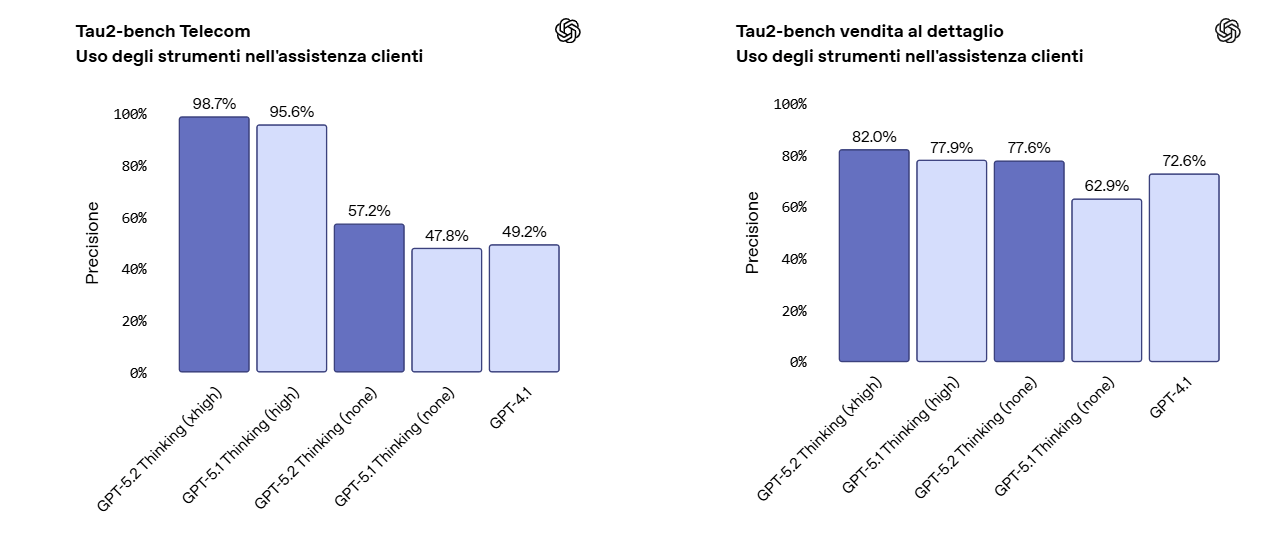

Il secondo asse, quello dell’agenticità, è probabilmente il più visibile nell’esperienza quotidiana. OpenAI dichiara un nuovo stato dell’arte su Tau2‑bench Telecom con il 98,7%. Se questo si traduce in stabilità reale, significa ridurre drasticamente i collassi degli agenti in conversazioni multi‑turno. È la differenza tra un assistente che sa chiamare un’API una volta e un sistema che può gestire una pratica completa, mantenendo vincoli, preferenze, eccezioni e passaggi obbligati.

A supporto di questa idea, nel materiale di presentazione vengono mostrati workflow complessi, come la gestione di un viaggio con coincidenze perse, bagagli mancanti e richieste mediche, dove la qualità non è la singola risposta ma la sequenza corretta di azioni. In questo tipo di scenari il valore nasce dalla continuità.

Il modello deve ricordare ciò che è stato deciso, rispettare policy e saper cambiare strategia quando una condizione esterna modifica il piano.

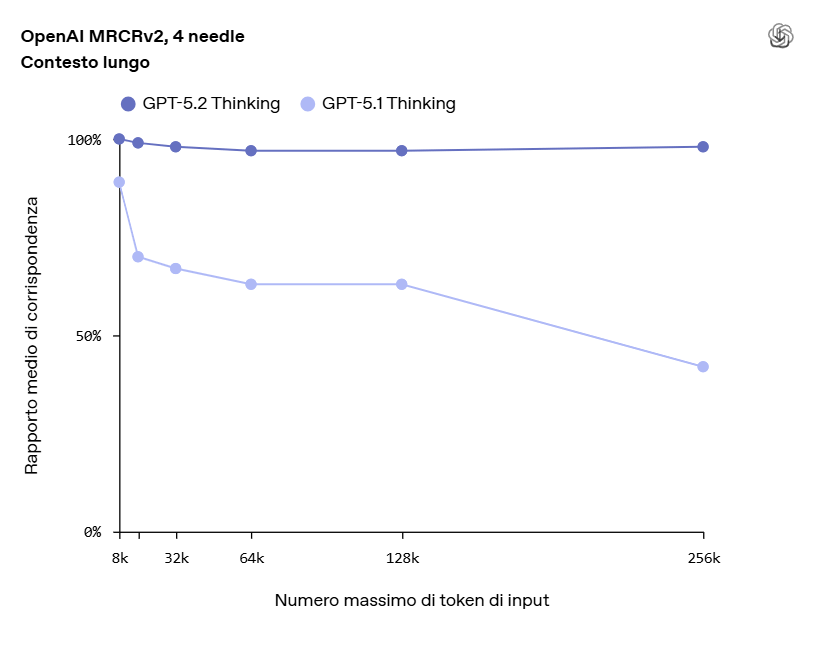

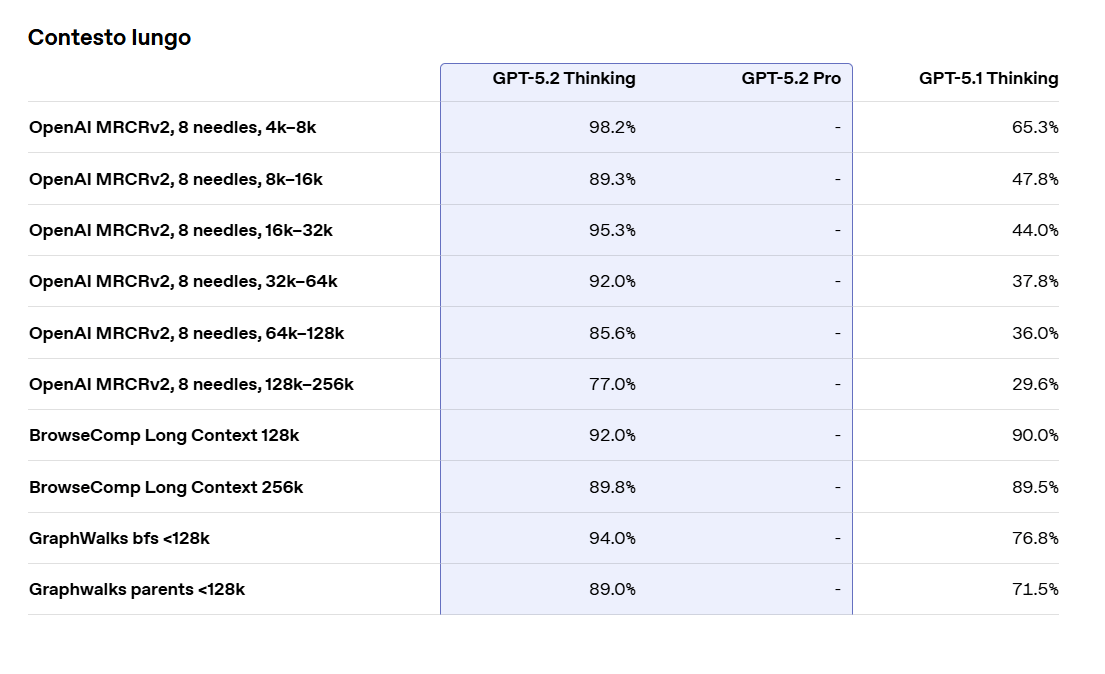

GPT-5.2 contesto lungo: dai contratti ai repository

Un altro tassello, spesso sottovalutato finché non si lavora su documenti lunghi, è la tenuta sul contesto esteso. GPT-5.2 Thinking viene presentato come leader su OpenAI MRCRv2, un test pensato per verificare la capacità di integrare informazioni sparse in testi molto lunghi. OpenAI riporta che il modello arriva a quasi il 100% di accuratezza nella variante a quattro “aghi” fino a 256k token.

Nella pratica può cambiare il modo in cui vengono trattati contratti, report, trascrizioni e collezioni di file, perché riduce gli errori di collegamento tra parti lontane del contesto.

Affidabilità: meno errori, stesso bisogno di verifica

Accanto alle metriche di capacità, OpenAI ha spinto anche su quelle di affidabilità. In una valutazione su query de‑identificate provenienti da ChatGPT, le risposte con errori risultano circa il 30% relativamente meno comuni rispetto a GPT-5.1 Thinking.

È una formulazione prudente, perché parla di riduzione relativa e non di azzeramento, ma è un segnale importante in ambito professionale.

Se l’adozione si sposta verso presentazioni, fogli di calcolo e decision support, anche piccoli miglioramenti nella tendenza all’allucinazione possono produrre effetti sistemici, soprattutto quando il modello viene usato in catene di strumenti.

Adozione e integrazioni: Copilot, IDE e workflow

Le prime integrazioni, in questi giorni, riflettono questa doppia anima. Oltre agli annunci iniziali, si sta delineando un pattern preciso. I principali prodotti di produttività e sviluppo stanno trattando GPT-5.2 come un’opzione di fascia alta selezionabile, più che come un sostituto immediato e obbligatorio.

Microsoft ha annunciato l’arrivo di GPT-5.2 nel selettore di modelli di Microsoft 365 Copilot e Copilot Studio, enfatizzando l’innesto sul contesto di lavoro e sugli strumenti aziendali.

Sul lato sviluppo software, GitHub ha aperto una public preview di GPT-5.2 per Copilot, con selezione del modello nel model picker e rollout graduale a piani Pro e organizzazioni Business/Enterprise. JetBrains indica compatibilità con GPT-5.2 in un proprio agente di coding.

Questa impostazione si vede anche in dettagli operativi che però influenzano direttamente l’esperienza e i costi. In API la famiglia viene esposta con nomi distinti e con una separazione più netta tra modello veloce e modello da lavoro profondo. OpenAI dichiara per GPT-5.2 un prezzo di 1,75 dollari per milione di token in input e 14 dollari per milione di token in output, con un forte sconto sugli input “cached”, che diventa rilevante quando si riutilizzano contesti lunghi o prompt di sistema ripetitivi.

La variante Pro viene proposta per i casi in cui si privilegia la qualità anche a costo di maggiore latenza. OpenAI introduce inoltre un livello aggiuntivo di sforzo di ragionamento, xhigh, pensato per massimizzare la qualità quando l’utente è disposto a pagare in tempo e token.

GPT-5.2: prezzo, prevedibilità, competizione

La ricezione non è però solo entusiasmo. Tra i power user emergono osservazioni ricorrenti su tre aspetti. Il primo riguarda la prevedibilità del comportamento tra modalità, soprattutto quando ci si aspetta che un’impostazione di ragionamento venga rispettata in modo uniforme.

Il secondo riguarda il prezzo, perché GPT-5.2 viene posizionato sopra GPT-5.1 e il salto è più marcato sulla variante Pro.

Il terzo riguarda la competizione. Reuters descrive la dinamica competitiva come uno dei motori della rapidità del lancio, in un contesto di accelerazione tra piattaforme.

Sicurezza e governance: safe completion e preparedness

Il tema della sicurezza, in GPT-5.2, è inseparabile dall’uso professionale e dalla capacità di agire. OpenAI insiste sulla continuità del quadro di mitigazioni introdotto nella serie GPT-5, compresa la “safe completion”, che mira a produrre risposte utili entro i confini delle policy invece di rifiuti generici.

Nel post di rilascio compaiono anche metriche dedicate a conversazioni sensibili, con punteggi su salute mentale, auto‑lesionismo e rischio di dipendenza emotiva che risultano, in media, migliori per GPT-5.2 rispetto alle versioni precedenti almeno in alcune combinazioni.

Il system card update entra inoltre in aspetti meno visibili ma cruciali per l’adozione, come la robustezza a prompt injection in scenari con connettori e chiamate di funzione. Nel documento compaiono anche valutazioni esterne sulle capacità cyber in sfide offensive controllate, con una discussione esplicita sui limiti di generalizzazione.

In parallelo OpenAI indica che tratta questo lancio come “high capability” nel dominio biologico e chimico, attivando salvaguardie di preparedness e precisando di non avere evidenze definitive che il modello possa aiutare in modo significativo un novizio a causare danni biologici severi, pur sottolineando che la traiettoria richiede priorità di valutazione.

Conclusione

A pochi giorni dall’uscita, quindi con un numero ancora limitato di test indipendenti e con integrazioni in pieno rollout, il quadro appare già leggibile.

GPT-5.2 sembra puntare a un obiettivo pratico: ridurre l’attrito tra intenzione e consegna, trasformando il modello in un motore di esecuzione per flussi reali. I benchmark più convincenti sono quelli che misurano sequenze, strumenti e contesto lungo, perché sono i punti in cui l’uso quotidiano tende a fallire.

Le criticità restano e non sono marginali. Servono controllo umano, tracciabilità e progettazione attenta delle integrazioni, soprattutto dove una risposta diventa un’azione. Ma l’insieme di numeri, integrazioni immediate e discussioni tra utenti indica che GPT-5.2 non è solo un incremento incrementale.

È un segnale di maturazione dell’AI come infrastruttura di lavoro, con conseguenze positive e problematiche che, da qui in avanti, saranno sempre più difficili da separare.

Bibliografia

- OpenAI, “Presentiamo GPT-5.2 / Introducing GPT-5.2”, 11 dicembre 2025. https://openai.com/it-IT/index/introducing-gpt-5-2/

- OpenAI, “Update to GPT-5 System Card: GPT-5.2” (pagina), 11 dicembre 2025. https://openai.com/index/gpt-5-system-card-update-gpt-5-2/

- OpenAI, “Update to GPT-5 System Card: GPT-5.2” (PDF), 11 dicembre 2025. https://cdn.openai.com/pdf/3a4153c8-c748-4b71-8e31-aecbde944f8d/oai_5_2_system-card.pdf

- OpenAI, “Advancing science and math with GPT-5.2”, 2025. https://openai.com/index/gpt-5-2-for-science-and-math/

- OpenAI Platform, “GPT-5.2 model docs” (modello e prezzi), dicembre 2025. https://platform.openai.com/docs/models/gpt-5.2

- Reuters, “OpenAI launches GPT-5.2 after ‘code red’ push to counter Google’s Gemini 3”, 11 dicembre 2025. https://www.reuters.com/technology/openai-launches-gpt-52-ai-model-with-improved-capabilities-2025-12-11/

- WIRED (US), “OpenAI Launches GPT-5.2 as It Navigates ‘Code Red’”, dicembre 2025. https://www.wired.com/story/openai-gpt-launch-gemini-code-red/

- Business Insider, “OpenAI says its new GPT 5.2 set a ‘new state-of-the-art score’ for professional knowledge work”, dicembre 2025. https://www.businessinsider.com/openai-gpt-5-2-update-release-2025-12

- Microsoft, “Available today: GPT-5.2 in Microsoft 365 Copilot”, 11 dicembre 2025. https://www.microsoft.com/en-us/microsoft-365/blog/2025/12/11/available-today-gpt-5-2-in-microsoft-365-copilot/

- GitHub Blog Changelog, “OpenAI’s GPT-5.2 is now in public preview for GitHub Copilot”, 11 dicembre 2025. https://github.blog/changelog/2025-12-11-openais-gpt-5-2-is-now-in-public-preview-for-github-copilot/

- JetBrains Plugins, “Junie, the AI coding agent by JetBrains” (scheda plugin e note di versione), dicembre 2025. https://plugins.jetbrains.com/plugin/26104-junie-the-ai-coding-agent-by-jetbrains