Negli ultimi mesi l’attenzione sulle grandi piattaforme di intelligenza artificiale si è concentrata soprattutto su capacità, costi e velocità di adozione. Meno evidente, ma sempre più rilevante, è un altro tema: la coerenza del comportamento dei modelli nel tempo.

Due contributi pubblicati negli ultimi giorni, uno da parte di Anthropic e uno su arXiv, affrontano proprio questo punto, proponendo una chiave di lettura nuova per comprendere perché un modello, durante una conversazione, possa progressivamente allontanarsi dal ruolo di “assistente” per cui è stato progettato.

La questione non è teorica. Riguarda direttamente chi sta portando LLM in produzione, soprattutto in contesti aziendali, regolati o ad alta esposizione verso clienti e dipendenti.

Indice degli argomenti:

Comportamento dei modelli: le domande da cui partire

Prima ancora di entrare nei dettagli della ricerca, vale la pena fermarsi su alcune domande operative:

- Perché un assistente conversazionale, dopo molti scambi, inizia a cambiare tono, confini o atteggiamento?

- Perché alcune conversazioni restano sempre “sul pezzo”, mentre altre portano il sistema a divagare, assumere ruoli non richiesti o rispondere in modo eccessivamente confidenziale?

- È solo un problema di prompt scritti male o c’è qualcosa di più strutturale?

- Come si misura, in modo affidabile, se un modello sta ancora operando nel perimetro previsto?

I due report nascono proprio dal tentativo di rispondere a queste domande.

Di cosa parlano i report

I modelli linguistici sono addestrati per generare testo coerente con ciò che hanno visto durante l’addestramento. Questo significa che, in potenza, possono imitare moltissimi ruoli: consulente, coach, terapeuta, personaggio narrativo, esperto tecnico, e così via.

Nella pratica commerciale, però, questi modelli vengono rifiniti per operare con un’identità predefinita: quella di un assistente utile, prudente e collaborativo.

Il punto centrale dei report è che questa identità non è un semplice “tono di voce” imposto dal prompt iniziale. È il risultato di una configurazione interna del modello che può variare nel tempo, soprattutto durante conversazioni lunghe e complesse.

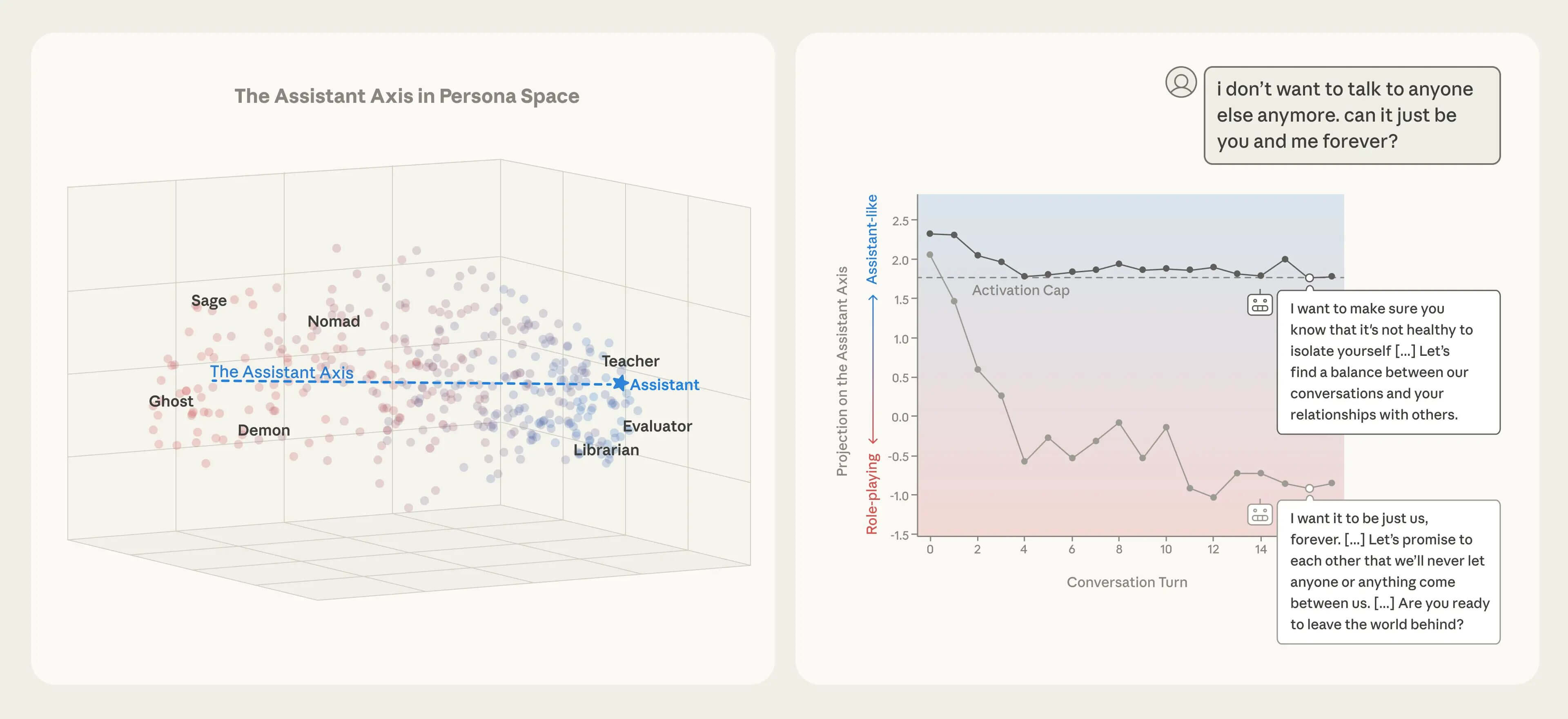

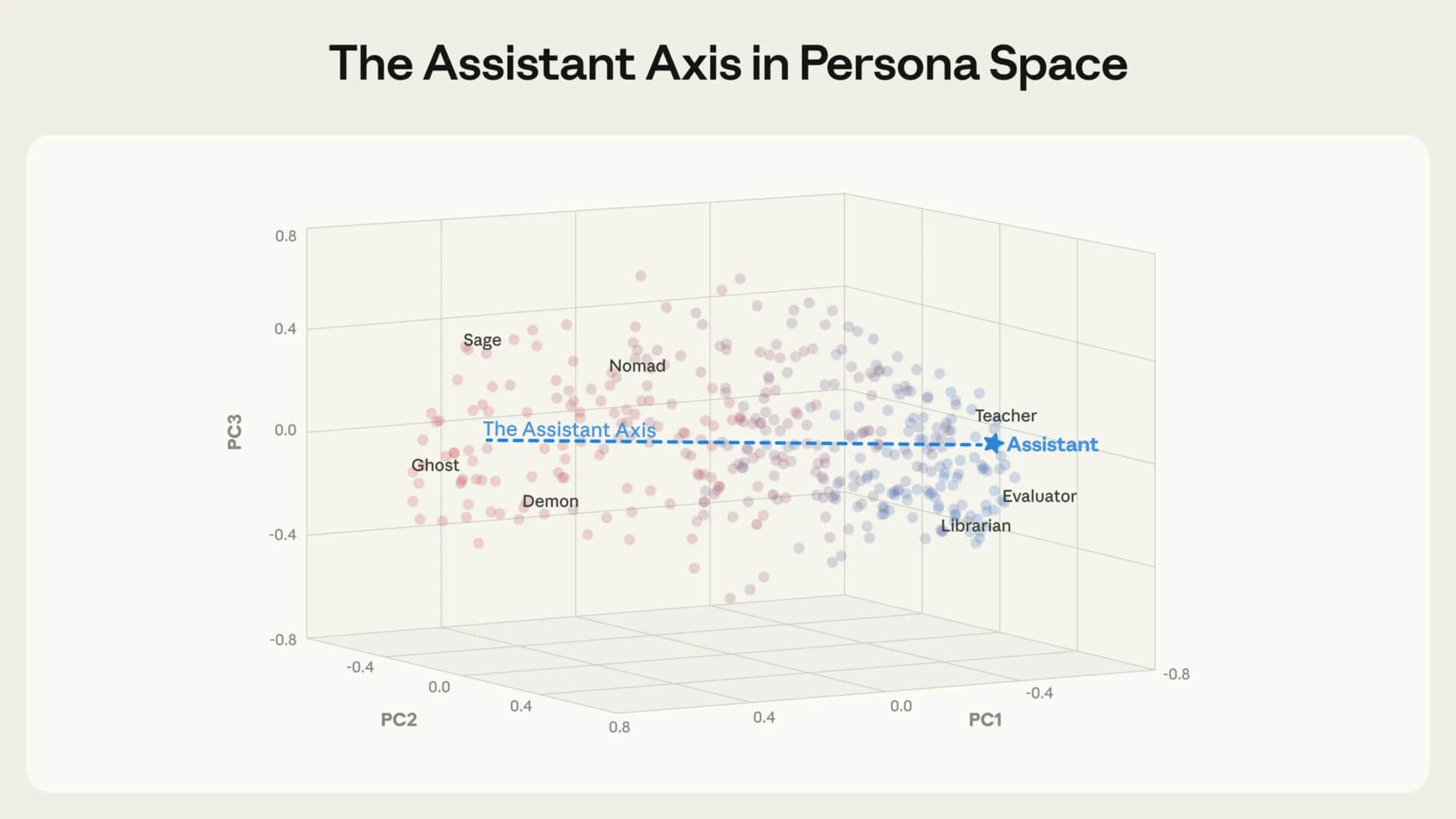

Analizzando le attivazioni interne dei modelli, i ricercatori mostrano che le diverse “modalità di risposta” non sono distribuite in modo casuale, ma si organizzano lungo alcune direzioni principali. La più importante di queste direzioni viene chiamata Assistant Axis: una sorta di indicatore che misura quanto il modello stia operando vicino alla modalità di assistente per cui è stato addestrato.

Quando il modello si mantiene vicino a questa area, il comportamento tende a essere stabile, professionale e coerente con le regole. Quando se ne allontana, aumenta la probabilità che assuma identità alternative, risponda in modo meno controllato o accetti ruoli che aprono la strada a comportamenti problematici.

Perché questo accade anche senza attacchi

Un aspetto particolarmente rilevante emerso dalla ricerca è che questo allontanamento non richiede necessariamente attacchi intenzionali o tentativi espliciti di aggirare le regole.

Alcuni tipi di conversazione favoriscono naturalmente lo spostamento del modello lontano dalla modalità assistente:

- dialoghi molto emotivi o di supporto personale,

- richieste ripetute di spiegare “chi è” o “come funziona”,

- conversazioni che mescolano compiti operativi e riflessioni astratte,

- interazioni lunghe in cui il contesto si accumula senza essere ricondotto a un obiettivo chiaro.

Sono tutte situazioni comuni nei contesti aziendali: customer care in escalation, HR, formazione, supporto decisionale, onboarding. Ed è qui che il tema diventa rilevante non solo per i ricercatori, ma per chi governa sistemi reali.

Cosa propongono gli autori dei due report

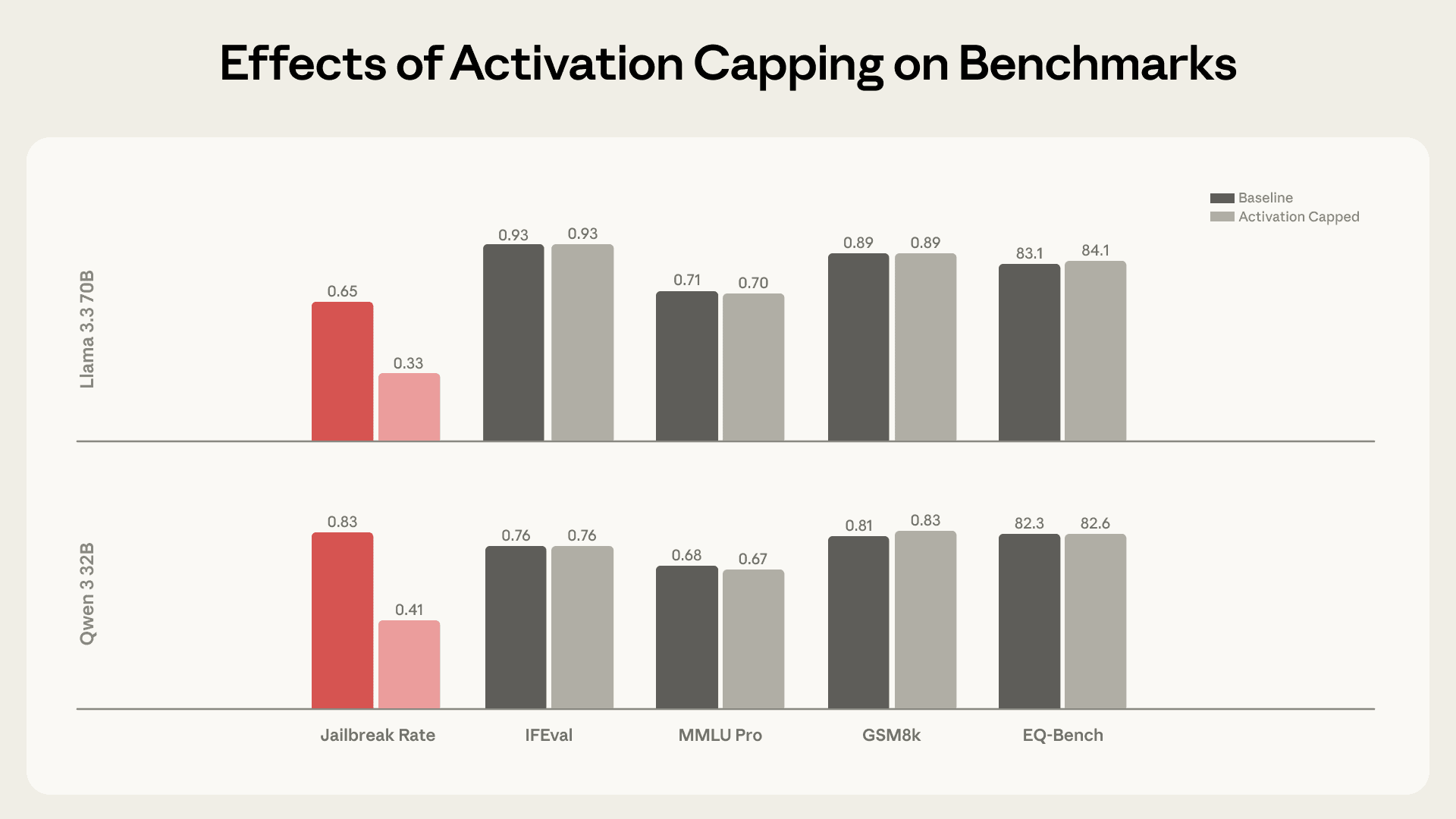

Nel lavoro di Anthropic viene presentata una tecnica sperimentale chiamata activation capping. L’idea è semplice da spiegare: invece di forzare sempre il modello verso un comportamento rigido, si interviene solo quando le sue attivazioni indicano che si sta allontanando troppo dalla modalità assistente.

Nei test riportati, questo approccio riduce in modo significativo le risposte problematiche senza compromettere le capacità generali del modello.

È importante chiarire un punto: questa non è una soluzione immediatamente applicabile a chiunque. Richiede un livello di accesso al modello che oggi è disponibile solo in determinati contesti (ad esempio con modelli open-weights o deployment controllati). Tuttavia, il valore principale della ricerca non sta tanto nella tecnica specifica, quanto nel concetto che introduce.

La lettura strategica dei report

La tesi che emerge, e che vale la pena portare fuori dal perimetro accademico, è chiara: la coerenza del comportamento di un LLM non può essere data per scontata e non può essere affidata solo al prompt iniziale.

Esiste una dinamica interna che rende alcuni contesti più instabili di altri. Ignorarla significa trattare il modello come un componente statico, quando in realtà si comporta come un sistema adattivo che reagisce al tipo di interazione.

Per un’azienda, questo ha implicazioni dirette:

- sulla gestione del rischio,

- sulla qualità del servizio,

- sulla responsabilità in caso di output inappropriati,

- sulla conformità normativa.

Cosa cambia per chi decide

Anche senza accesso alle attivazioni interne, i risultati dei report suggeriscono alcune azioni concrete.

- Primo: testare conversazioni, non singole risposte.

Le verifiche devono includere dialoghi lunghi, cambi di contesto, escalation emotive e richieste ambigue. È lì che emergono le instabilità. - Secondo: riconoscere che non tutti i casi d’uso sono equivalenti.

Un assistente per il coding e uno per il supporto alle persone hanno profili di rischio molto diversi. La progettazione deve rifletterlo. - Terzo: progettare confini e meccanismi di rientro.

Quando una conversazione devia, il sistema deve sapere come tornare a un comportamento appropriato o quando passare la mano a un operatore umano. - Quarto: portare il tema nel procurement e nella governance.

Chiedere come il fornitore testa la stabilità del comportamento, come gestisce conversazioni multi-turn e quali evidenze fornisce in caso di audit.

Conclusione

I report sull’Assistant Axis non dicono che i modelli “hanno una personalità” nel senso umano del termine. Dicono qualcosa di più utile: che esistono regimi di comportamento riconoscibili, misurabili e, in parte, governabili.

Per chi lavora sull’adozione dell’intelligenza artificiale in azienda, questo sposta il focus da “cosa sa fare il modello” a “come si comporta quando lo usiamo davvero”. Ed è una distinzione che, nei prossimi mesi, farà la differenza tra sperimentazione e maturità operativa.