L’intelligenza artificiale è diventata la protagonista di ogni conversazione sull’innovazione, ma la sua applicazione nei processi di modernizzazione del software rivela confini tecnici e logici che non possono essere ignorati. Michele Slocovich, solution design director di Cast Italia, ha affrontato questo nodo cruciale in occasione del convegno organizzato dall’Osservatorio Cloud Transformation del Politecnico di Milano, sottolineando come l’AI, pur rappresentando una straordinaria leva di accelerazione, resti uno strumento fallibile, bisognoso di guida, controllo e consapevolezza.

applicazioni

I limiti dell’AI nella modernizzazione applicativa: quando l’automazione non basta

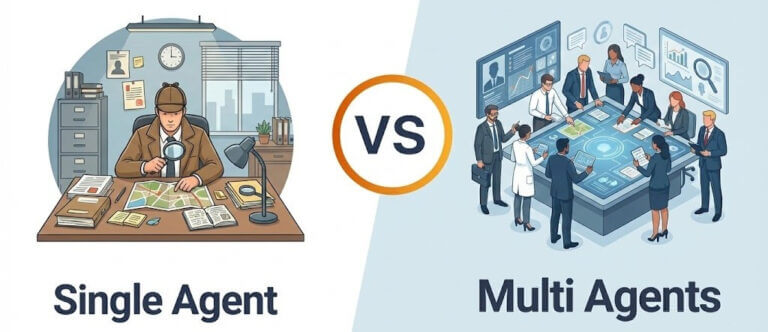

Quando un’organizzazione si affida all’AI nella trasformazione dei propri applicativi, scopre presto che l’automazione totale non è realistica. I limiti dell’AI nelle attività di refactoring, ottimizzazione e migrazione emergono proprio nei casi più complessi. Serve un’alleanza con la software intelligence per preservare controllo, trasparenza e qualità

Continua a leggere questo articolo

Aziende

Argomenti

Canali