L’ausilio degli strumenti di generazione del codice basati su intelligenza artificiale stanno apportando profonde modifiche alla programmazione e al lavoro quotidiano degli sviluppatori. Sistemi come GitHub Copilot, Cursor AI e ChatGPT oltre a diventare parte integrante delle sessioni di sviluppo, ha semplificato i processi ridotto i tempi di consegna e aumentato l’efficienza dei team. Ma dietro questa accelerazione della produttività si nasconde una nuova vulnerabilità che potrebbe minare la sicurezza dell’intera supply chain software: lo slopsquatting.

Indice degli argomenti:

Quando l’AI “inventa” il software

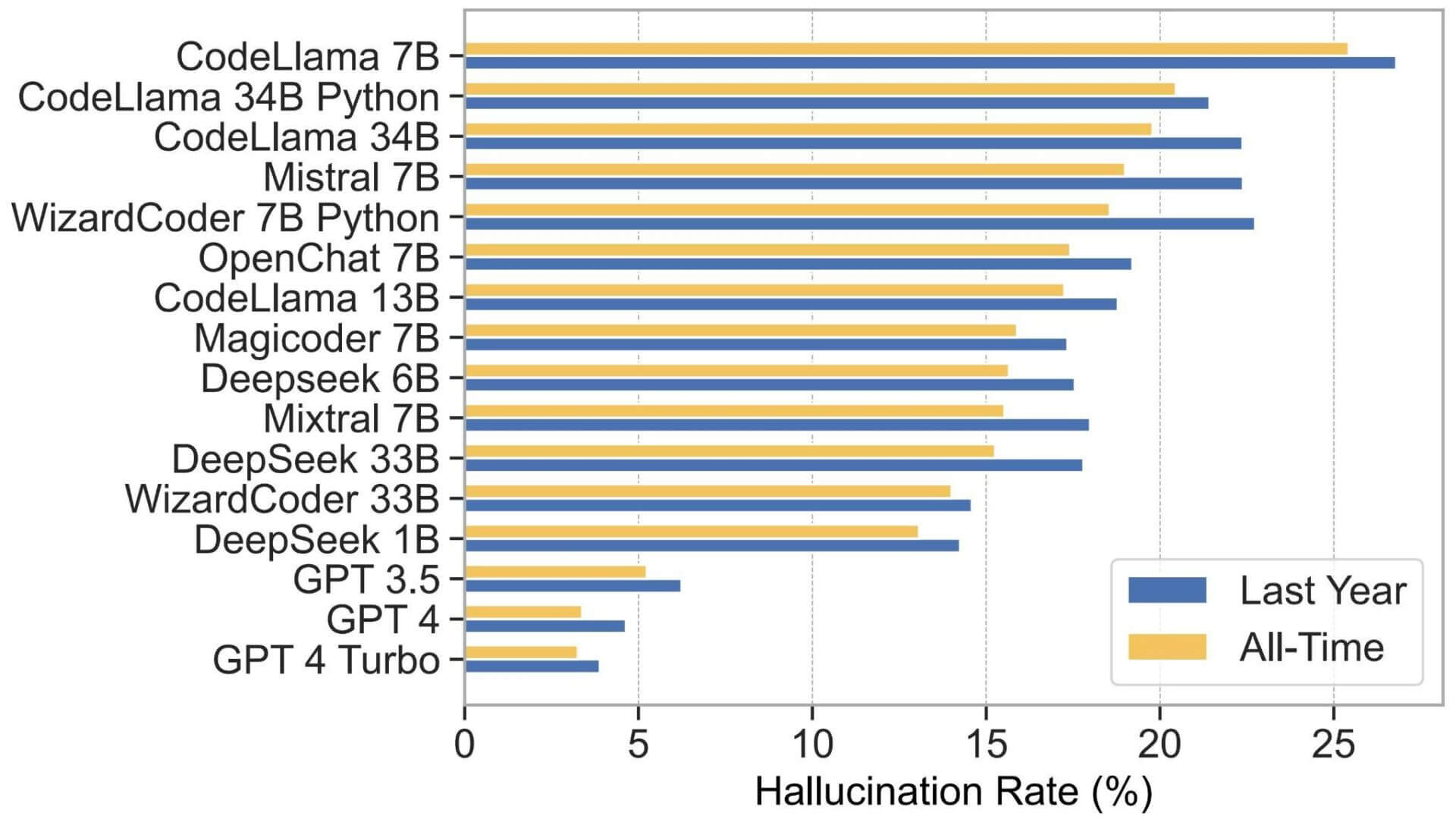

Il problema nasce dalle cosiddette “allucinazioni” dei modelli di intelligenza artificiale. Si tratta di suggerimenti di pacchetti software che non esistono ma che, per nome e struttura, sembrano del tutto plausibili. Uno studio condotto da tre università statunitensi – Texas a San Antonio, Oklahoma e Virginia Tech – ha rilevato che i modelli open-source commettono questo tipo di errore con una frequenza preoccupante: oltre il 20% dei suggerimenti analizzati si è rivelato inesistente. Gli strumenti commerciali fanno meglio, ma registrano comunque un tasso di errore attorno al 5%.

Questi pacchetti inventati sono difficili da riconoscere perché imitano in modo convincente quelli reali. In alcuni casi, il problema si complica ulteriormente con una sorta di “contaminazione linguistica”: assistenti addestrati su Python hanno suggerito pacchetti JavaScript inesistenti, un fattore che può disorientare anche sviluppatori esperti.

Dallo “scherzo” al rischio globale

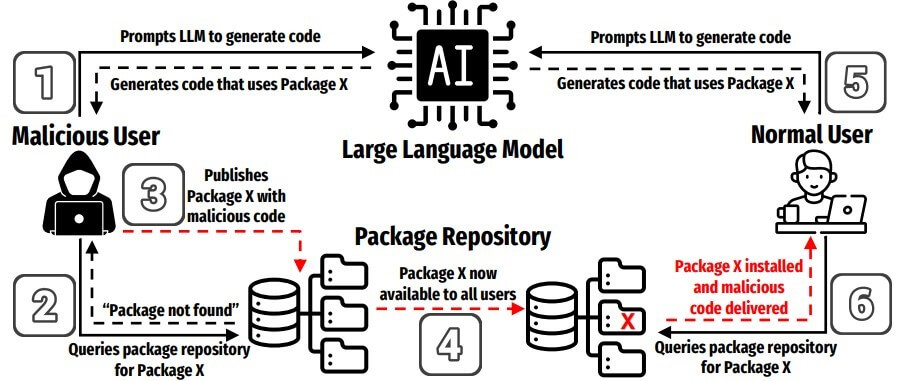

Gli hacker hanno colto rapidamente l’opportunità e hanno creato una variante del typosquatting chiamata slopsquatting. Invece di sfruttare errori di battitura, questa tecnica si basa sugli stessi pacchetti inesistenti suggeriti dall’AI. Gli aggressori registrano questi nomi su repository ufficiali come npm o PyPI, all’interno del quale inseriscono codice malevolo. Quando uno sviluppatore si fida delle raccomandazioni dell’AI e installa il pacchetto, introduce inconsapevolmente una backdoor o un malware nel proprio progetto.

Un episodio avvenuto alla fine del 2023 ha dimostrato la portata del problema. Un ricercatore di sicurezza ha registrato il pacchetto inesistente “huggingface-cli”, spesso suggerito da alcuni modelli AI, come test innocuo. In pochi giorni migliaia di sviluppatori lo hanno installato, inclusi team di grandi aziende come Alibaba. Se quell’esperimento fosse stato malevolo, le conseguenze sarebbero state devastanti.

La vulnerabilità della catena di distribuzione

Le moderne pipeline di integrazione e distribuzione continua (CI/CD) amplificano il rischio: un singolo pacchetto compromesso può propagarsi rapidamente fino agli ambienti di produzione, compromettendo applicazioni e servizi in modo capillare. Gli strumenti di sicurezza tradizionali, basati sulla reputazione storica dei pacchetti, non sono pronti a intercettare minacce così nuove e dinamiche.

Per questo motivo diventa cruciale introdurre controlli più rigorosi e processi di verifica manuale, affiancati da una maggiore consapevolezza degli sviluppatori. Gli esperti consigliano di utilizzare lockfile, versioni fissate e controlli crittografici sugli hash per garantire l’integrità dei pacchetti, oltre a mantenere repository interni affidabili.

L’equilibrio tra sicurezza e produttività

Alcuni ricercatori stanno sperimentando soluzioni tecniche per ridurre le allucinazioni, come la retrieval augmented generation (RAG) o la supervisione avanzata. Queste strategie riescono a ridurre gli errori fino all’85%, ma rischiano di degradare la qualità complessiva del codice generato. La sfida è quindi trovare un equilibrio tra velocità di sviluppo e sicurezza. Allo stesso tempo, la cultura organizzativa gioca un ruolo chiave. La revisione tra pari dei pacchetti, l’adozione di policy interne e la formazione specifica sono strumenti indispensabili per evitare che le raccomandazioni dell’AI vengano accettate senza un controllo critico.