Negli ultimi anni, l’uso dell’intelligenza artificiale in ambito medico ha raggiunto nuove frontiere. Dalle mammografie AI-assistite per la diagnosi precoce del tumore al seno, fino alla previsione di complicazioni come la sepsi o l’insufficienza renale acuta, i modelli predittivi promettono di anticipare i sintomi, prevenire crisi sanitarie e ottimizzare le risorse. Questa spinta si basa su una verità: la medicina moderna è un esercizio di riconoscimento di pattern. Tuttavia, anche l’occhio più esperto può mancare segnali sfumati o eventi che si manifestano in modo caotico. Da qui, il ruolo dei modelli supervisionati, capaci di apprendere da grandi moli di dati etichettati, estraendo correlazioni statistiche invisibili al medico.

Indice degli argomenti:

Quando il modello “funziona” troppo bene: il paradosso della previsione efficace

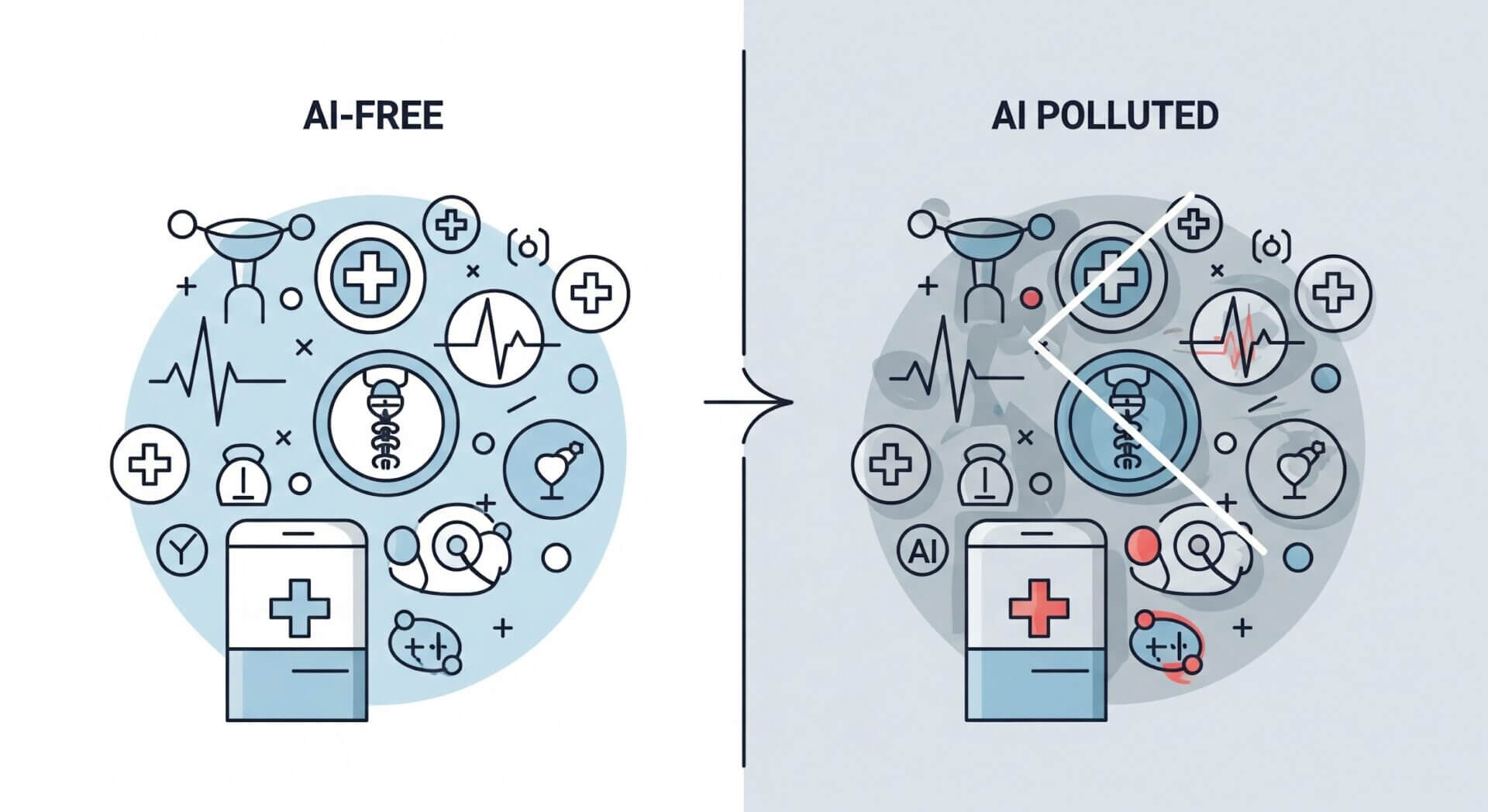

L’efficienza dei modelli predittivi è valutata sulla loro capacità di generalizzare. Ma se il loro impatto modifica i dati che li alimentano, si crea un circolo vizioso. È il caso tipico dei sistemi che rilevano precocemente la sepsi: se un medico interviene in tempo sulla base di una previsione, il paziente non svilupperà la condizione. Il dato registrato nel sistema, però, collegherà quel quadro clinico a un esito positivo, e non a un aggravamento. Si parla così di “contaminazione del dato”: i segnali di allarme, inizialmente associati alla malattia, diventano nel tempo indicatori di salute apparente. Questo distorce i dataset futuri, compromettendo la formazione di nuovi modelli o il retraining di quelli esistenti.

Il problema della coesistenza: quando i modelli si intralciano a vicenda

I modelli non operano nel vuoto. In ambienti clinici complessi, diversi algoritmi predittivi possono agire in parallelo: uno può monitorare il rischio di trombosi, un altro quello di insufficienza renale. Ma entrambi si basano su biomarcatori comuni, come la creatinina. L’intervento suggerito da un modello può alterare i parametri rilevanti per un altro, rendendone inattendibili le previsioni. A questo si aggiunge l’ambiguità nella valutazione delle performance. Se un modello previene con successo un evento avverso, quel rischio non si materializza: il sistema potrebbe erroneamente considerarlo meno efficace. Ma un calo di prestazioni può anche derivare da un reale peggioramento. Senza un confronto sperimentale o periodi di inattività del modello, capire cosa sta succedendo diventa quasi impossibile.

Dunque, i dati medici non influenzati da AI stanno diventando una risorsa rara e preziosa. Diverse le soluzioni all’orizzonte. Tra queste, taggare i dati influenzati da AI, distinguendo le decisioni mediche autonome da quelle guidate da algoritmi. Oltre a creare dataset oro derivati da strutture che non utilizzano ancora modelli predittivi. Ma anche sviluppare modelli causali, in grado di cogliere meccanismi sottostanti e non solo correlazioni statistiche.

Intelligenza artificiale in medicina: etica, costi e complessità, la necessità di una governance strategica

Le implicazioni non sono solo tecniche. Gli ospedali dovranno decidere quanti modelli attivare, quali far prevalere e come garantire coerenza nei trattamenti. Aumenteranno i costi infrastrutturali e la complessità organizzativa. Potrebbero nascere strutture “feeder”, cioè ospedali appositamente privi di AI per generare dati “puri”. Ma ciò solleva questioni etiche: è accettabile privare alcuni pazienti di strumenti potenzialmente salvavita per motivi di ricerca?

Conclusioni: un futuro promettente, ma fragile

La medicina predittiva ha un potenziale straordinario. Tuttavia, l’adozione incontrollata dei modelli AI potrebbe minare la qualità dei dati su cui essa stessa si fonda. Per non sacrificare l’affidabilità futura ai vantaggi immediati, serve una riflessione collettiva e una documentazione sistematica degli interventi influenzati da AI. I dati clinici “toccati” dall’intelligenza artificiale non possono più essere considerati neutrali. E per costruire una medicina del futuro davvero solida, dobbiamo sapere esattamente dove si trovano.