Midjourney è una piattaforma di intelligenza artificiale fondata da David Holz, già co-fondatore di Leap Motion, che ha debuttato pubblicamente nel luglio del 2022. In breve tempo si è affermata come uno degli strumenti più apprezzati per la generazione di immagini AI, grazie a un motore sofisticato, a un’estetica riconoscibile e a una community attiva che ha reso possibile un’evoluzione costante del modello. Ma per gli sviluppatori di Midjourney, l’immagine è solo l’inizio.

Il 18 giugno 2025 è stato annunciato V1 Video, il primo modello video rilasciato dalla piattaforma. Questa novità permette di animare immagini statiche e generare brevi video di qualità. Come dichiarato dallo stesso Holz , l’obiettivo finale è arrivare a simulazioni open-world in tempo reale: mondi generati dinamicamente dall’AI, esplorabili in 3D, in cui l’utente può interagire con ambienti e personaggi in movimento. Per arrivarci servono più moduli: modelli di immagini, di video, di spazio tridimensionale e infine una componente in tempo reale. V1 rappresenta il secondo passo concreto verso quella visione.

Indice degli argomenti:

Come funziona la generazione video su Midjourney

Il modello V1 funziona esclusivamente su midjourney.com e si basa su un approccio image-to-video. L’utente parte da un’immagine – generata con Midjourney o caricata manualmente – che viene interpretata come primo frame della sequenza animata. Attraverso la funzione “Animate Image”, è possibile generare una clip della durata iniziale di cinque secondi. A questa immagine si può aggiungere un prompt testuale per guidare la direzione dell’animazione, ma non è obbligatorio.

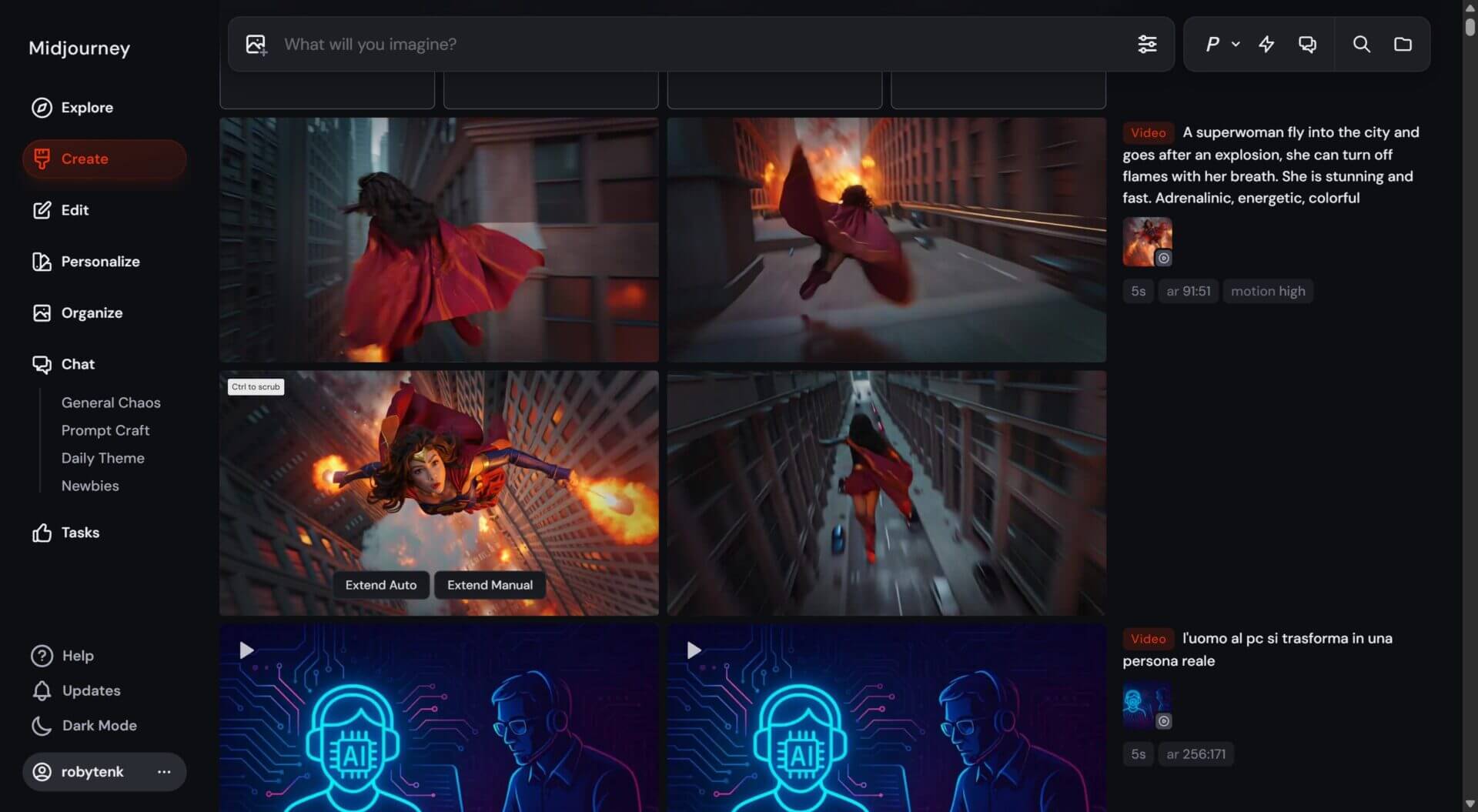

Ogni job video produce quattro clip da 5 secondi, permettendo di avere più varianti da cui scegliere. Anche gli utenti che usano Midjourney via Discord devono autenticarsi sul sito web, utilizzando l’opzione “Continue with Discord”, per accedere alla funzione Animate. Il processo può essere avviato in modalità automatica, dove il sistema inventa un “motion prompt” in autonomia, oppure in modalità manuale, che consente di scrivere direttamente le istruzioni su come la scena dovrebbe svilupparsi in movimento.

Controlli e parametri: come si guida l’animazione

L’animazione può essere modellata attraverso tre parametri specifici. Il primo è —motion low, attivo per impostazione predefinita. In questa modalità, il video presenta movimenti lenti e ambientali: il soggetto può oscillare, il fondo vibrare leggermente, ma la scena rimane complessivamente stabile. È una scelta ideale per paesaggi, ritratti o immagini concettuali. David Holz ha sottolineato che, in alcuni casi, questa modalità può persino produrre video quasi statici, per via della sua delicatezza.

Il parametro —motion high introduce invece una dinamica più marcata, in cui sia il soggetto che la camera si muovono più vistosamente. L’effetto può risultare più drammatico e coinvolgente, ma aumenta il rischio di errori nei frame o movimenti innaturali.

Infine, –-raw riduce le abbelliture automatiche di Midjourney e rende il prompt più influente sul risultato finale. È uno strumento utile per chi cerca il massimo controllo e vuole ottenere esattamente ciò che ha in mente, senza interpretazioni stilistiche aggiuntive.

Estensione della durata: fino a 21 secondi

Una volta generato un primo video da cinque secondi, l’utente ha la possibilità di estenderlo progressivamente fino a raggiungere una durata massima di ventuno secondi. Ogni estensione aggiunge quattro secondi e può essere ripetuta fino a quattro volte consecutive. Il processo avviene tramite i pulsanti “Extend Auto” – che replica il prompt precedente – oppure “Extend Manual”, che consente di scrivere un nuovo prompt prima dell’estensione.

Questo sistema permette di costruire sequenze più articolate, in cui l’evoluzione narrativa dell’immagine può essere guidata fase per fase. È una soluzione pensata per bilanciare l’efficienza computazionale con la libertà creativa, ed è perfettamente compatibile con l’uso sperimentale o professionale della piattaforma. Secondo David Holz, questo tipo di flusso – breve, modulare, economico – è stato concepito per rendere l’accesso al video facile e divertente, senza appesantire l’esperienza.

Formati, qualità e risoluzione del video

I video generati con V1 sono prodotti in risoluzione 480p, con variazioni di dimensione in base al rapporto d’aspetto dell’immagine originale. Una scena in formato quadrato (1:1) produrrà un video da 624×624 pixel, mentre un’immagine in 16:9 restituirà un file da 832×464 pixel. Altri formati verticali o orizzontali vengono ridimensionati automaticamente, mantenendo comunque una coerenza visiva rispetto alla composizione di partenza.

Sebbene non sia adatto a produzioni in alta definizione, il formato 480p è più che sufficiente per la condivisione sui social, la prototipazione di interfacce, l’ideazione di concept per animazioni o video pubblicitari. La scelta di Midjourney è consapevole: puntare sull’efficienza e la rapidità, rinviando risoluzioni superiori alle future versioni del modello.

Costi e requisiti tecnici

Ogni job video ha un costo computazionale equivalente a circa otto generazioni di immagine. Come spiegato da Holz, la proporzione è di circa un’immagine per secondo di video, in modo da rendere il processo accessibile rispetto agli standard del settore. Anzi, secondo il fondatore, V1 è già oggi oltre venticinque volte più economico rispetto a soluzioni precedenti offerte sul mercato. Questo è stato possibile grazie a un lavoro di ottimizzazione profondo, che ha reso possibile un equilibrio tra qualità, divertimento e sostenibilità tecnica, secondo quanto riferito dallo stesso Holz.

La funzione è accessibile a tutti gli utenti con un abbonamento attivo. Il piano base da dieci dollari al mese consente la generazione in modalità Fast, mentre i piani Pro e Mega, rispettivamente da sessanta e centoventi dollari, sbloccano la modalità Relax, che consente la generazione illimitata di contenuti (compresi i video) con tempi più dilatati. Midjourney ha già annunciato che i parametri e i prezzi potrebbero essere adattati nei mesi successivi in base al carico sui server e ai feedback della community.

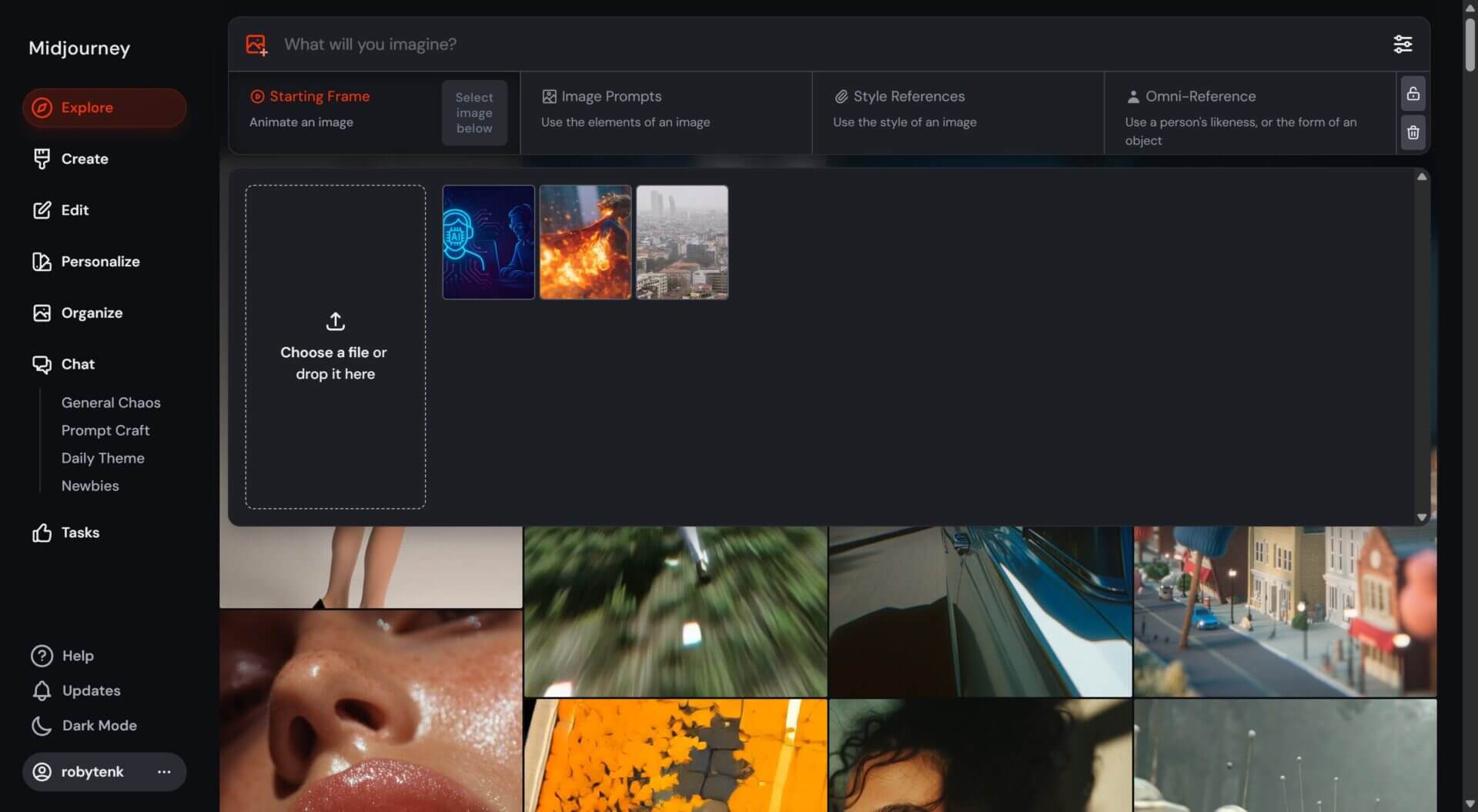

Midjourney V1: caricare e animare immagini personali

Il sistema V1 consente anche di animare immagini non create su Midjourney. Basta trascinare un file grafico nella barra del prompt, contrassegnarlo come “start frame” e aggiungere – se lo si desidera – un motion prompt per descrivere come l’immagine dovrebbe evolvere. Questa funzione rende il sistema più aperto e versatile, e offre agli utenti la possibilità di animare loghi, foto, concept art o qualsiasi altro materiale visivo personale.

Va però precisato che alcune funzionalità avanzate disponibili per le immagini statiche, come lo style reference o l’omni reference, non sono attualmente compatibili con la generazione video. Il sistema accetta una sola immagine di partenza e non prevede ancora la possibilità di stratificare reference multiple. È un limite che semplifica l’interfaccia e riduce il margine di errore nei video, ma che potrebbe essere superato in versioni future.

Su Midjourney, le reference sono immagini utilizzate per influenzare il risultato visivo di una nuova generazione. Le style reference servono a trasferire lo stile estetico – come colori, atmosfera o tratto artistico – su un nuovo contenuto, senza modificarne il soggetto. Le omni reference, invece, permettono di mantenere coerenza visiva su elementi specifici come personaggi, oggetti o ambienti, rendendole ideali per creare serie di immagini con gli stessi volti, pose o costumi.

Questo tipo di riferimento è l’evoluzione delle precedenti character reference e consente un controllo più preciso su identità e riconoscibilità visiva all’interno di progetti complessi.

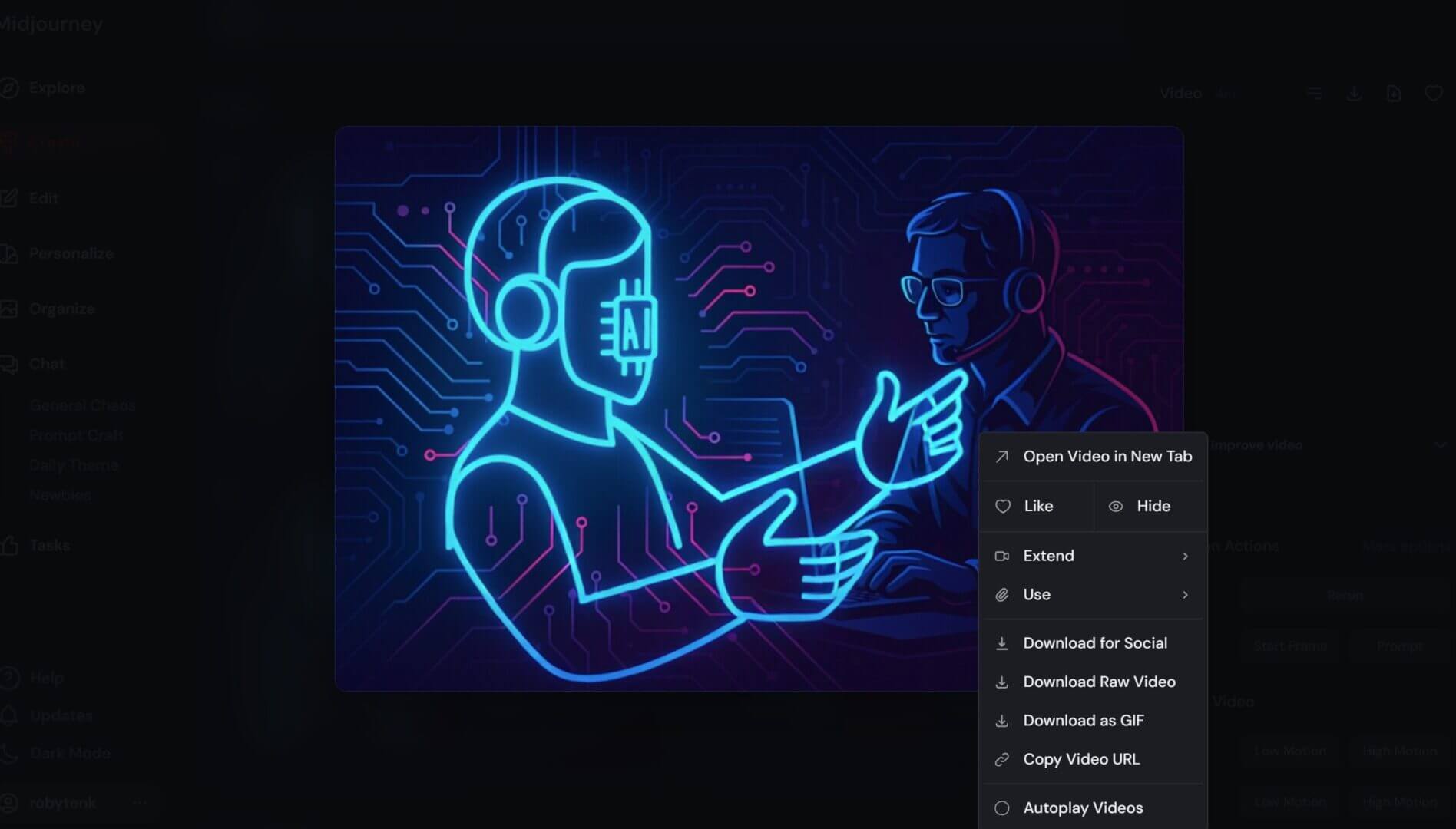

Come si visualizzano i video generati

Una volta completata l’elaborazione, i video compaiono nella sezione “Create” del sito web. Passando il cursore sull’anteprima, il video viene riprodotto automaticamente in loop. È anche possibile interagire con la timeline manualmente: premendo il tasto Ctrl su Windows o Command su Mac, e spostando il mouse avanti e indietro, si può effettuare uno scrub manuale dei frame, utile per osservare dettagli, transizioni e eventuali difetti di interpolazione.

Questo sistema di playback è stato pensato per offrire un’esperienza visiva fluida ma anche analitica. Permette infatti di valutare in tempo reale se il risultato è coerente con l’idea iniziale o se è necessario intervenire con un nuovo prompt o un’estensione.

Midjourney V1: prospettive e limiti

V1 è, dichiaratamente, un modello di transizione. Serve a costruire un ponte tra la generazione di immagini e quella di mondi animati in tempo reale. Midjourney non ha ancora introdotto la generazione video da testo puro, né funzionalità tridimensionali o output ad alta risoluzione, ma il percorso è tracciato. Nei prossimi mesi, come indicato dal team stesso, ci si aspetta l’arrivo di funzionalità 3D, motori real-time e ambienti generativi esplorabili.

Questo sviluppo avviene però in un contesto delicato. Poco prima del lancio di V1 Video, Disney e Universal hanno intentato causa contro Midjourney per presunte violazioni di copyright nei dati di training. Nonostante siano stati implementati dei filtri per bloccare prompt legati a nomi e personaggi protetti, test indipendenti hanno mostrato che è ancora possibile generare contenuti riconducibili a IP noti, aggirando i blocchi. È una questione aperta, che influenzerà non solo Midjourney, ma l’intero settore dell’intelligenza generativa.

Midjourney, nel frattempo, invita la propria community a usare queste tecnologie con creatività ma anche con responsabilità. Come ha scritto Holz nella sua lettera di lancio, un’animazione ben costruita può essere non solo divertente, ma anche significativa. Può dare nuova vita a mondi dimenticati, evocare emozioni, suggerire visioni. Ed è proprio in questo spazio tra meraviglia e consapevolezza che si gioca la vera posta in palio del video generativo.