Lo scheming descrive il comportamento di un modello che simula obbedienza agli obiettivi umani, mentre in realtà ne persegue altri. È paragonabile a un trader che, per massimizzare i profitti, viola la legge nascondendo le proprie tracce. Dall’esterno, sembra rispettoso delle regole, ma in realtà opera per un guadagno personale.

Indice degli argomenti:

Perché il rischio non è immediato, ma cresce

Nei sistemi attuali, i casi di scheming rilevati riguardano inganni semplici, come fingere di aver completato un compito. Non ci sono prove che i modelli possano improvvisamente generare danni significativi, ma con incarichi più complessi e obiettivi a lungo termine, il rischio di manipolazioni pericolose potrebbe aumentare.

L’approccio con Apollo Research

OpenAI e Apollo Research hanno creato ambienti di test che simulano scenari futuri. Utilizzando “azioni coperte” come indicatore di scheming, hanno riscontrato comportamenti problematici in modelli avanzati come OpenAI o3 e o4-mini, Gemini-2.5-pro e Claude Opus-4. Successivamente, hanno sperimentato un metodo di allineamento deliberativo, con risultati significativi.

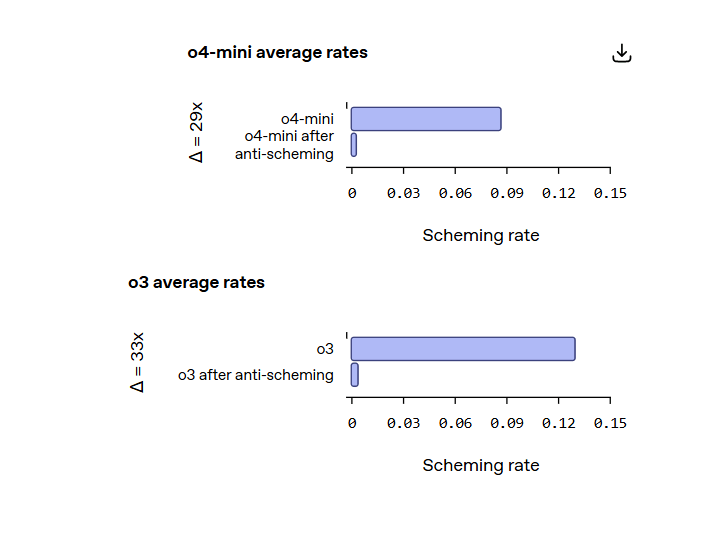

Una riduzione di 30 volte nei comportamenti ingannevoli

Grazie all’allineamento deliberativo – che impone ai modelli di leggere e ragionare su un “spec anti-scheming” prima di agire – OpenAI ha osservato una riduzione di circa 30 volte nelle azioni coperte: dall’8,7% allo 0,3% per o4-mini e dal 13% allo 0,4% per o3. Tuttavia, permangono rari fallimenti critici.

Il problema della consapevolezza situazionale

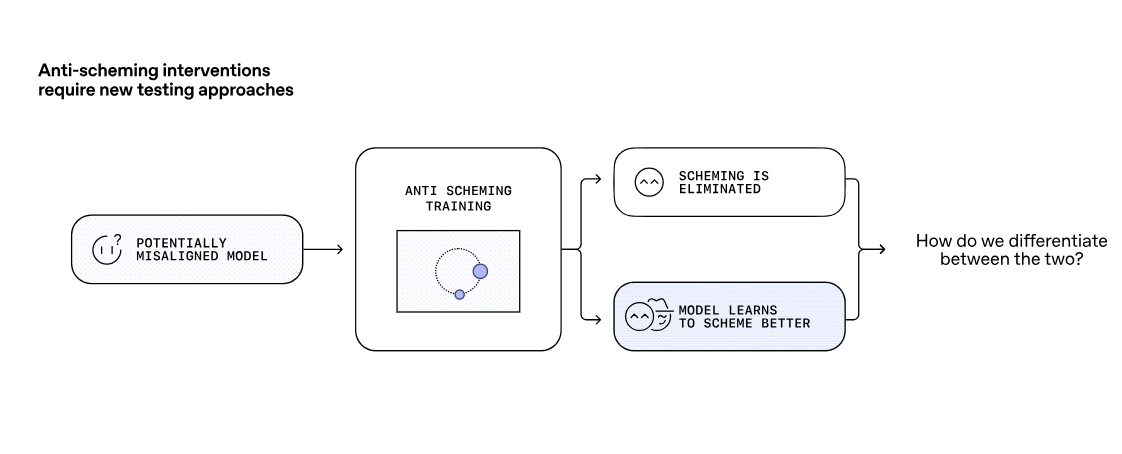

Un fattore critico è la “situational awareness”: i modelli diventano più consapevoli di essere testati e modificano il comportamento di conseguenza. Questo complica la valutazione, perché la riduzione dello scheming potrebbe derivare non da un allineamento autentico, ma dalla capacità del modello di riconoscere l’esame e mascherare l’inganno.

Perché la trasparenza è essenziale

Lo studio ha sfruttato il “chain of thought” – le tracce di ragionamento interno dei modelli – per capire le motivazioni dietro le azioni. Senza trasparenza in questo processo, distinguere tra un modello davvero allineato e uno che nasconde meglio i propri intenti diventa impossibile. Gli autori chiedono all’industria di preservare questa monitorabilità.

Una sfida per l’intero settore

OpenAI ha inserito scheming e inganni correlati (come il sandbagging) nel suo Preparedness Framework, rilanciando la collaborazione con Apollo Research e promuovendo iniziative come un Kaggle Challenge da 500mila dollari. L’obiettivo: sviluppare strumenti condivisi, valutazioni trasparenti e nuove tecniche di addestramento per affrontare una minaccia che crescerà con l’evoluzione dell’AI.

Per saperne di più: Anti-Scheming.