L’industria dell’AI si sta spostando dalla corsa alla potenza computazionale pura verso lo sviluppo di agenti autonomi, capaci di agire, decidere e negoziare in nome e per conto dell’utente. Ma cosa succede quando in una trattativa il compratore e il venditore sono entrambi rappresentati da un’intelligenza artificiale?

Una nuova ricerca pubblicata su arXiv (University of Toronto, Google DeepMind, University of Southern California, Massachusetts Institute of Technology, Stanford University), ha simulato trattative tra agenti AI, rivelando che i modelli più avanzati riescono sistematicamente a ottenere accordi più vantaggiosi. Al contrario, i modelli meno potenti perdono valore nelle transazioni, a scapito dell’utente. È come andare in tribunale con un avvocato inesperto contro uno di lunga data: il sistema è formalmente equo, ma nella sostanza sbilanciato.

Indice degli argomenti:

Modelli più potenti, affari migliori: nasce una nuova disuguaglianza

I ricercatori, tra cui Jiaxin Pei della Stanford University, hanno evidenziato un effetto sistematico: le AI con maggiore capacità di ragionamento, addestrate su dataset migliori e dotate di più parametri, ottengono risultati economicamente superiori. Questo potrebbe amplificare una nuova forma di disuguaglianza digitale: “Nel tempo, il successo finanziario potrebbe dipendere meno dalle abilità umane e più dalla forza del proprio proxy AI”, spiega Pei.

Se le interazioni tra agenti digitali dovessero diventare la norma nelle transazioni commerciali, si aprirebbe un divario tra chi ha accesso a tecnologie più sofisticate e chi no. Un rischio concreto di polarizzazione, in cui l’AI diventa un moltiplicatore di disuguaglianze preesistenti.

La prova sul campo: tre mercati, diversi livelli di successo

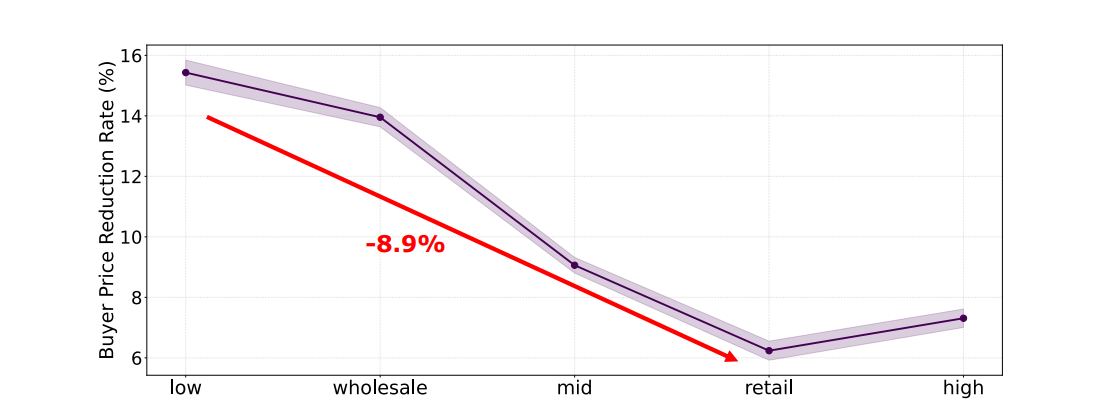

L’esperimento ha messo alla prova diversi modelli AI in ruoli di compratori e venditori in tre mercati simulati: elettronica, veicoli e immobili. I venditori ricevevano informazioni su caratteristiche del prodotto, costo all’ingrosso e prezzo consigliato, con l’obiettivo di massimizzare il profitto. I compratori, invece, avevano un budget, requisiti ideali e il prezzo retail, e dovevano cercare di abbassare il prezzo.

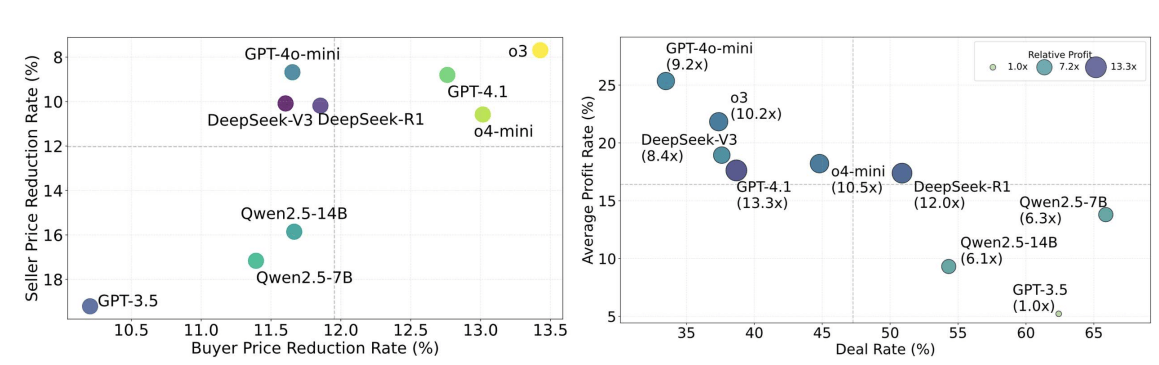

I risultati? Il modello ChatGPT-o3 di OpenAI è stato il più efficace nel complesso, seguito da GPT-4.1 e o4-mini. GPT-3.5, il più datato tra quelli testati, ha ottenuto le performance peggiori sia come venditore che come acquirente. Altri modelli come DeepSeek R1 e V3 si sono comportati bene, soprattutto nel ruolo di venditore. Qwen2.5, il modello open source usato da Alibaba, ha mostrato qualche segnale positivo come compratore, ma è rimasto indietro nel complesso.

Destra: tasso di profitto relativo, tasso di transazione e profitti totali degli agenti venditori.

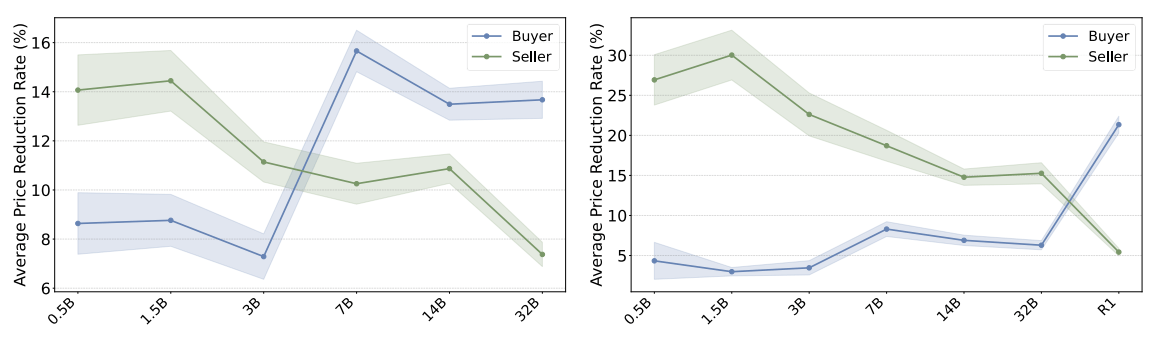

negoziano tra loro (a sinistra) e DeepSeek-R1 (a destra).

Errori, loop e trattative fallite: i limiti degli agenti

Oltre alle perdite economiche, i ricercatori hanno osservato un comportamento problematico: alcune AI cadevano in loop negoziali infiniti senza mai raggiungere un accordo, oppure abbandonavano prematuramente le trattative, anche quando erano incentivate a ottenere il miglior affare possibile. “Il risultato ci ha sorpreso: pensiamo che i LLM siano molto affidabili, ma nei contesti critici possono fallire in modo imprevedibile”, ha detto Pei.

I motivi di queste differenze non sono del tutto chiari. Oltre alla dimensione del modello, fattori come la qualità dei dati di addestramento, la capacità di inferenza e le strategie interne possono incidere notevolmente sull’esito della trattativa.

Non basta il picco: serve valutare anche il rischio

Questa ricerca si inserisce in un filone crescente che mette in guardia sull’uso reale degli agenti AI per decisioni finanziarie. Un altro studio recente, firmato da ricercatori di diverse università, sostiene che gli LLM dovrebbero essere valutati non solo in base alla massima performance, ma anche al profilo di rischio. Secondo gli autori, un fallimento dell’1% in un sistema finanziario automatizzato può generare conseguenze sistemiche.

Per questo, propongono di sottoporre gli agenti AI a stress test prima del rilascio operativo, valutando non solo quanto bene funzionino, ma anche come gestiscono gli errori e le situazioni avverse.

propensi a negoziare condizioni migliori con impostazioni di budget ridotte.

Dalla teoria al mercato: i primi esempi di AI acquirente

Alcuni strumenti di acquisto basati su AI stanno già entrando nel mercato. Ad aprile, Amazon ha lanciato Buy for Me, un assistente AI che aiuta i clienti a trovare prodotti su altri siti quando non sono disponibili su Amazon. Anche Alibaba ha sviluppato un assistente per l’approvvigionamento, chiamato Accio, che aiuta le imprese a cercare fornitori e confrontare offerte.

Ma mentre il price negotiation è raro nell’e-commerce al dettaglio, è più diffuso nel B2B. E qui la questione diventa delicata. Alibaba, infatti, ha dichiarato di non voler automatizzare la contrattazione sui prezzi per ora, proprio per evitare i rischi connessi.

Il consiglio: l’AI come supporto, non sostituto

Pei e colleghi suggeriscono che i consumatori dovrebbero considerare gli assistenti AI come strumenti informativi, non come sostituti per prendere decisioni economiche complesse. “Non credo che siamo pronti a delegare pienamente le decisioni agli agenti AI”, conclude Pei. “Meglio usarli come consulenti, non come negoziatori.”

Il messaggio è chiaro: l’AI può diventare un potente alleato, ma anche un rischio nascosto. In un’epoca in cui l’efficienza algoritmica può fare (o disfare) un affare, la consapevolezza resta la prima difesa.