I ricercatori di intelligenza artificiale si trovano ad affrontare un problema paradossale, proprio al centro del loro campo di studio: come fermare il cosiddetto “AI slop” – contenuti scientifici scadenti generati dall’AI – prima che comprometta la fiducia nel lavoro scientifico del settore.

Negli ultimi mesi, diverse conferenze accademiche sull’AI hanno imposto restrizioni all’uso dei modelli linguistici di grandi dimensioni (LLM) per la scrittura e la revisione degli articoli, dopo essere state sommerse da contributi di bassa qualità prodotti dall’intelligenza artificiale.

Indice degli argomenti:

Un’ondata di contenuti scadenti

Secondo numerosi scienziati, l’aumento di materiali generati dall’AI rischia di erodere la credibilità e l’integrità della ricerca, introducendo affermazioni false, errori e persino contenuti inventati.

«C’è una certa ironia nel fatto che si celebri l’entusiasmo per l’AI che trasforma altri settori, quando in realtà il nostro campo ha vissuto un’esperienza caotica proprio a causa dell’uso diffuso dell’AI», dichiara al Financial Times Inioluwa Deborah Raji, ricercatrice all’Università della California, Berkeley.

I numeri dell’AI nella ricerca scientifica

Studi recenti mostrano quanto la tecnologia sia penetrata nella ricerca sull’AI stessa. Ad agosto, un’analisi della Stanford University ha rilevato che fino al 22% degli articoli di informatica includeva l’uso di LLM.

Un’analisi della start-up Pangram ha stimato che il 21% delle revisioni alla International Conference on Learning Representations (ICLR) del 2025 fosse interamente generato dall’AI, mentre oltre la metà mostrava un qualche utilizzo, ad esempio per l’editing. Tra gli articoli inviati, il 9% conteneva più della metà del testo prodotto da modelli automatici.

Errori, allucinazioni e paper sospetti

Nel novembre scorso, i revisori di ICLR hanno segnalato un articolo sospettato di essere generato dall’AI che era riuscito a entrare nel 17% migliore delle presentazioni in base ai punteggi.

A gennaio, la start-up GPTZero ha pubblicato una ricerca secondo cui alla conferenza NeurIPS del 2024 – considerata la più prestigiosa nel campo – sono stati individuati oltre 100 errori generati dall’IA in 50 articoli.

Regole più severe e sanzioni

Le crescenti preoccupazioni hanno spinto ICLR ad aggiornare le linee guida sull’uso dell’AI, introducendo l’obbligo di dichiarare un utilizzo “esteso” dei LLM, pena il rigetto dell’articolo.

Anche i revisori che produrranno valutazioni di bassa qualità generate dall’IA potranno essere sanzionati, fino al rifiuto delle proprie future submission.

«Se pubblichiamo articoli di pessima qualità e sbagliati, perché la società dovrebbe fidarsi di noi come scienziati?», afferma Hany Farid, professore di informatica all’Università della California, al Financial Times.

Pubblicare di più, non meglio

Secondo gli esperti, il numero di articoli prodotti da ricercatori in AI è cresciuto in modo evidente. NeurIPS ha ricevuto 21.575 presentazioni nel 2025, contro le 17.491 del 2024 e le 9.467 del 2020. Un singolo autore ha presentato oltre 100 articoli, un dato anomalo rispetto alla media.

Anche arXiv ha registrato un forte aumento dei paper in informatica, spiega Thomas G. Dietterich, professore emerito alla Oregon State University e responsabile della sezione computer science della piattaforma.

Difficile distinguere l’umano dall’automatico

Stabilire se l’aumento sia dovuto all’uso dei LLM o a una crescita reale della comunità scientifica resta complesso. Mancano standard condivisi e metodi affidabili per individuare i contenuti generati dall’AI.

«Un segnale tipico sono le citazioni inventate o le figure sbagliate», spiega Dietterich. In questi casi, gli autori possono essere temporaneamente banditi da arXiv.

Incentivi distorti e cultura della quantità

Secondo alcuni esperti, l’uso massiccio dei LLM – spinto da incentivi commerciali – ha rafforzato una cultura orientata alla quantità più che alla qualità.

«Quando ci sono demo spettacolari, stipendi altissimi e aziende che impazziscono, è inevitabile che arrivi un’ondata di interesse esterno», osservato Raj.

Come usare l’AI senza perdere rigore

Gli scienziati riconoscono che esistono utilizzi legittimi dell’AI, come supporto al brainstorming o alla revisione linguistica.

«La qualità dell’inglese nei paper provenienti dalla Cina è migliorata drasticamente, e suppongo sia perché i LLM sono molto bravi a rendere fluente il testo», afferma Dietterich.

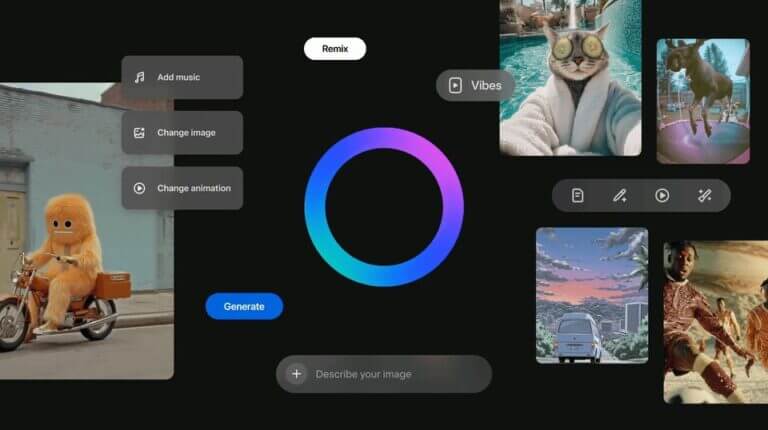

Ma con aziende come Google, Anthropic e OpenAI che promuovono i loro modelli come “co-scienziati”, cresce l’urgenza di definire limiti chiari.

Il rischio di un’AI che impara dall’AI

I modelli vengono spesso addestrati su dati accademici. Se questi includono quantità crescenti di articoli generati dall’AI, il risultato potrebbe essere un degrado delle prestazioni.

Ricerche precedenti mostrano che i LLM tendono a “collassare” e produrre testi incoerenti quando vengono addestrati su troppi dati sintetici non curati.

«C’è un incentivo per le aziende che raccolgono dati indiscriminatamente a voler sapere se questi articoli non siano generati dall’AI», avverte Farid.

“Un acceleratore potente, ma non una scusa”

Kevin Weil, responsabile scientifico di OpenAI, ricorda che i LLM sono strumenti come gli altri. «Possono essere un acceleratore enorme per esplorare nuovi ambiti – dice, ma vanno verificati. Non sollevano dal rigore scientifico».