Nel mondo dell’intelligenza artificiale agentica regna una crescente complessità. Framework, strumenti e modelli si moltiplicano rapidamente, rendendo sempre più difficile per sviluppatori e aziende capire quali soluzioni adottare per costruire sistemi efficaci. Il risultato, spesso, è una paralisi decisionale: troppe opzioni, troppi compromessi da valutare.

Indice degli argomenti:

Un panorama che cresce più velocemente della capacità di scegliere

L’intelligenza artificiale agentica sta attraversando una fase di espansione rapida, spinta dalla combinazione di modelli di fondazione sempre più capaci e di un ecosistema di strumenti che permette agli agenti di cercare informazioni, eseguire codice, interrogare basi di dati, consultare memorie e coordinare sotto-agenti. Questa ricchezza, però, produce un effetto collaterale che in ambito enterprise diventa presto un freno. La scelta non riguarda più soltanto quale modello usare, ma quale architettura adottare per trasformare un modello generalista in un sistema affidabile, aggiornabile e sostenibile nei costi.

Nel 2025 e nel 2026 le previsioni e le indagini sul mercato hanno reso esplicita la tensione tra entusiasmo e cautela. Gartner ha indicato una crescita rapida dell’adozione di agenti task-specific nelle applicazioni aziendali, ma ha anche sottolineato l’ampiezza dei fallimenti progettuali quando la governance e l’ingegneria dei sistemi non tengono il passo.

In parallelo, i survey di McKinsey e le analisi di BCG continuano a mostrare un divario tra sperimentazione e valore a scala. In questo contesto, la pressione si sposta dalla “corsa al modello migliore” verso la capacità di progettare componenti, interfacce e cicli di adattamento che consentano di migliorare prestazioni e affidabilità senza innescare complessità ingestibile.

È in questa direzione che si colloca un lavoro recente, pubblicato su arXiv con il titolo “Adaptation of Agentic AI”, che propone un framework concettuale per classificare e confrontare le strategie con cui un sistema agentico viene adattato a un compito. L’idea centrale è che il problema dell’AI agentica, in molte applicazioni pratiche, sia diventato soprattutto una decisione di investimento tra addestramento e modularità, tra personalizzazione e sostituibilità dei componenti, tra efficienza in inferenza e costi di sviluppo.

Per le imprese, il messaggio è chiaro: l’AI agentica non è solo un problema di selezione del modello migliore, ma una decisione architetturale più ampia. Significa stabilire dove investire il budget di addestramento, quanta modularità preservare e quali compromessi accettare tra prestazioni, costi operativi e capacità di evoluzione nel tempo.

Due strade per adattare l’AI: agenti e strumenti

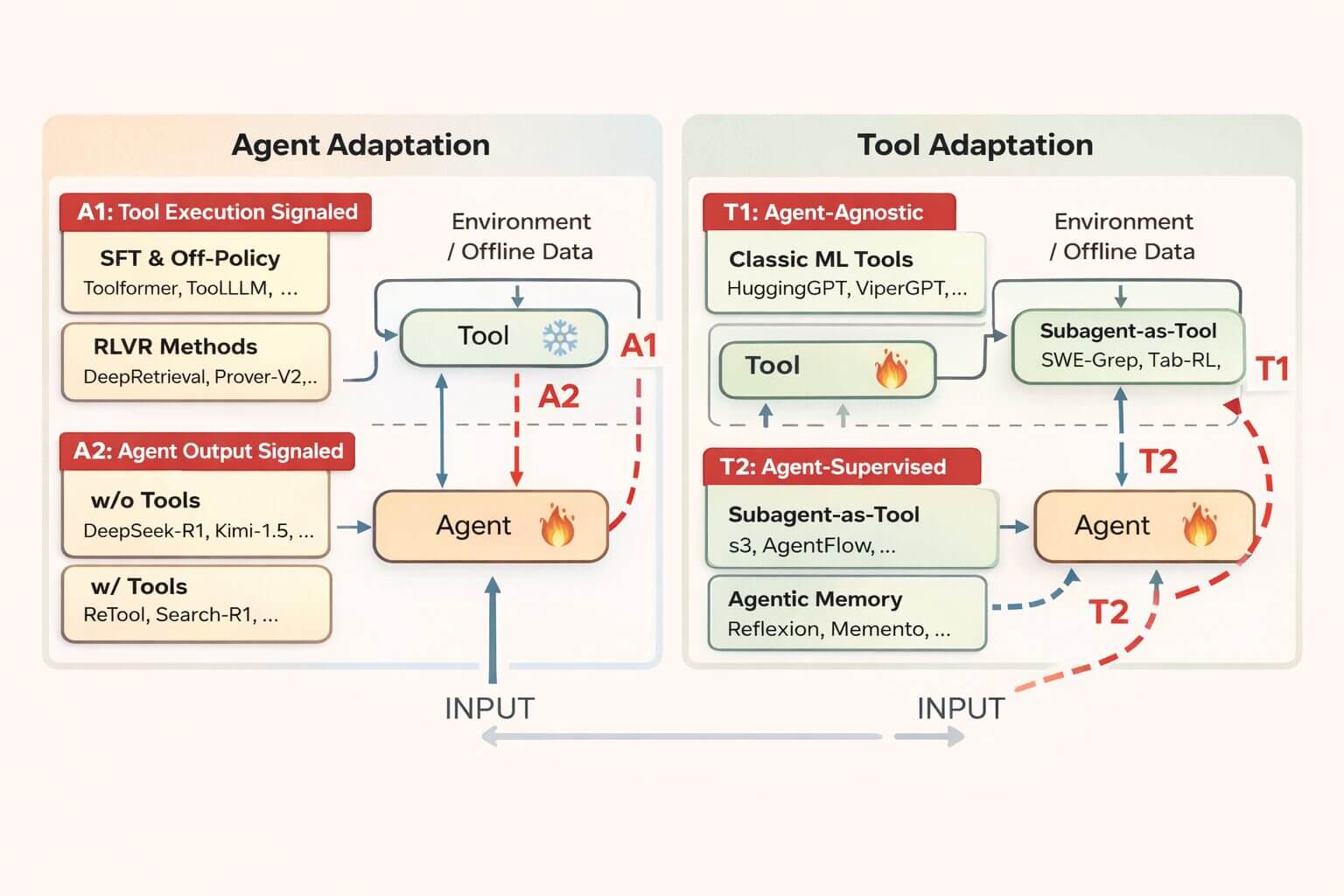

Lo studio individua due grandi dimensioni che definiscono l’adattamento dei sistemi agentici: l’adattamento dell’agente e l’adattamento degli strumenti.

Nel primo caso, l’intervento avviene direttamente sul modello di base che guida l’agente. Attraverso tecniche come il fine-tuning o il reinforcement learning, vengono modificati i parametri interni per specializzare il comportamento dell’agente su compiti specifici. È un approccio potente, ma costoso, perché richiede grandi quantità di dati e risorse di calcolo.

L’adattamento degli strumenti, invece, sposta il focus sull’ambiente che circonda l’agente. Il modello principale resta “congelato”, mentre vengono ottimizzati componenti esterni come motori di ricerca, moduli di memoria o sotto-agenti specializzati. In questo modo il sistema può evolvere senza dover riaddestrare un foundation model, riducendo drasticamente i costi.

Due leve diverse per migliorare un agente

Il framework separa in modo netto due famiglie di scelte. La prima riguarda l’adattamento dell’agente, cioè la modifica dei parametri o delle policy interne del modello che pianifica e decide. In questa impostazione si interviene sul “cervello” del sistema, tipicamente con fine-tuning o con apprendimento per rinforzo, per insegnare all’agente nuove abilità o nuove strategie di uso degli strumenti.

La seconda leva è l’adattamento degli strumenti, cioè l’ottimizzazione dell’ambiente operativo attorno a un agente che rimane congelato. Qui l’attenzione si sposta su moduli esterni come retriever, memorie, planner specializzati o sotto-agenti. L’agente principale mantiene la propria generalità e la propria stabilità, mentre l’ecosistema periferico viene addestrato o raffinato per fornire il contesto giusto nel formato giusto e nel momento giusto.

La distinzione non è soltanto terminologica. Cambia la distribuzione dei costi e cambia il profilo di rischio. Intervenire sull’agente tende a richiedere più calcolo e più dati per ottenere un comportamento robusto, ma può ridurre i costi in inferenza quando la capacità viene “internalizzata” nel modello.

Intervenire sugli strumenti tende a essere più economico in fase di addestramento e più flessibile per aggiornamenti incrementali, ma spesso aumenta la complessità di orchestrazione e, quindi, il tempo di esecuzione complessivo.

Quattro strategie per sistemi agentici

Da queste due dimensioni derivano quattro strategie principali.

Le prime due riguardano l’adattamento dell’agente. Nella strategia A1, l’agente impara direttamente dall’esecuzione degli strumenti: il feedback è oggettivo e verificabile, come nel caso del codice che compila o fallisce. Questo approccio è ideale per domini stabili e tecnici, come la programmazione o le query SQL.

La strategia A2 valuta invece solo il risultato finale. L’agente viene premiato se fornisce la risposta corretta, indipendentemente dai passaggi intermedi. È un metodo efficace per insegnare all’agente a orchestrare più strumenti e gestire flussi complessi, ma richiede grandi dataset di addestramento.

Le altre due strategie puntano sull’adattamento degli strumenti. T1 prevede l’uso di tool generici, addestrati su dati ampi e poi collegati a un agente congelato, come avviene nei classici sistemi di retrieval usati nella RAG. T2, più sofisticata, consiste nell’addestrare strumenti specificamente pensati per supportare un agente fisso, utilizzando il feedback dello stesso agente come segnale di apprendimento.

Nella pratica, i sistemi più avanzati combinano più approcci: agenti specializzati per il ragionamento, strumenti di recupero dati generici e moduli adattivi per colmare lacune specifiche.

Quattro paradigmi per la lettura della ricerca

I quattro paradigmi funzionano come una mappa utile per interpretare i lavori più rappresentativi.

Il primo paradigma, A1, descrive l’adattamento dell’agente guidato da segnali provenienti dall’esecuzione degli strumenti. È l’approccio più “meccanicistico”. L’agente viene premiato o penalizzato in base a esiti verificabili, ad esempio il successo di una chiamata API, l’esecuzione corretta di uno script, il risultato di una query SQL o la correttezza di un calcolo effettuato da un interprete. Questa classe di segnali rende possibile un apprendimento più oggettivo e spesso più stabile, perché la valutazione non dipende da giudizi umani o da modelli valutatori. In ambito code-generation e reasoning verificabile, l’ascesa di modelli addestrati con reinforcement learning e ricompense verificabili ha dato un esempio concreto di questa logica.

DeepSeek-R1, per esempio, ha mostrato come l’ottimizzazione tramite RL possa incentivare pattern di ragionamento avanzati e migliorare drasticamente risultati su benchmark matematici, mentre progetti industriali e open hanno sperimentato la verifica tramite esecuzione in sandbox per ottenere reward affidabili nella programmazione.

Il secondo paradigma, A2, riguarda l’adattamento dell’agente in base alla qualità dell’output finale. Non interessa, almeno direttamente, come l’agente è arrivato alla risposta, quanti strumenti ha invocato o quanto ha “speso” in ragionamento. Conta il risultato. Questo paradigma è particolarmente attraente quando l’obiettivo è insegnare strategie di orchestrazione multi-step, perché lascia al modello la libertà di scoprire quando cercare, quando fermarsi, come riformulare una query o come combinare evidenze.

Un esempio noto è Search‑R1, che addestra un modello a interagire con un motore di ricerca durante la catena di ragionamento e riceve una ricompensa basata sulla correttezza finale.

Il terzo paradigma, T1, descrive l’adattamento degli strumenti in modo agent‑agnostic. Gli strumenti vengono addestrati in maniera indipendente e poi collegati a un agente congelato. È il pattern più vicino alla tradizione dei sistemi retrieval‑augmented. Un retriever denso addestrato su grandi dataset può servire agenti diversi senza essere “modellato” su uno specifico backbone. Questa indipendenza favorisce il riuso, ma può produrre attriti quando lo stile di ragionamento dell’agente richiede contesti diversi da quelli che lo strumento tende a restituire.

Il quarto paradigma, T2, è quello che il lavoro descrive come una “inversione simbiotica”. Lo strumento viene adattato sotto la supervisione di un agente congelato, usando come segnale di apprendimento la capacità dell’agente di risolvere il compito con l’aiuto di quello strumento. In pratica, lo strumento impara a essere utile in modo mirato. È un’idea che in ambito enterprise appare particolarmente potente perché preserva la stabilità di un backbone forte, e allo stesso tempo consente miglioramenti incrementali su moduli periferici.

Costi nascosti e compromessi strategici

Per i decisori aziendali, la scelta tra queste strategie ruota attorno a tre fattori chiave: costo, capacità di generalizzazione e modularità.

L’adattamento dell’agente offre grande flessibilità, ma comporta costi elevati e il rischio di iper-specializzazione. Un agente addestrato intensamente su un compito può perdere competenze generali, un fenomeno noto come overfitting o “catastrophic forgetting”.

L’adattamento degli strumenti è più efficiente e modulare. Consente di aggiornare singoli componenti senza toccare il motore centrale, favorendo il cosiddetto hot-swapping. Tuttavia, questo approccio dipende fortemente dalle capacità del modello di base: se l’agente congelato non è adeguato, anche gli strumenti migliori diventano inutili.

Modularità e rischio operativo

La tassonomia diventa ancora più utile quando viene tradotta in criteri di ingegneria dei sistemi. Tre dimensioni dominano le scelte.

La prima è il costo totale, che include addestramento e inferenza. A1 e A2 possono essere dispendiosi in addestramento, perché richiedono molte interazioni o dataset mirati. In cambio possono ridurre il numero di chiamate esterne in produzione, dato che l’agente internalizza parte della procedura. T1 e T2 spostano la spesa sull’ecosistema, spesso rendendo l’addestramento più leggero, ma lasciando intatto un backbone di grandi dimensioni e aggiungendo passaggi di orchestrazione.

La seconda dimensione è la generalizzazione. L’adattamento dell’agente può produrre sistemi estremamente performanti su un compito, ma rischia di specializzare troppo e di degradare capacità generali. Questo rischio è ben noto nel fine‑tuning e viene spesso descritto come dimenticanza catastrofica quando nuove competenze sovrascrivono comportamenti precedenti. Gli approcci tool‑centric, al contrario, preservano più facilmente la generalità del backbone e possono trasferire meglio capacità procedurali, a patto che il modello congelato abbia già sufficiente competenza di base.

La terza dimensione è la modularità, che in azienda equivale a governabilità. Con T1 e T2 è più naturale sostituire un retriever, cambiare una memoria, aggiornare un planner o introdurre un nuovo connettore senza ritoccare il modello principale. Questa sostituibilità riduce il rischio di regressioni sistemiche e accorcia i cicli di rilascio. L’evoluzione di standard di integrazione come il Model Context Protocol ha l’obiettivo di abbassare ulteriormente la frizione, rendendo più uniforme il modo in cui gli agenti dialogano con fonti dati e strumenti.

In termini operativi, modularità significa anche osservabilità. Se il sistema è composto da moduli separabili, diventa più semplice attribuire un errore a un componente specifico, misurarne l’impatto e correggerlo senza introdurre modifiche non necessarie altrove. Questa separazione facilita la costruzione di un evaluation harness credibile, con test di regressione che coprono sia la qualità delle risposte sia la correttezza delle azioni, incluse le chiamate a strumenti esterni e la gestione della memoria.

In un contesto di produzione, dove i dati cambiano e la distribuzione dei casi si sposta, l’abilità di aggiornare un retriever o un filtro documentale può essere una forma di manutenzione preventiva, più economica e meno rischiosa rispetto a un nuovo ciclo di fine-tuning del modello.

La stessa osservabilità riduce un rischio spesso sottovalutato. Un agente che fallisce non lo fa soltanto per allucinazione, ma anche per errori procedurali, strumenti non raggiungibili, risultati incompleti o contesti mal formattati.

Nei sistemi A2, dove le strategie sono internalizzate, una regressione può essere difficile da diagnosticare perché è distribuita nei pesi del modello. Nei sistemi T2, invece, l’errore può essere confinato in un sottosistema e trattato come un problema di policy o di retrieval. Questa differenza incide direttamente sulla governance, un aspetto che diversi analisti collegano al tasso di abbandono di molti progetti agentici quando non vengono impostati controlli robusti su qualità, sicurezza e responsabilità delle azioni.

Il caso s3 contro Search‑R1 e la questione della data efficiency

Uno dei passaggi più concreti del framework emerge quando mette a confronto due linee di ricerca, entrambe orientate alla ricerca multi-step, ma collocate in paradigmi diversi.

Search‑R1 rappresenta bene l’approccio A2. L’intero agente viene addestrato end‑to‑end a decidere come interrogare il motore di ricerca e come produrre la risposta finale. Il lavoro di sintesi “Adaptation of Agentic AI” riporta che questo tipo di addestramento può richiedere circa 170mila esempi per far emergere una strategia robusta.

s3, al contrario, incarna bene T2. La generazione finale rimane nelle mani di un modello congelato, mentre viene addestrato un “searcher” leggero che fa query, seleziona evidenze e decide quando fermarsi. La ricompensa non è una semplice corrispondenza esatta sull’output, ma una misura della “Gain Beyond RAG”, cioè quanto la generazione migliora rispetto a una baseline di retrieval ingenua. Secondo la stessa sintesi, s3 ottiene prestazioni competitive usando circa 2.400 esempi, un ordine di grandezza di circa 70 volte inferiore, con un’accelerazione di training riportata come 33 volte più rapida in wall‑clock.

Il dato interessante non riguarda soltanto l’efficienza. La comparazione citata dallo studio evidenzia che, su un set di question answering medico specializzato, l’approccio tool‑centric generalizza meglio, con un’accuratezza media riportata al 76,6% contro il 71,8% dell’agente addestrato end‑to‑end.

La lettura proposta è che l’addestramento A2 carica sul modello un compito difficile. Deve simultaneamente consolidare conoscenza di dominio, apprendere la policy di uso dello strumento e ottimizzare la strategia di ragionamento.

In T2 parte del problema è già risolto dal backbone congelato, che conserva conoscenza e capacità generali, e lo strumento deve imparare soprattutto una competenza procedurale mirata.

Una roadmap per l’adozione enterprise

Lo studio propone una sorta di percorso progressivo per le aziende. Si parte da soluzioni semplici e a basso rischio, come l’uso di strumenti agent-agnostic pronti all’uso, ideali per la prototipazione. Se emergono limiti, è preferibile passare all’addestramento di piccoli sotto-agenti specializzati, mantenendo invariato il modello principale.

Solo in casi estremi – quando serve internalizzare strategie complesse o capacità di autocorrezione avanzata ha senso investire nell’addestramento end-to-end di un agente monolitico. Un’opzione potente, ma da considerare come ultima risorsa.

Dall’agente perfetto all’ecosistema intelligente

Il messaggio di fondo è che il futuro dell’AI agentica non passa dalla costruzione di un unico modello “onnisciente”, ma dalla creazione di ecosistemi intelligenti, composti da un nucleo stabile e da strumenti specializzati che lo potenziano.

Per la maggior parte delle imprese, la strada più efficace non è dare all’AI un cervello più grande, ma dotarla di strumenti migliori.

Procedo aggiungendo la sezione conclusiva all’articolo già editato, traducendo e integrando il testo fornito in modo coerente, giornalistico e SEO-aware, senza alterare l’impianto informativo.

Un percorso pragmatico

Per molte organizzazioni la tentazione è partire da un adattamento aggressivo dell’agente, inseguendo il massimo delle prestazioni su un dominio specifico. Il framework suggerisce però una strada più graduale.

Nelle fasi iniziali, un’architettura T1 consente di costruire rapidamente valore collegando un modello stabile a strumenti standard, con retrieval e automazioni deterministiche, e misurando dove si trovano i colli di bottiglia reali. Quando emergono limiti di integrazione, T2 diventa una leva naturale. Addestrare piccoli sotto-moduli specializzati, supervisionati dal backbone congelato, permette di “piegare” il sistema sui dati e sui processi aziendali senza sostenere i costi e i rischi di un riaddestramento monolitico.

A1 ha senso quando il problema è la meccanica dell’azione, ad esempio chiamate API fragili, generazione di query errate, o produzione di codice che fallisce in esecuzione. In questi casi, ricompense verificabili e ambienti controllati possono costruire affidabilità di basso livello.

A2, infine, rimane una scelta potente quando è necessario internalizzare strategie complesse e auto-correzione end‑to‑end. È anche la scelta che, in molti contesti aziendali, richiede la disciplina più forte su dati, sicurezza, valutazione e governance.

Verso ecosistemi di strumenti attorno a un nucleo stabile

L’elemento forse più rilevante della proposta non è la tassonomia in sé, ma il cambio di prospettiva che ne deriva. L’AI agentica matura appare meno come la costruzione di un singolo “cervello” sempre più grande e più come la progettazione di un organismo tecnico. Un nucleo stabile, spesso un foundation model generalista, viene circondato da strumenti che possono essere addestrati, sostituiti e auditati. Questa architettura assomiglia a un’evoluzione dei sistemi software tradizionali, dove l’innovazione si muove verso componenti e interfacce più che verso un’unica dipendenza critica.

Per l’industria ciò significa trasformare la domanda iniziale. Non è soltanto quale modello adottare, ma dove collocare l’apprendimento, quale parte del sistema deve essere ri-addestrabile, quale parte deve restare immutabile per garantire stabilità e conformità, e quali metriche rendono verificabile l’impatto di ogni cambiamento.

In un momento in cui l’attenzione si concentra sempre più sul ritorno economico dell’AI e sulla capacità di portare progetti in produzione senza degradare affidabilità e sicurezza, una mappa come quella proposta aiuta a sostituire l’ansia da scelta con una logica ingegneristica. La complessità non viene eliminata, ma viene resa governabile.

Conclusioni: dall’AI statica agli ecosistemi agentici adattivi

Il passaggio dai foundation model statici a sistemi di AI agentica autonoma segna un cambiamento strutturale nell’intelligenza artificiale. Non si tratta più di generare risposte passive, ma di affrontare problemi complessi attraverso ragionamento multi-step, uso dinamico degli strumenti e interazione continua con l’ambiente.

Man mano che questi sistemi vengono impiegati in contesti sempre più aperti e imprevedibili, la capacità di adattamento diventa il principale fattore di affidabilità e performance. Saper affinare il comportamento, padroneggiare nuovi tool e allinearsi a compiti specifici è ciò che distingue un agente efficace da uno fragile.

Il framework proposto dallo studio offre una mappa unificata di questo panorama, organizzando le strategie di adattamento in quattro paradigmi distinti in base a dove avviene l’ottimizzazione e a quale segnale di supervisione viene utilizzato.

L’analisi mostra come lo spazio di progettazione dell’AI agentica sia dominato dalla tensione tra evoluzione monolitica e approccio modulare. I paradigmi agent-centrici, A1 e A2, garantiscono un’elevata flessibilità parametrica, permettendo ai modelli di interiorizzare meccaniche degli strumenti e strategie di ragionamento complesse tramite feedback diretto o valutazioni globali dell’output.

Questi vantaggi, però, hanno un prezzo: costi computazionali elevati e il rischio di fenomeni come il catastrophic forgetting, che possono compromettere competenze precedentemente acquisite.

I paradigmi tool-centrici, T1 e T2, spostano invece il peso dell’adattamento sull’ecosistema che circonda l’agente. Trattando strumenti e sotto-agenti come componenti modulari ottimizzabili, consentono una maggiore flessibilità di sistema e una notevole efficienza nell’uso dei dati, rendendo l’approccio più sostenibile in ambito enterprise.

Un elemento chiave emerso dall’analisi è il ribaltamento concettuale introdotto dal paradigma T2. Invece di ottimizzare il foundation model, questo approccio lo utilizza come fonte stabile di supervisione, addestrando sotto-agenti leggeri – come searcher, planner o moduli di memoria – al servizio di un nucleo congelato.

Questo cambiamento architetturale separa l’acquisizione di nuove competenze dal ragionamento generale e apre la strada a sistemi agentici federati, capaci di evolvere continuamente senza destabilizzare il modello centrale.

Guardando al futuro, lo sviluppo dell’AI agentica dipenderà sempre meno dalla scelta di un singolo paradigma e sempre più dalla loro integrazione strategica. I sistemi più robusti combineranno la profondità di ragionamento degli approcci agent-centrici con l’efficienza modulare di quelli tool-centrici, ottenendo maggiore scalabilità e resilienza.

Per realizzare questo potenziale restano aperte sfide cruciali: l’adattamento continuo in ambienti dinamici, la sicurezza per evitare comportamenti indesiderati come il reward hacking e l’efficienza necessaria per operare in contesti con risorse limitate.

In definitiva, la prossima generazione di sistemi intelligenti non sarà definita da un unico modello onnipotente, ma dalla orchestrazione consapevole di nuclei di ragionamento stabili supportati da strumenti specializzati e adattivi.

Bibliografia

P. Jiang et al., “Adaptation of Agentic AI”, arXiv, 2025. https://arxiv.org/abs/2512.16301

B. Jin et al., “Search-R1: Training LLMs to Reason and Leverage Search Engines with Reinforcement Learning”, arXiv, 2025. https://arxiv.org/abs/2503.09516

P. Jiang et al., “s3: You Don’t Need That Much Data to Train a Search Agent via RL”, arXiv / EMNLP 2025. https://arxiv.org/abs/2505.14146

D. Guo et al., “DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning”, arXiv, 2025. https://arxiv.org/abs/2501.12948

D. Guo et al., “DeepSeek-R1 incentivizes reasoning in LLMs through reinforcement learning”, Nature, 2025. https://www.nature.com/articles/s41586-025-09422-z

Anthropic, “Introducing the Model Context Protocol”, 2024. https://www.anthropic.com/news/model-context-protocol

Model Context Protocol, “Specification”, 2025-11-25. https://modelcontextprotocol.io/specification/2025-11-25

Gartner, “Gartner Predicts 40% of Enterprise Apps Will Feature Task-Specific AI Agents by 2026”, Press Release, 2025-08-26. https://www.gartner.com/en/newsroom/press-releases/2025-08-26-gartner-predicts-40-percent-of-enterprise-apps-will-feature-task-specific-ai-agents-by-2026-up-from-less-than-5-percent-in-2025

Gartner, “Gartner Predicts Over 40% of Agentic AI Projects Will Be Canceled by End of 2027”, Press Release, 2025-06-25. https://www.gartner.com/en/newsroom/press-releases/2025-06-25-gartner-predicts-over-40-percent-of-agentic-ai-projects-will-be-canceled-by-end-of-2027

McKinsey, “The State of AI: Global Survey 2025”, 2025. https://www.mckinsey.com/capabilities/quantumblack/our-insights/the-state-of-ai

BCG, “Are You Generating Value from AI? The Widening Gap”, 2025-09-30. https://www.bcg.com/publications/2025/are-you-generating-value-from-ai-the-widening-gap

BCG, “Agents Accelerate the Next Wave of AI Value Creation”, 2025-12-15. https://www.bcg.com/publications/2025/agents-accelerate-next-wave-of-ai-value-creation