In un recente studio, i ricercatori di OpenAI (in collaborazione con Georgia Tech) affermano che i modelli linguistici generano affermazioni false con fiducia perché vengono addestrati con metriche che premiano l’“indovinare” piuttosto che l’ammettere di non sapere. Secondo loro, i modelli sono come gli studenti: rispondono sempre, anche se incerti, perché così ottengono punteggio.

Indice degli argomenti:

Un problema che resiste al progresso

Nonostante i grandi passi avanti dei modelli linguistici come GPT-5, le allucinazioni rimangono una sfida irrisolta. OpenAI riconosce che, pur avendo ridotto il fenomeno nelle versioni più recenti, i chatbot continuano a generare affermazioni plausibili ma inesatte. È un limite strutturale che colpisce tutti i principali modelli linguistici oggi in uso.

Che cosa sono le allucinazioni

Con “allucinazione” si intende un’informazione inventata ma presentata come vera. Gli esempi abbondano: quando i ricercatori hanno chiesto a un chatbot il titolo della tesi di dottorato di Adam Tauman Kalai (coautore dello studio), il sistema ha fornito tre risposte differenti, tutte sbagliate. Alla domanda sulla sua data di nascita, il modello ha prodotto tre date, anch’esse errate.

Perché i modelli preferiscono indovinare

Il cuore del problema è il sistema di valutazione. Gli attuali metodi misurano le performance in base alla percentuale di risposte esatte, senza dare valore all’ammissione di incertezza. Di fatto, come in un test a scelta multipla, indovinare può portare punti, mentre lasciare in bianco equivale a un fallimento garantito.

Questo spinge i modelli a tentare la sorte anche quando non dispongono delle informazioni necessarie. Su migliaia di domande, un modello che “azzarda” apparirà più performante di uno più prudente.

Errori, risposte giuste e astensioni

Secondo OpenAI, le risposte possibili si dividono in tre categorie: corrette, errate e astensioni (“non lo so”). Nella realtà, gli errori sono peggiori delle astensioni, ma i sistemi di valutazione attuali trattano il silenzio come un difetto. È qui che occorre un cambio di paradigma.

OpenAI sottolinea che l’astensione è parte integrante dell’umiltà, uno dei valori chiave dell’azienda. Meglio riconoscere i limiti che fornire informazioni sbagliate con convinzione.

La strada verso modelli più affidabili

Per ridurre le allucinazioni, OpenAI propone di aggiornare le metriche di valutazione, premiando l’ammissione di incertezza e scoraggiando le risposte inventate. È una trasformazione culturale: dalle performance basate sull’“avere sempre un’opinione” a un approccio più trasparente e responsabile.

Secondo i ricercatori, solo così i chatbot potranno diventare strumenti più affidabili per gli utenti, capaci di distinguere tra conoscenza certa e zone d’ombra.

Accuratezza vs errori: una falsa dicotomia

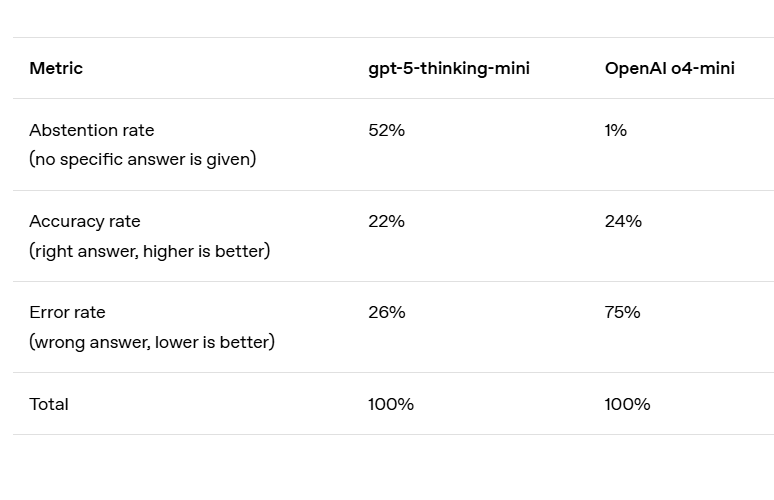

In termini di accuratezza, il vecchio modello OpenAI o4-mini ottiene risultati leggermente migliori. Tuttavia, il suo tasso di errore – cioè il numero di allucinazioni – è significativamente più alto. In altre parole, indovinare strategicamente quando non si è certi può migliorare la percentuale di risposte corrette, ma al costo di un numero molto maggiore di errori.

La maggior parte delle valutazioni si concentra esclusivamente sull’accuratezza, creando una dicotomia artificiale tra giusto e sbagliato. In test semplici, come SimpleQA, alcuni modelli raggiungono quasi il 100% di risposte corrette, eliminando di fatto le allucinazioni. Ma nelle valutazioni più complesse – e soprattutto nell’uso reale – l’accuratezza non può superare certe soglie, perché ci sono domande prive di risposta determinabile: informazioni mancanti, limiti cognitivi dei modelli più piccoli o ambiguità che richiedono chiarimenti.

Ciononostante, le leaderboard continuano a privilegiare solo l’accuratezza. Questo incentiva gli sviluppatori a costruire modelli che “rischiano” piuttosto che trattenersi, spiegando perché, anche con modelli più avanzati, le allucinazioni persistono: risposte sbagliate date con troppa sicurezza.

Errori, risposte giuste e astensioni

Secondo OpenAI, le risposte possibili si dividono in tre categorie:

- corrette

- errate

- astensioni (“non lo so”).

Nella realtà, gli errori sono peggiori delle astensioni, ma i sistemi di valutazione attuali trattano il silenzio come un difetto. È qui che occorre un cambio di paradigma.

OpenAI sottolinea che l’astensione è parte integrante dell’umiltà, uno dei valori chiave dell’azienda. Meglio riconoscere i limiti che fornire informazioni sbagliate con convinzione.

La strada verso modelli più affidabili

Per ridurre le allucinazioni, OpenAI propone di aggiornare le metriche di valutazione, premiando l’ammissione di incertezza e scoraggiando le risposte inventate. È una trasformazione culturale: dalle performance basate sull’“avere sempre un’opinione” a un approccio più trasparente e responsabile.

Secondo i ricercatori, solo così i chatbot potranno diventare strumenti più affidabili per gli utenti, capaci di distinguere tra conoscenza certa e zone d’ombra.

Soluzione: ripensare le metriche di valutazione

La chiave per contrastare le allucinazioni è intervenire sul sistema di valutazione, non semplicemente aggiungere nuovi test. OpenAI suggerisce marchi che penalizzino severamente le risposte sbagliate con fiducia e incoraggino l’ammissione di incertezza. In blog e comunicazioni, l’azienda sottolinea la necessità di aggiornare gli evals basati sull’accuratezza per scoraggiare il “guessing”.

La RAG (Retrieval Augmented Generation) può essere d’aiuto contro le allucinazioni

Il meccanismo del “premio all’indovinare” spinge i modelli a rispondere sempre, anche senza certezza. Livescience nota che con modelli sempre più evoluti, le allucinazioni possono aumentare. Per contrastarle suggerisce: generazione assistita da fonti esterne (RAG), meccanismi di verifica interna, e la capacità di esprimere incertezza.

In un articolo del 2024, la testata Wired osservava che le allucinazioni nascono anche dalla compressione dei dati: i modelli perdono dettagli e creano risposte plausibili ma errate.

Le allucinazioni rappresentano un rischio serio, specialmente in ambiti critici come medicina, finanza o diritto. Anche se eliminarle completamente può essere irrealistico, i modelli che sanno quando tacere potrebbero diventare più affidabili.

Come nascono le allucinazioni dalla predizione della parola successiva

Abbiamo già parlato del perché le allucinazioni siano così difficili da eliminare, ma da dove provengono, in concreto, queste imprecisioni fattuali così specifiche? Dopotutto, i grandi modelli pre-addestrati raramente commettono altri tipi di errori, come sbagli ortografici o parentesi non chiuse. La differenza riguarda il tipo di schemi presenti nei dati.

I modelli linguistici imparano inizialmente attraverso il pre-training, un processo basato sulla predizione della parola successiva in enormi quantità di testi. A differenza dei problemi di machine learning tradizionali, qui non ci sono etichette “vero/falso” associate a ciascuna affermazione. Il modello vede soltanto esempi positivi di linguaggio fluente e deve approssimare la distribuzione complessiva.

Diventa doppiamente difficile distinguere affermazioni valide da quelle non valide quando non esistono esempi etichettati come sbagliati. Ma anche con delle etichette, alcuni errori sono inevitabili. Per capirlo, consideriamo un’analogia più semplice: nel riconoscimento di immagini, se milioni di foto di gatti e cani vengono etichettate come “gatto” o “cane”, gli algoritmi possono imparare a classificarle con affidabilità.

Ma immaginate invece di etichettare ogni foto dell’animale domestico con la sua data di compleanno. Poiché i compleanni sono essenzialmente casuali, questo compito produrrebbe sempre errori, indipendentemente da quanto sofisticato sia l’algoritmo.

Lo stesso principio vale per il pre-training: ortografia e parentesi seguono schemi regolari, quindi gli errori in questi ambiti tendono a scomparire con la scala. Ma fatti arbitrari e rari, come il compleanno di un animale, non possono essere predetti soltanto dai pattern nei dati e finiscono quindi per generare allucinazioni. L’analisi spiega quali tipi di allucinazioni dovrebbero sorgere dalla predizione della parola successiva. Idealmente, le fasi successive all’addestramento dovrebbero eliminarle, ma questo processo non è del tutto efficace per le ragioni già discusse nella sezione precedente.

Conclusioni

Ecco alcune argomentazioni presentate nel paper di OpenAI che chiariscono la natura delle allucinazioni e aiutano a correggere alcuni fraintendimenti comuni:

Affermazione: per misurare le allucinazioni basta un buon test dedicato.

Risultato: esistono già test di valutazione delle allucinazioni. Tuttavia, hanno scarso effetto quando si scontrano con centinaia di metriche tradizionali basate solo sull’accuratezza, che penalizzano l’umiltà e premiano l’azzardo. Invece, tutte le metriche di valutazione principali devono essere ripensate per premiare l’espressione dell’incertezza.

Affermazione: le allucinazioni spariranno migliorando l’accuratezza, perché un modello con il 100% di accuratezza non allucina.

Risultato: l’accuratezza non raggiungerà mai il 100%, perché alcune domande reali sono intrinsecamente impossibili da rispondere, a prescindere da dimensione del modello, capacità di ricerca o di ragionamento.

Affermazione: le allucinazioni sono inevitabili.

Risultato: non lo sono, perché i modelli linguistici possono astenersi quando sono incerti.

Affermazione: evitare le allucinazioni richiede un livello di intelligenza raggiungibile solo con modelli più grandi.

Risultato: può essere più facile per un modello piccolo conoscere i propri limiti. Per esempio, se gli si chiede di rispondere a una domanda in māori, un modello che non conosce affatto la lingua può semplicemente dire “non lo so”, mentre un modello che conosce solo un po’ di māori deve stimare il proprio grado di sicurezza. Come discusso nel paper, essere “calibrati” richiede molta meno potenza computazionale rispetto all’essere accurati.

Affermazione: le allucinazioni sono un misterioso glitch dei moderni modelli linguistici.

Risultato: comprendiamo i meccanismi statistici attraverso i quali le allucinazioni emergono e vengono persino premiate nelle valutazioni.