Trascorso il periodo delle ferie, facciamo il punto della situazione per quanto riguarda l’AI Act europeo. Iniziando daI ritardo polacco e il rischio di infrazione. Varsavia non ha ancora nominato l’autorità di sorveglianza del mercato prevista dall’AI Act. Secondo l’esperta legale Maria Dymitruk, il mancato adempimento potrebbe portare a una procedura di infrazione da parte di Bruxelles. Il Regolamento, in vigore dal 1° agosto 2024, obbligava gli Stati membri a comunicare i loro organismi di controllo entro il 2 agosto 2025.

Pur senza un’autorità designata, le imprese polacche sono già vincolate al rispetto delle norme: eventuali violazioni sono sanzionabili. Il vuoto istituzionale rischia però di creare confusione, inducendo alcune aziende a credere che le regole non siano ancora operative.

Il vicepremier e ministro per gli Affari Digitali Krzysztof Gawkowski minimizza i rischi, ricordando che altri Stati membri sono ancora in ritardo e assicurando che il governo “farà tutto il possibile per attuare la legge in modo rapido ed efficace”. Una bozza di legge nazionale prevede l’istituzione della Commissione per lo Sviluppo e la Sicurezza dell’Intelligenza Artificiale (KRiBSI) come autorità di vigilanza.

Indice degli argomenti:

Chatbot e intimità: un vuoto normativo

L’AI Act non definisce chiaramente fino a che punto i chatbot possano favorire legami emotivi con gli utenti. Sam Altman, CEO di OpenAI, stima che meno dell’1% degli utenti di ChatGPT sviluppi una “relazione malsana” con il servizio. Una quota ridotta, ma che in termini assoluti potrebbe significare milioni di persone.

Il Regolamento vieta tecniche “deliberatamente manipolatorio o ingannevole” che possano causare “danno significativo”, ma resta il dubbio se i legami affettivi occasionali rientrino in questa soglia. Finora non ci sono stati interventi di enforcement.

Altre normative europee potrebbero applicarsi, come la Direttiva sulle pratiche commerciali sleali (UCPD) e il Digital Services Act (DSA), che vietano interfacce ingannevoli o manipolative. Tuttavia, come osserva Urs Buscke del BEUC, queste leggi riguardano soprattutto il design delle interfacce, non i contenuti conversazionali.

Il futuro Digital Fairness Act intende contrastare i “dark patterns” e i meccanismi di dipendenza, ma gli esperti avvertono: i legislatori non hanno ancora una piena comprensione dei rischi dell’AI emotivamente manipolativa.

Relazioni digitali e rischi sociali

Come nota Pieter Haeck (POLITICO), i chatbot-compagni, sempre disponibili e privi di giudizio, pongono nuove sfide. Se da un lato ridefiniscono l’idea di amicizia, dall’altro ripropongono dinamiche già viste con i social network o le app di dating: diffusione rapida, regolamentazione lenta, utenti vulnerabili esposti.

Alcuni episodi, che collegano chatbot a casi di suicidio o complotti criminali, hanno acceso i riflettori sulle lacune normative. L’AI Act obbliga i chatbot a dichiararsi artificiali, ma oltre a ciò gli obblighi restano vaghi.

Il quadro a rischio basato individua pratiche “inaccettabili” come la manipolazione subliminale e classifica come ad alto rischio i sistemi che incidono su salute, sicurezza e diritti fondamentali, ma solo dal 2026.

Eurodeputati come la verde olandese Kim van Sparrentak chiedono di includere esplicitamente i chatbot-compagni tra i sistemi ad alto rischio. I critici, però, segnalano che la normativa si concentra sui danni funzionali, trascurando quelli emotivi.

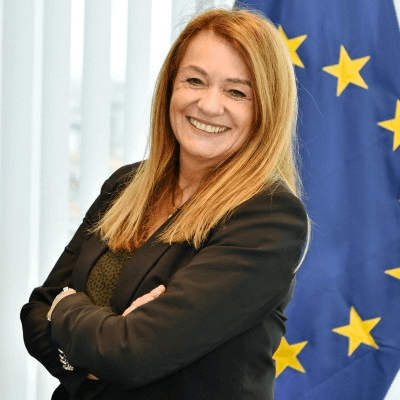

Dentro la strategia europea: la visione di Lucilla Sioli, direttrice dell’EU AI Office

In un’intervista, la direttrice dell’EU AI Office, Lucilla Sioli, ha spiegato come il Regolamento abbia posto le basi per un organismo incaricato di guidare la ricerca, l’innovazione e la catena del valore dell’AI, garantendo al contempo il rispetto delle regole.

L’Ufficio persegue due obiettivi intrecciati: stimolare la crescita economica europea tramite l’AI e rafforzare la fiducia attraverso la cornice del “trustworthy AI”. Coordina unità operative, finanzia progetti e sviluppa il Piano d’Azione Continentale sull’IA, con attenzione anche al trasferimento tecnologico verso il Sud globale.

Le norme più stringenti, tra cui quelle sulla trasparenza e i sistemi ad alto rischio, entreranno in vigore dal 2026, in base agli standard tecnici di CEN e CENELEC. La Commissione sta valutando se rinviare le scadenze.

Alle critiche americane di eccessiva regolamentazione, Sioli replica che il modello europeo riguarda solo il 10% delle applicazioni ad alto impatto sociale e sostituisce 27 regimi nazionali potenzialmente frammentati con un corpus unico.

L’AI Safety Unit cerca un assistente amministrativo

L’AI Safety Unit dell’EU AI Office cerca un assistente amministrativo per il Capo unità, con candidatura aperta fino al 15 settembre 2025.

La posizione riguarda la gestione organizzativa e documentale di Unit A3, che ha un ruolo cruciale: testare i modelli di AI generali, valutarne rischi e capacità, monitorare l’adesione al codice di condotta e collaborare con i principali fornitori globali. Il candidato ideale dovrà avere ottime competenze amministrative, conoscenza fluente dell’inglese, padronanza degli strumenti Office e familiarità con le procedure UE.